Die Berkeley Open Infrastructure for Network Computing (BONIC) ist eine Software-Plattform für verteiltes Rechnen.Die BOINC-Plattform wird an der Universität Berkeley entwickelt und ermöglicht es, vielen tausend Computern über das Internet oder Intranet verfügbar zu machen. Dies geschieht in Form von Projekten, die meist gemeinnützig arbeiten und von Universitäten oder anderen Institutionen betreut werden.

Der Super-Boinc-Rechner mit 16 Grafikkarten?

- Dieses Thema hat 613 Antworten und 41 Teilnehmer, und wurde zuletzt aktualisiert vor 6 Jahren, 9 Monaten von

Neron.

-

AutorBeiträge

-

-

13. November 2012 um 17:11 Uhr #929271

-

13. November 2012 um 17:11 Uhr #929268

Renovatio

TeilnehmerHey,eine sehr geile Idee. Mit dem runden Gehäuse machen wir alles richtig und bietet sicherlich dann auch genug Platz. Schön das auch die Beiträge im Forum sowie der Gruppe einbezogen wurde und das daraus was gemacht wurde. An welche Boards mit CPUs denkt ihr für die Grafikkarte einzusetzen?Andre

-

13. November 2012 um 17:11 Uhr #929269

konfetti

Teilnehmerhm, das erinnert mich ja irgendwie an die Cray-1Wo soll der dann stehen?

-

13. November 2012 um 17:11 Uhr #498901

ulv

TeilnehmerNachdem unsere CPU Version mit 84 Kernen mittlerweile schon über 1 Jahr läuft wird es langsam Zeit über die Grafikkarten-Version nachzudenken:

phil68 und ich haben mal ein wenig rumgesponnen wie ein würdiger Nachfolger aussehen könnte:

Ein rundes Gehäuse mit

4 x ITX

4 x PCIe Splitter

16 x GT640 alles an

1 x Netzteil mit einem

600er Lüfter

Das Bild war leider zu groß für den Scanner – es geht natürlich rund rum weiter.PS: Die Splitter sind schon erprobt und bremsen BOINC nicht aus.

-

13. November 2012 um 17:11 Uhr #929270

Kiro

Teilnehmerdie Idee gefällt mir und da ich die GraKa selber als Zweitkarte hab, find ich das super, da die Karte zwar zum Zocken bedingt geeignet ist, aber bei BOINC definitiv schneller rennt, als eine GTX 460 mit leichtem OC 😀

-

13. November 2012 um 18:11 Uhr #929273

isch

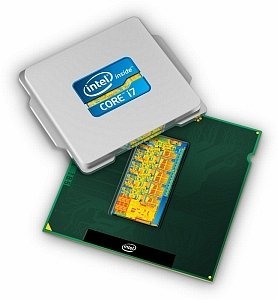

TeilnehmerGPUs sollten schon SingleSlot sein.Bei den CPUs kann ja ja nur so was wie der i7 3770 oder Xeon E3-1245V2 oder Xeon E3-1240V2Und der Splitter bremst das ganze nicht aus?Der muss ja ständig 4 Karten mit Daten versorgen.Für welche Projekte soll der dann laufen?

-

13. November 2012 um 19:11 Uhr #929275

ulv

TeilnehmerIst ja nur ein Entwurf.Jemand eine Idee wie wir das mechanisch überhaupt lösen können?Das muss ja möglichst einfach zu fertigen sein. Aber dennoch stabil genug.

-

13. November 2012 um 19:11 Uhr #929277

schannall

TeilnehmerHmm. Fräsen würde ich sagen. Aus einem Stück. Wenn ihr Irgendwo ein Riesen Alu/Metallblock rumliegen habt. Ansonsten Kirschholz o.ä. mit vielen Schrauben..Aber EIN Netzteil für 16 GraKas? Wird eng :)sC

-

13. November 2012 um 19:11 Uhr #929278

isch

TeilnehmerWenn ich am WE etwas Zeit habe mache ich mal ein paar Zeichnungen mit Sketchup.Macht es denn nicht mehr Sinn die Karten so wie die ITX zu Platzieren?Also vor jeden ITX 4 Karten.Dann sind zwar die ecken leer aber so sollte sich das besser kühlen lassen.

-

13. November 2012 um 20:11 Uhr #929280

phil68

Teilnehmer@ulvGenau so hatte ich mir das auch vorgestellt 🙂 Ich würde nur die Grakas parallel zum ITX verbauen. Graka würde ich diese nehmen: http://geizhals.de/794563… CPU siehe isch :d:

Aber EIN Netzteil für 16 GraKas? Wird eng

Die GT 640 verbraucht optimiert ca. 30W, sodass die Kiste ca. 700W(grob geschätzt)[eher weniger] verbrauchen wird.

Für welche Projekte soll der dann laufen?

POEM wäre natürlich in Bezug auf Credits der Hammer… zumal das ein Projekt ist, welches ich mehr als unterstützenswert halte. Das wären dann für den Rechner etwa 5-6Mio/Tag… selbst bei PG schmeißen die Karten immernoch ca. 1,8Mio/Tag… und wir hätten immernoch 16 Kerne für CPU Projekte :DGrüße Dirk

-

13. November 2012 um 20:11 Uhr #929285

isch

TeilnehmerDei ATi7750 sind mit den neuen Beta Treibern auch nicht zu verachten.Sollten von der c/W Performens her noch besser sein als die 640 aber brauchen halt etwas mehr.

Wenn WCG zu ende ist werde ich mal testen was da so geht 🙂

-

13. November 2012 um 21:11 Uhr #929289

Gillian

TeilnehmerDie Idee finde ich super…Bitte nicht gleich auf mich einschlagen, aber wenn je CPU vier Kerne eh für die GraKa’s ‘rechnen’ müssen, wäre dann nicht die Bulldozer Architektur auch interessant für uns? Preislich ja auf jeden Fall, oder wegen der TDP eher nicht?GrußGunnar

-

13. November 2012 um 21:11 Uhr #929288

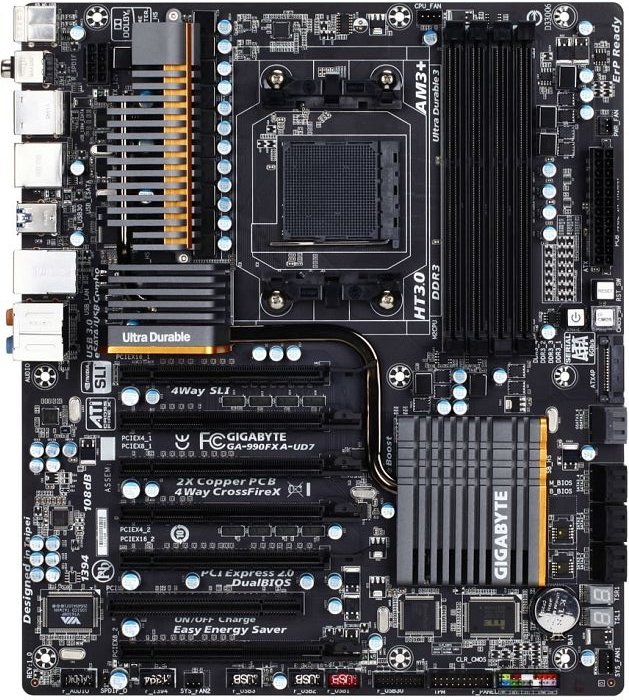

ulv

TeilnehmerHübsch wäre es schon, aber ……. ich hab mal eben nochmal nach ATX mit >= 4 PCIe geschaut:MB 100€ + CPU 30€Das kostet ja nicht mal die Hälfte vom Splitter alleine! :roll:4 solche und ein Lüfter und alles wäre sofort gut.Und weil die GT640 keinen Strom-Stecker hat wäre nicht ein einziges Kabel nötig.Was meint Ihr? Wie viel darf das Design kosten?

-

13. November 2012 um 22:11 Uhr #929292

isch

Teilnehmer@ ULV die CPU kannst vergessen.Bei 4 GPU braust 8 Kerne/Threads mit mindesten 3,3GHz sonst verhungern dir die GPUs.Die neuen Graka Projekte brauch leider teils viel CPU um die WU zu berechnen.@Gillian Die Bulldozer verbrauch leider viel zu viel.Das kannst fast 2 i7 betreiben.

-

13. November 2012 um 22:11 Uhr #929298

isch

TeilnehmerEine Karte braucht ca 30W sind also 120W:Ist sogar noch weniger als eine von deinen ATIs.DOPPELTE GENAUIGKEIT wird ja nur für einige wenige Projekte gebraucht.

-

13. November 2012 um 22:11 Uhr #929297

VTG01

TeilnehmerDie Idee finde ich gut, dennoch gilt es von Beginn an zu bedenken:

– Wie versorge ich die Grakas mit Strom – vom Board her wird das nichts werden mit so vieln GRAKAS, auch wenn die nur wenig Watt haben.

– Ich wurde eine Art von “Rack” vorschlagen, die man teilen kann und auf verschiedenen Standorten betreiben kann. Ich halte es für problematisch eine weitere Maschine mit 700W im Dauerbetrieb zu finanzieren. z.B. 4 Gehäuse mit je 4 Karten, die über LAN koppelbar und als 1 Rechner zu betreiben sind. (Betriebskosten /4, bzw. Energieeinsparung durch trennen von Gehäusen) Auch Kühlung und Bastelarbeit sollten sich dadurch in Grenzen halten ….

– Grundsätzlich stellt sich die Frage in wie weit die DOPPELTE GENAUIGKEIT bei Berechnungen eine Rolle spielt oder nicht. Meine 5 Garkas rechnen in 3 Rechnern (seit gestern Abend) und alle für doppelte Genauigkeit ausgelegt.

– Im gegensatz zu Prozessoren stelle ich mir den Aufwand für Kühlung deutlich schwieriger vor wenn man leistungsstarke Karten hat. Die Karten strahlen auch auf der “Rückseite” ordentlich Wärme ab, was dazu führt das der “Hintermann” deutlich mehr Aufwand für Kühlung hat. Ich rege an auf Querlüftung – also im rechten Winkel zu den Karten – die Hauptlüftung zu machen. In wie weit das Kabelgewirr und die Switche hier den Luftstrom hindern gilt es zu prüfen.

-

14. November 2012 um 8:11 Uhr #929301

Obi Wan

Administratorwarum wollte ihr diese Graka nehmmen -> GeForce GT 640 ?hat das einen Grund ?

-

14. November 2012 um 9:11 Uhr #929303

Sc0rp

TeilnehmerRe,

Kiro;499028 said:

die Idee gefällt mir und da ich die GraKa selber als Zweitkarte hab, find ich das super, da die Karte zwar zum Zocken bedingt geeignet ist, aber bei BOINC definitiv schneller rennt, als eine GTX 460 mit leichtem OC 😀Wie kommst du darauf?GTX460 = 907 GFlops SP und 75,6 GFlops DP (bei 160W)GT640 = 691,2 GFlops SP und 28,8 GFlops DP (bei 34W)Also die GTX460 (Werte hier ohne OC) schlägt bei der reinen Rechnenleistung die GT640. Allerdings sieht das bei Performance/Watt natürlich wesentlich besser für die GT640 aus, aber das erwartet man ja auch von einem zwei Generationen besseren Chip, oder?Den runden PC finde ich mal richtig innovativ – allerdings erzeugt das auch heftige Probleme, besonders beim Betreiben / Aufstellen. Bauen ist nicht das Problem (wenn mal kurz drüber nachdenkt was für Profis hier im Forum unterwegs sind *auf die DKM schiel*). 700W ist auch super für so ‘ne Maschine, hört sich für mich alles sehr stimmig an.Wenn man die GraKa’s parallel setzt, könnte man auch ein PICMG-Gehäuse (19 Zoll) nutzen, die haben auf der Rückseite mehr Slotbleche – und die ITX-Boards würden bequem übereinander passen (mit popeligen Abstandsbolzen ;)).Oder man nimmt dieses hier, und moddet die Rückwand (mehr Slots) und baut in die Front zwei 140er (160er) Lüfter …Sc0rp

-

14. November 2012 um 16:11 Uhr #929307

littledevil

TeilnehmerITX + Splitter halte ich auch für zu kostspielig.

Etwas mit matx und 3-4 Steckplätze sollte gut passen:

MSI Z68MA-G45 (G3) / MSI Z68MA-G45

Mit 3 Steckplätze und evtl. recht sparsam und vor allem schönkompakt:

ASUS P8H61-MXWie verhält es sich von der Performance zw. i5 und i7? Lohnt der i7 wirklich oder dann besser nur 2-3 Karten pro blade?

Ein i5-3350P, 4x 3.10GHz sieht preislich sehr gut aus. -

14. November 2012 um 19:11 Uhr #929310

Sc0rp

Teilnehmerphil68;499067 said:

Ncht ganz… die GTX 460 schafft bei POEM ungefähr 330-350k… die GT 640 liegen bei 360-380k.Der Grund dafür sind die Stream Prozzis… 338(GTX) vs. 384(GT).

Grüße Dirk

Jo Dirk … und was wäre bei OC?

Bzw. überhaupt der ganzen Takterei?

Woher nimmst du die Werte?

Ach ja, nicht zu vergessen: bei POEM only? Oder ist das generell so?

Wie sieht es (ganz aktuell) bei WCG-HCC@GPU aus?Das Thema interessiert mich ganz besonders, hab ja ‘ne EVGA GTX460SC am Laufen – und 30W vs. 160W sind schon ‘ne Hausnummer. Geplant ist ein GraKa-Upgrade auf eine GTX670 … da ich nebenbei auch zocke. Wenn sich eine GT640 fürs BOINCen rentiert, könnte ich die ja auch noch irgendwo reinklemmen …

Sc0rp

-

14. November 2012 um 19:11 Uhr #929311

isch

TeilnehmerEs sollte erst mal getestet werden ob x1 überhaupt reicht.Ich bin der Meinung das reicht hinten und vorn nicht.@Sc0rp bei WCG rennen die ATI 7xxx besonders gut.

-

14. November 2012 um 19:11 Uhr #929308

phil68

TeilnehmerSc0rp;499062 said:

Re,Kiro;499028 said:

die Idee gefällt mir und da ich die GraKa selber als Zweitkarte hab, find ich das super, da die Karte zwar zum Zocken bedingt geeignet ist, aber bei BOINC definitiv schneller rennt, als eine GTX 460 mit leichtem OC 😀Wie kommst du darauf?

GTX460 = 907 GFlops SP und 75,6 GFlops DP (bei 160W)

GT640 = 691,2 GFlops SP und 28,8 GFlops DP (bei 34W)

Also die GTX460 (Werte hier ohne OC) schlägt bei der reinen Rechnenleistung die GT640. Allerdings sieht das bei Performance/Watt natürlich wesentlich besser für die GT640 aus, aber das erwartet man ja auch von einem zwei Generationen besseren Chip, oder?Ncht ganz… die GTX 460 schafft bei POEM ungefähr 330-350k… die GT 640 liegen bei 360-380k.

Der Grund dafür sind die Stream Prozzis… 338(GTX) vs. 384(GT).

Grüße Dirk

-

14. November 2012 um 20:11 Uhr #929314

Sc0rp

TeilnehmerRe,

isch;499072 said:

Auch bei POEM/WCG mit den neuen Karten?Hat nix mit dem Projekt oder der Hardware an sich zu tun, sondern mit der Art wie GPGPU funktioniert – GPGPU braucht keine extravaganten Texturen zwischen Festplatte/Hauptspeicher und GraKa zu tauschen, daher braucht man hier keine breitbandige Anbindung. Die Steuerbefehle bzw. Daten die bei GPGPU ausgetauscht werden sind dagegen lachhaft klein …

Bildlich: kleines Arbeitspaket wird an die GraKa geschickt, die rechnet mordsmäßig und vor allem parallel das Paket durch (evtl. wird es im GraKa-RAM etwas aufgeblasen -> trotzdem lächerlich), dann geht ein kleines Ergebnispaket zurück …

Sc0rp

-

14. November 2012 um 20:11 Uhr #929312

Sc0rp

TeilnehmerRe,

isch;499070 said:

Es sollte erst mal getestet werden ob x1 überhaupt reicht.Ich bin der Meinung das reicht hinten und vorn nicht.Wurde bereits positiv getestet … durch Jabba (sofern ich mich richtig erinnere) -> es reicht Dicke. Die Rechenleistung bei GPGPU wird nicht durch den peripheren Bus gebremst.

isch;499070 said:

@Sc0rp bei WCG rennen die ATI 7xxx besonders gut.Jo, angeblich noch besser mit Beta-Treibern … aber ich werde auf meinem SCHLUMPF (AMD-System mit HD5850 für die Stube bzw. Frau) kein Beta-Treiber draufmachen und ganz sicher kommt MEIN Workstation-GraKa-Update vor dem meiner Frau :devil:!Sc0rp

-

14. November 2012 um 20:11 Uhr #929313

isch

TeilnehmerSc0rp;499071 said:

Re,isch;499070 said:

Es sollte erst mal getestet werden ob x1 überhaupt reicht.Ich bin der Meinung das reicht hinten und vorn nicht.Wurde bereits positiv getestet … durch Jabba (sofern ich mich richtig erinnere) -> es reicht Dicke. Die Rechenleistung bei GPGPU wird nicht durch den peripheren Bus gebremst.Sc0rp

Auch bei POEM/WCG mit den neuen Karten?

-

14. November 2012 um 21:11 Uhr #929316

phil68

TeilnehmerSc0rp;499069 said:

phil68;499067 said:

Ncht ganz… die GTX 460 schafft bei POEM ungefähr 330-350k… die GT 640 liegen bei 360-380k.Der Grund dafür sind die Stream Prozzis… 338(GTX) vs. 384(GT).

Grüße Dirk

Jo Dirk … und was wäre bei OC?

Bzw. überhaupt der ganzen Takterei?

Woher nimmst du die Werte?

Ach ja, nicht zu vergessen: bei POEM only? Oder ist das generell so?

Wie sieht es (ganz aktuell) bei WCG-HCC@GPU aus?Das Thema interessiert mich ganz besonders, hab ja ‘ne EVGA GTX460SC am Laufen – und 30W vs. 160W sind schon ‘ne Hausnummer. Geplant ist ein GraKa-Upgrade auf eine GTX670 … da ich nebenbei auch zocke. Wenn sich eine GT640 fürs BOINCen rentiert, könnte ich die ja auch noch irgendwo reinklemmen …

Sc0rp

Hi Chris 🙂

Die Werte für die GTX460 hab ich vom Projekt selbst(nach GTX460 gesucht). Die Werte der GT640 hab ich aus eigenem Bestand(2 Stück).

Weitere Tests hatte ich noch bei PG gefahren…

GTX560ti vs. GT640

160k vs. 115k pro TagFür die WCG HCC(GPU) WUs braucht die GT640 ca.11 Minuten.

Grüße Dirk

-

15. November 2012 um 15:11 Uhr #929324

konfetti

Teilnehmer11 Minuten? – meine GTX260 rechnet im schnitt bissl über 8 Minuten pro HCC GPU WUansonsten find ichs trotzdem interessant 😉

-

15. November 2012 um 16:11 Uhr #929328

ulv

TeilnehmerDa die laufenden Kosten bei 24/7 der größte Kosten-Anteil sind ist es extrem wichtig, dass der Rechner viele Credits/Watt macht. Nur danach sollten wir die GPU aussuchen.

Zur Verdeutlichung: Bei 20 Cent/Watt kosten 500 Watt Dauer-Last im Laufe von 2 Jahren fast 2000€!

-

15. November 2012 um 16:11 Uhr #929327

littledevil

Teilnehmerkonfetti;499083 said:

11 Minuten? – meine GTX260 rechnet im schnitt bissl über 8 Minuten pro HCC GPU WBei welchem, VErbrauch? 😆

-

15. November 2012 um 17:11 Uhr #929329

Sc0rp

TeilnehmerRe Dirk,

phil68;499075 said:

Für die WCG HCC(GPU) WUs braucht die GT640 ca.11 Minuten.Meine GTX460SC braucht zwischen 00:04:55 und 00:07:44 pro WCG-HCC@GPU-WU 😉 – klar, im Verbrauch schlägst du mich – aber nicht bei der absoluten Zeit 😉 -> schnella!

Wie kann man die GT640 eigentlich tunen? Kann man an der was “schrauben”? Preislich gehen die grade ab ca. 70€ über den Tisch, da könnte ich 2-3 noch in den Server schrauben ;).

Sc0rp

-

15. November 2012 um 18:11 Uhr #929331

phil68

TeilnehmerWie verhält es sich von der Performance zw. i5 und i7? Lohnt der i7 wirklich oder dann besser nur 2-3 Karten pro blade?Ein i5-3350P, 4x 3.10GHz sieht preislich sehr gut aus.

Wenn dann sollten wir einen I7 nehmen… Wenn es nur 4 Kerne sein sollen, kann man auch zum wesentlich billigerem I3 greifen. Der I3 3220 läuft sogar mit 3,3GHz und dürfte kaum langsamer(bei BOINC) sein als der I5(6MB Cache gegenüber 3MB des I3) :-k

Sc0rp;499088 said:

Re Dirk,phil68;499075 said:

Für die WCG HCC(GPU) WUs braucht die GT640 ca.11 Minuten.Meine GTX460SC braucht zwischen 00:04:55 und 00:07:44 pro WCG-HCC@GPU-WU 😉 – klar, im Verbrauch schlägst du mich – aber nicht bei der absoluten Zeit 😉 -> schnella!Wie kann man die GT640 eigentlich tunen? Kann man an der was “schrauben”? Preislich gehen die grade ab ca. 70€ über den Tisch, da könnte ich 2-3 noch in den Server schrauben ;).Sc0rp

😀 Ja, aber wie schon geschrieben… die GT640 braucht ohne Optimierung ca. 30Watt. Wenn dann mal das passende BIOS und Flash Tool auf den Markt kommt, lässt sich da sicher noch etwas mehr Effizienz rauskitzeln. Bei POEM schafft eine GTX 680 ca. 1Mio k pro Tag bei etwa 180 Watt und einem Anschaffungspreis von ca. 430€ !Die GT640 macht ca. 370k bei 30 Watt und kostet 70€ !!Mehr muss ich wohl nicht dazu sagen :+ d.h. halbe Anschaffungskosten… halber Preis… selbe Leistung!!!(um ähnliche Credits zu erreichen) So ist das eben bei BOINC… wir wollen, wie ulv schon geschrieben hat, die max. Credits bei so wenig wie möglich Verbrauch.Grüße Dirk

-

15. November 2012 um 20:11 Uhr #929337

isch

TeilnehmerPassen in den Splitter Dualslot Karten? man kann das auf dem Bild so schlecht erkennen und im Text habe ich auch nichts gelesen ( Oder verstanden 🙂 )

-

15. November 2012 um 20:11 Uhr #929335

phil68

Teilnehmerisch;499093 said:

Es muss ja ein i7 oder Xeon sein.Wenn auf jeder Graka nur 2WUs laufen und das bei 4 Grakas macht 8 WUs die ja dann auch gleichzeitig von der CPU berechnet werden müssen.Bei nur 4 Kernen würde da ein Stau entstehen und die Credits würden sich fast halbieren.

Genau… ganz vergessen, dass wir ja 4 Karten haben 🙂

-

15. November 2012 um 20:11 Uhr #929338

Sc0rp

TeilnehmerRe,

isch;499096 said:

Passen in den Splitter Dualslot Karten? man kann das auf dem Bild so schlecht erkennen und im Text habe ich auch nichts gelesen ( Oder verstanden 🙂 )Das ist ein PCIe-Splitter, der die Lanes aufteilt – ist hier irgenwo im Forum schonmal diskutiert und beschrieben worden. Der macht dann z.B. aus einem PCIe x4 viermal PCIe x1 und Stromversorgung könnte man quasi direkt an den Splitter löten. Es gibt welche mit einer festen Platine und welche mit Flachbandkabeln …EDIT: Google ist dein Freund: http://www.amfeltec.com/products/x4pcie-splitter4.phpSc0rp

-

15. November 2012 um 20:11 Uhr #929334

isch

TeilnehmerEs muss ja ein i7 oder Xeon sein.Wenn auf jeder Graka nur 2WUs laufen und das bei 4 Grakas macht 8 WUs die ja dann auch gleichzeitig von der CPU berechnet werden müssen.Bei nur 4 Kernen würde da ein Stau entstehen und die Credits würden sich fast halbieren.

-

15. November 2012 um 21:11 Uhr #929339

VTG01

Teilnehmer@isch

Das mit dem Verbrauch stimmt, meine beiden 5870er laufen leicht übertaktet bei 875mhz. Selbst bei diesen Aussentemperaturen ist eine Raumtemperatur von unter 20°C nicht möglich! Leistungsaufnahmetest mache ich am WE

@phil, @isch

Es kommt immer darauf an welche Projekte gerechnet werden und welches Ziel da ist. Ein GPU-Cruncher muss einfach nur GPU-Projekte rechen können. Dummerweise brauchen die aber doch immer wieder deutlich CPU. Somit schlage ich vor die einzelnen Grakas die in Frage kommen auf mehreren Projekten zu testen und mit den “Dauerbrennern” a la 5870, GTX… zu vergleichen. So kommt man dann relativ schnell auf ein Projekt bei dem eine deutlich “schwächere” Karte bei BOINC deutlich effizienter ist als die “Dauerbrenner”. Vielleicht ist es möglich dass sich ein paar Personen an den Tests beteiligen. Ich stelle mich mit dem I7, einen Q9400, sowie einen x4 gerne in die Testreihe mit einer 5850er, 5870er und der doch schon deutlich schwächeren 5770. 4 Rechner, 3 Karten 8 Projekte (oder mehr) können durchaus ein Ergebnis darstellen.

@ulv

Dein Hinweis zum Stromverbrauch finde ich ganz toll. Bei einem günstigen Board, günstigen Prozzi und günstigen Grakas sind die Betriebskosten innerhalb weniger Jahre bereits höher als die Anschaffungskosten!Frage in die Runde:

An einem Picu 160xt mit einem 190er Netzteil sollte es doch möglich sein 2 30Watt Grakas zu betreiben – der Rechner braucht Spitze um die 65 Watt. Habt ihr das schon mal probiert? Wenn ich in Geizhals schaue brauchen die GT640er jedoch alle um die 65 Watt, ihr sprecht oben vom 30 Watt – wie das?Ich könnte mir durchaus vorstellen in mein MSI Z77A-G45 an stelle der 2 5870 ein paar (nicht 2 sondern mehr) GTX 640 oder 7750er rein zu bauen. Ob wirklich 7 rein passen glaube ich nicht. 3x über PCIe x16 sind sicher kein Problem, aber die 4 über PCIe x1 brauchen doch auch noch Strom. insgesamt 7*30 Watt = 210 Watt sollte noch gehen aber 7* 60 Watt (lt. Datenblatt)= 420 Watt ist dann schon ein bisserl viel über den 2xP4 + 24Pin Stecker am Board. Auch das Netzteil mit 580Watt hat da ein bisserl Probleme da die Schienen nicht zusammengeschaltet werden können. Najy – vielleicht doch ein wenig Hirngespinst. 😆

-

15. November 2012 um 21:11 Uhr #929340

isch

TeilnehmerDas prinzip ist mir schon klar wollte nur wissen ob in diesen 4er x1 Tower Dualslot Karten passen oder nur Singleslot.

VTG01;499098 said:

@phil, @ischEs kommt immer darauf an welche Projekte gerechnet werden und welches Ziel da ist. Ein GPU-Cruncher muss einfach nur GPU-Projekte rechen können. Dummerweise brauchen die aber doch immer wieder deutlich CPU. Somit schlage ich vor die einzelnen Grakas die in Frage kommen auf mehreren Projekten zu testen und mit den “Dauerbrennern” a la 5870, GTX… zu vergleichen. So kommt man dann relativ schnell auf ein Projekt bei dem eine deutlich “schwächere” Karte bei BOINC deutlich effizienter ist als die “Dauerbrenner”. Vielleicht ist es möglich dass sich ein paar Personen an den Tests beteiligen. Ich stelle mich mit dem I7, einen Q9400, sowie einen x4 gerne in die Testreihe mit einer 5850er, 5870er und der doch schon deutlich schwächeren 5770. 4 Rechner, 3 Karten 8 Projekte (oder mehr) können durchaus ein Ergebnis darstellen.Das Problem bei den ATI 7xxx und NV 6xx Karten ist das bislang nur POEM und WCG davon Profitieren.Bei anderen Projekten sieht es dann nicht mehr ganz so rosig aus.

VTG01;499098 said:

Frage in die Runde:An einem Picu 160xt mit einem 190er Netzteil sollte es doch möglich sein 2 30Watt Grakas zu betreiben – der Rechner braucht Spitze um die 65 Watt. Habt ihr das schon mal probiert? Wenn ich in Geizhals schaue brauchen die GT640er jedoch alle um die 65 Watt, ihr sprecht oben vom 30 Watt – wie das?Ich habe eine und phil auch (siehe meine teste).Eine 7750 habe ich auch hier und wird nach der WCG Challenge ausführlich getestet.

-

16. November 2012 um 10:11 Uhr #929352

littledevil

Teilnehmerisch;499093 said:

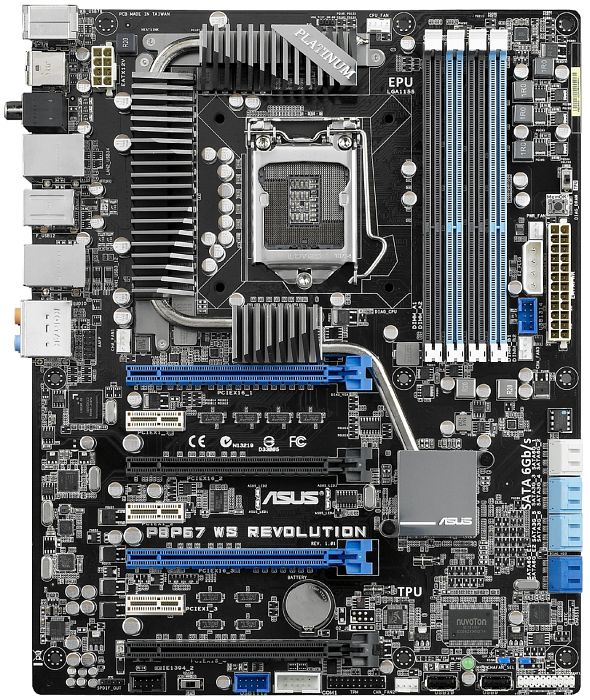

Es muss ja ein i7 oder Xeon sein.Wenn auf jeder Graka nur 2WUs laufen und das bei 4 Grakas macht 8 WUs die ja dann auch gleichzeitig von der CPU berechnet werden müssen.Wieviel Mehrleistung haben denn die 4 Pseodokerne tatsächlich?Es kommt ja auf dei tatsächliche GEschwindigkeit an und nciht nru dei Kernanzahl, oder?P.S. was haltet Ihr vom Asus P8P67 Pro B3 ?Da hat ein bucht-Händler ne ganze Menge da. Denke mal, das man die günstig schnappen könnte – habe die grad in Beobachtung3 Karten direkt stecken und die vierte über einen Riser auf x16

-

16. November 2012 um 16:11 Uhr #929374

isch

Teilnehmerlittledevil;499116 said:

isch;499093 said:

Es muss ja ein i7 oder Xeon sein.Wenn auf jeder Graka nur 2WUs laufen und das bei 4 Grakas macht 8 WUs die ja dann auch gleichzeitig von der CPU berechnet werden müssen.Wieviel Mehrleistung haben denn die 4 Pseodokerne tatsächlich?Es kommt ja auf dei tatsächliche GEschwindigkeit an und nciht nru dei Kernanzahl, oder?P.S. was haltet Ihr vom Asus P8P67 Pro B3 ?Da hat ein bucht-Händler ne ganze Menge da. Denke mal, das man die günstig schnappen könnte – habe die grad in Beobachtung3 Karten direkt stecken und die vierte über einen Riser auf x16

Ist ja egal wie viel Mehrleistung die 4HT Kerne haben.Wenn nur die 4 echten das sind werden auch nur 4 Threads ausgeführt und somit kannst nur auf jeder Graka 1 WU laufen lassen.Asus und Stromsparen widerspricht sich doch eigentlich.

-

16. November 2012 um 21:11 Uhr #929386

isch

TeilnehmerJa cpu power wird benötigt.da bringt ein hoher takt abhielfe.Bei 2 wus hast du fast die doppelten Kredits weil eine wu die GPU kaum auslastet.

-

16. November 2012 um 21:11 Uhr #929383

littledevil

TeilnehmerHattest Du nicht geschrieben, das da recht viel CPU power benötigt wird?

wieviel weniger Output hat dieGPU, wenn nur eine WU pro GPU gerechnet wird?

Vom verbrauch her bin ich mit meinem Asus P8H61-M LE/USB3 sehr zufrieden.

Ist vielleicht kein Rekordhalter, aber man kompfortabel undervolten ohne irgendwelche MOD-BIOS Tricks… 😀

Auf nem P8P67 Pro mit nem i7 könnte man dann 4 GPUs betreiben.

Hast Du mal versucht eine Graka mit x1 zu ebtreiben, um sicher zu gehen, das der Busspeed kaum eine Rolle spielt?

-

16. November 2012 um 22:11 Uhr #929387

ulv

TeilnehmerHier mal ein Bulldozer-Board wo definitiv 4 dual-Slot-Grakas ohne Basteln laufen: http://geizhals.de/646940

AMD CPUs sind im Vergleich zu Intel ja günstig… http://geizhals.de/761214

Das wären 350€ für Mainboard und 8-Kern-CPUIrgendwie ist mir das aber nicht recht, dass wir für das Mainboard mehr zahlen als für die Grakas. Auch verbraucht hier das Board vermutlich schon so viel Strom wie zwei der Grakas. Das macht doch keinen Sinn.

Wenn wir es doch mit Single Slot versuchen. :-k

30 Watt müsste doch gehen, wenn man den Lüfter weg schraubt, die Slotbleche weg schraubt und einfach von hinten dagegen bläst. Selbst mit Slotbelch sollte das mit einem Luft-Kanal bei so einer Low-Profile Karte doch gehen – oder? 🙄

Die Sparcle z.B: http://geizhals.de/796257Vorher müsste man aber noch prüfen, ob 7 oder 8 Karten von Boinc unter Linux (bzw. Windows) erkannt werden. Bei den Nvidia unter Linux könnte ich mir das schon vorstellen, weil die ja auch ohne X-Server, Dongle etc. laufen.

Und dann bleibt noch der Stromverbrauch im Non-PEG-Slot. Die haben ja nur 25 Watt nach der Spec.

3 (bzw. 4) der Karten müsste man also modden, damit sie die 12 Volt direkt aus dem Netzteil ziehen. Das wäre aber nicht so schwer zu machen. Ganz ohne Löten ist ja dann doch langweilig. O:-)@Dirk

Soll ich mal zum testen 2 oder 3 GT610 Modden (oder GT620) und dir zum testen schicken?

@All

Hat sonst jemand ein Board mit mehr als 4 PCIe (x16 physikalisch) und möchte das testen? -

16. November 2012 um 23:11 Uhr #929385

littledevil

TeilnehmerOb ein AMD 8-Kerne es schafft, 4 Karten halbwegs sparsam zu versorgen? :-kBei nem i7 1155 sehe ich da eher ne Chance z.b. ASUS P8P67 WS Revolution Rev 3.0 – wenn es ohne basteln sein mußWobei ein Riser-kabel nu auch nicht das Problem sein sollte. Da kann man dann gleich die Stromversorgung drüber laufen lassen… ;)Wenn man eh ne Stromversorgung basteln muß und x1 genügt: ASRock H61DEL

-

16. November 2012 um 23:11 Uhr #929391

isch

TeilnehmerAMD verbraucht einfach zu viel und fällt meiner Meinung nach komplett raus (leider :-((( )@ ULV Singleslot Karten gibt es doch wie Sand am Meer.Drück mich fest.Von den 610,620 und 630 Karten rate ich ab da das nur umgeläbelte 5xx Karten sind.Die werden auch noch in 40nm Hergestellt.Bei diesem Sockel 1155 Board gibt es:5x PCIe 3.0 x161x PCIe 2.0 x161x PCIe 2.0 x1Sind also schon mehr Slots als wir brauchen.Tante Edit:Hier ist mal ein erster versuch mit Sketchup.Ich hoffe man erkennt was es sein soll.Da ich nich sie Slotabstände vom Splitter kenne habe ich den Graka Block 25cm breit gemacht.Das kann noch mehr oder weniger sein was sich ja auf das außen maß der Gehäuses auswirkt.Jetzt hat es einen Durchmesser von 1m und ist 17cm hoch.

-

17. November 2012 um 11:11 Uhr #929395

littledevil

TeilnehmerFalls man das Board tatsächlich für ~100 eur bekommt, wäre das Sapphire PURE Black P67 Hydra

sehr interessant.Bei 4 Karten und nem i7 kämen man dann etwa mit 750 EUR pro blade exl. Netzteil heraus

-

17. November 2012 um 12:11 Uhr #929396

isch

TeilnehmerJa das sollte auch gehen.Nur wie sieht es bei den Boards mit dem verbrauch aus ?Müsste man ja vorher mal testen.Soll es jetzt doch ohne Splitter werden???

-

17. November 2012 um 13:11 Uhr #929399

VJoe2max

TeilnehmerDarf ich mich da mal bezüglich des Gehäusebaus einschalten?Mit den kleinen 7,5mm Alfer-Combitech-Profilen und Verbindern habe ich in anderer Sache mal was angefangen und bin erstaunt wie schnell und doch solide man damit eine Art Gehäuserahmen bauen kann. Für nicht tragende Wände bieten sich Hartschaumplatten an. Tür tragende Wände Alu-Platten. Die Verbindung erfolgt über Vernieten oder mit Einpressmuttern und Schrauben. Das Material lässt sich ist über den Shop schnell bestellen und wenn mal was fehlt, gibt´s viele Teile auch im Baumarkt. Ein sechseckiger Grundriss mit sechs ITX-Bords um einen Mittelblock und ein weiteres größeres Sechseck außen herrum, an dem die Grakas sitzen, wäre z.B. ne feine Möglichkeit, um sogar noch mehr Ausbaumöglichkeiten zu haben. Man könnte auch nur vier oder fünf aktive Abteilungen machen und die restlichen zum Anschließen nach außen hin oder zur Frischluftversorgung nutzen. Außen rund halte ich dagegen für recht schwierig machbar. Lasst es mich wissen, wenn es an ein Grundgerüst für das Gehäuse geht, falls es denn mit einer solchen Rahmenkonstruktion machbar sein sollte. Hab da jetzt einiges an Erfahrung gesammelt und könnte evtl. entweder das ganze Grundgerüst oder zumindest den Zusammenbau beisteuern ;). Ne Kappssäge zum exakten Ablängen der Profile (auch auch auf Gehrung in versch. Winkeln) habe ich ebenfalls da. Da ich inzwischen auch nicht mehr weit von München entfernt wohne, gäbe es auch kein Versandproblem etc. (gehe jetzt mal davon aus, dass das neue Gerät wieder seinen Standort in München haben wird).

-

17. November 2012 um 14:11 Uhr #929401

littledevil

TeilnehmerSpitze Joe 🙂 6-Eck dürfte auf jeden Fall einfacher zu realisieren sein, als rund.

@isch Splitter würden ja nur bei ITX Sinn machen, da wir rein CPU-mäßig ja eh nicht mehr als 4 GPUs pro i7 Versorgen können.

Da ein Splitter + Board aber 2-3x soviel kostet, wie ein Board, wäre es gut, wenn wir drauf verzichten könnten.

Vielleicht kann ja mal jemand bzgl. Sponsoring bei der Firma anfragen [-o< Das Sapphire P67 sieht zumindest nicht so vollgefrachtet mit Zusatzoptionnen und extrem OC-Features aus - köntne sich positiv auf den Verbrauch auswirken O:-) -

17. November 2012 um 17:11 Uhr #929409

isch

Teilnehmerlittledevil;499169 said:

@isch Splitter würden ja nur bei ITX Sinn machen, da wir rein CPU-mäßig ja eh nicht mehr als 4 GPUs pro i7 Versorgen können.Jein mit etwas tricksen an der App.info kannst auch 16 WUs laufen lassen wodurch aber die Wu Laufzeiten sich verlängern.Damit das nicht passiert müsste man wieder OC was den verbrauch ja wieder nach oben Treibt.Ob man dann mehr C/W bekommt müsste man testen.Das ASRock Z77 WS hat ja 6 x16 Slot die man bestücken könnte.Dafür bräuchte man 6Kerne/Threads und man könnte 12 WUs gleichzeitig rechen.Der CPU Takt müsste dann aber auf 4GHz.Vielleicht sollten wir uns erst mal einig werden ob mit Splitter oder Boards mit vielen Steckplätzen.Dann kann man sich auch mal Gedanken ums Gehäuse machen.

-

17. November 2012 um 20:11 Uhr #929418

isch

TeilnehmerPro WU 1 Kern bei 2 Wu pro Graka =2 Kernmit etwas Tricksen in der app.info2 WU pro Graka =1 Kern den eingesparten Kern kannst aber durch OC mit hohen Takt wieder ausgleichen.

-

17. November 2012 um 20:11 Uhr #929417

littledevil

TeilnehmerBenötigt man nun pro GPU 1 oder 2 Pseodo-Kerne?

-

18. November 2012 um 11:11 Uhr #929427

littledevil

TeilnehmerWie verteilt sich das bei 6 GPU und 8 Kernen?Ich denk mal, das 4 Karten pro Blade ein gute Kompromiss sein dürften.Sind eigentlcih alle Asrock B75 sparsam?ein andere Ansatz köntne sein, ein das kompakte ASRock P75 Pro3 zu nehmen und dazu 2 preisgünstige x1 und x16 riser.Damit könnt eman die Abstände für die Belüftung entpsrechend gestalten. Evtl. kann auch eine karte obne drüber querP.S: Fall man 6 Karten sinnvoll und effizient betreiben kann: MSI Z77A-G45 + 3 x1 -> x16 riser (Da würden soagr 7 KArten gehen)

-

18. November 2012 um 12:11 Uhr #929432

isch

Teilnehmer0,125 für CPU? Sind in 20 Minuten etwa 8+2+4=14 Tasks mit 5 KartenIch schaffe 24 Task in ca 25min mit einer Karte.Er die WUs dürfen sich aber so viel CPU nehmen wie sie wollen.Da nach ein paar Durchläufe die WUs etwas Zeitversetzt arbeiten habe ich vielleicht 50% CPU Last im schnitt

-

18. November 2012 um 12:11 Uhr #929431

VTG01

TeilnehmerMit meinen Karten fahre ich zur Zeit im Verhältnis i7: 0,125 CPU: 0,25 GPU (2x5870er) braucht ca. 20-23 Minuten (Board:MSI Z77A-G45)Q9400: 0,5 CPU: 0,5 GPU (1x5850er) braucht um die 20 Minuten je Taskx4 9750: 0,25 CPU: 0,5 GPU (2x5850er) braucht um die 20 Minuten je TaskSind in 20 Minuten etwa 8+2+4=14 Tasks mit 5 Karten wobei die Karten insgesamt nur 3 Cores verwenden. Die anderen 13 Cores sind für CPU-Projekte reserviert.Daneben läuft LEIDEN bzw am i7 die MP-YOYO’s in voller Speed.Sobald es wieder WU’s für WCG gibt werde ich am i7 für WCG 4 CPU-Kerne zur Verfügung stellen.Anmerkung: unter Collatz mache ich mit der Kombi etwa 12 WU’s je Stunde = 36.000 Credits je Stunde bzw. 850.000 am Tag, daneben rennen noch 16 Cores für Leiden oder YOYO. Vielleicht schaffe ich es noch und messe den Energiebedarf für Collatz und WCG am i7. Ich habe den Eindruck, dass WCG deutlich weniger Strom benötigt (es ist kühler im Raum):p

-

18. November 2012 um 12:11 Uhr #929434

VTG01

Teilnehmerisch, welche Karte hast du und was leisten die? Ich habe in Erinnerung dass du eine NV640 und einer ATI7750 hast. Wie ist der Vergleich zwischen den beiden Karten?

Kommt es bei WCG auf den Speichertakt der Karte an? Bei Collatz ist der nahezu egal – bzw. ist nicht messbar, da zählt nur der GPU-Takt.

Bei meinen Konstruktionen ist der CPU voll beschäftigt…. Ich denke die GPU langweilt sich zwischendurch. Speziell am Beginn und am Ende geht die Auslastung weit runter – teilweise sogar auf NULL (Afterburn).

Gibt es single-slot Karten die die bevorzugen würdest?

-

18. November 2012 um 13:11 Uhr #929436

isch

TeilnehmerIst eine 7870.Speichertakt ist glaube ich egal war jedenfalls bei POEM so.GPU Takt bringt da mehr.Das die Auslastung am Anfang und ende untergeht liegt daran das da der CPU Teil berechnet wird.Für die Challange wurden bei WCG 2 WUs in einer gepackt so das CPU|Graka|CPU|CPU|Graka|CPu gerechnet wird.Hatte mich am Anfang gewundert das die bei 49,x% immer anhalten und dann nach einer weile doch wieder weiter liefen.

-

18. November 2012 um 14:11 Uhr #929441

VTG01

Teilnehmerhmm, 7870er gibt es nicht im Single-Slot Design und ausserdem ist die mir zu teuer.:roll:

-

18. November 2012 um 14:11 Uhr #929442

-

18. November 2012 um 19:11 Uhr #929446

-

18. November 2012 um 19:11 Uhr #929450

isch

TeilnehmerBei WCG sieht es so mit der 7878Hier wird grade die GPU belastet.

jetzt wird wieder die CPU gefordert.

Das ist immer ein Berg auf und Berg ab.Bei POEM sieht das etwas anders aus.Wenn mich nicht alles täuscht war bei POEM bei weniger als 3,4GHz schon deutliche Credit verluste zu spüren.Schaut mal im internen da hatte ich ja schon einige test gemacht.

ulv;499215 said:

@ischWas ist denn, aus deiner Sicht, die kleinste Intel CPU für 4 bzw. 8 Grakas der Sorte GT640?Es sollte schon der i7 3770 oder ein vergleichbarer Xeon sein.

-

18. November 2012 um 20:11 Uhr #929452

ulv

TeilnehmerSo mal die Intel Varianten:

Alle mit wenigstens 7PCIe und davon 4 mal x16 physikalisch für dual-Slot-Karten.Sockel 2011

mit Chipsatz X79:

siehe: http://geizhals.at/de/?cat=mbp4_2011&xf=2961_7#xf_top

279€ / 284€ / 322€ + Quadcore ab 244€ [SIZE=”3″]= 523 bis 566 €[/SIZE]

Sockel 1155:

siehe: http://geizhals.at/de/?cat=mbp4_1155&xf=2961_7#xf_top

mit Chipsatz P67

177€ / 181€ / 371€ + Quadcore ab 150€ [SIZE=”3″]= 327 bis 521 €[/SIZE]mit Chipsatz Z77

223€ / 262€ / 375€ / 330€ + Quadcore ab 150€ [SIZE=”3″]= 373 bis 525 €[/SIZE]Socket 1366:

http://geizhals.at/de/?cat=mbp4_1366_ddr3&xf=2961_7#xf_top

mit Chipsatz X58

425€ + Quadcore ab ca. 300€? [SIZE=”3″]= 725 €[/SIZE]Socket 1156:

http://geizhals.at/de/?cat=mbp4_1156&xf=2961_7#xf_top

mit Chipsatz i3450

258€ + Quadcore ab 179€ [SIZE=”3″]= 437 €[/SIZE] -

19. November 2012 um 8:11 Uhr #929464

littledevil

TeilnehmerIst das mit Risern so schlimm?

Von Deine Auswahl Christian, wäre das ASUS P8P67 WS Revolution noch am bezahlbarsten, aber sparsam sehen die alle nicht aus :-k

Das Sapphire PURE Black P67 Hydra ginge da auch noch. -

19. November 2012 um 15:11 Uhr #929469

ulv

Teilnehmerlittledevil;499233 said:

Ist das mit Risern so schlimm?Nö, wieso schlimm?

Ich wollte mir nur mal die Alternativen ansehen.

Die ATX verbrauchen mir aber eigentlich viel zu viel Strom. (Das geht ja bis 100 Watt Idle und 200 Watt Last 🙁 )

Und die Preise finde ich echt gesalzen. Ein 1155er ITX gibt es ja schon ab 50€!Wenn man dadurch 100 Watt einsparen könnte wäre im Vergleich zu den ATX sogar ITX mit Intel Mobil-Technik (+Splitter) möglich. 100 Watt Einsparung bei Board und CPU sind auf 2 Jahre ja auch 350€.

Damit wären wir auch mir dem Design wieder frei!So etwas:

185 + 229 + 250 (Splitter) = 664€ => 664 – 350 (Strom-Einsparung) = 300€Müsste ich mich jetzt gleich entscheiden wüsste ich es schon….

-

19. November 2012 um 18:11 Uhr #929471

isch

TeilnehmerDas ASRock Z77 WS mit einem 3770 und 6 GT640 sollte unter last nicht mehr als 300W ziehen.

Wobei ich für CPU und Board 120W rechne was aber wahrscheinlich völlig übertrieben ist.250W-260W sollten drin sein.

Die x79 Bretter kannst wahrscheinlich alle in die Tonne hauen von verbrauch her.Obwohl so ein &Kerner mit 12Threads schon was feines wäre 🙂

Wenn Interesse besteht würde ich mir mal ein ASRock Z77 WS und ein 3770/Xeon E3 1240V2/1245v2 bestellen und mit meiner einen Gt640 testen.

Wie sieht es eigentlich beim Xeon ohne Graka aus?Die brauchen wir doch nicht das ja genug andere vorhanden sind.Der wäre ja vom Preis und verbrauch her der beste.

@ ulv die Mobil Dinger sind einfach viel zu langsam.Da verschenkt man so viele Credits.Schaut mal hier da habe ich ein paar Tests mit verschiedenen Taktraten gemacht.

-

19. November 2012 um 20:11 Uhr #929482

VTG01

TeilnehmerIch schaffe 24 Task in ca 25min mit einer Karte.Er die WUs dürfen sich aber so viel CPU nehmen wie sie wollen.Da nach ein paar Durchläufe die WUs etwas Zeitversetzt arbeiten habe ich vielleicht 50% CPU Last im schnitt

Also das schaffe ich beim Besten Willen überhaupt nicht!

Ich habe mich gestern nahezu den Ganzen tag herum gespielt und versucht den i7 zu optimieren. Das Beste was ich mit 2 5870er heraus bekomme sind 10 Tasks in etwa 23 Minuten. Das Verhältnis CPU/GPU steht dabei auf 0,7/0,18. Bei 0,7/0,20 ändert sich nahezu nichts (die Sekunden habe ich im Mittel rausgeschätzt) bei 0,5/0,20 brauche ich für 10 WU’s etwa 24 Minuten. Ich habe mich für die 0,5/0,20 Lösung entschieden da ich hier 3 Tasks LEIDEN mitrechnen kann.

Ich arbeite zur Zeit mit 12.10 Catalyst Treibern, die 12.11beta traue ich mich nicht drauf spielen da ich doch einige Probleme hatte 😯Nach dem Contest kommen die 2 Karten raus – wieder in eine schwächere MAschine zum Collatz rechnen. Da wird keine CPU benötigt.

Ich bin am überlegen ob ich mir stattdessen eine AMD 7750 oder eine GT640 rein baue und damit ein bisserl GPU-Projekte mitrechne. Hintergrund ist, dass der Rechner an einer USV hängt die die 400 Watt die er jetzt benötigt nicht einmal übernehmen kann. Bei 250Watt ist da Schluß. Die Gretchenfrage ist natürlich AMD oder NVIDIA!!

Da ich davon ausgehe dass es POEM als Projekt wird – oder liege ich hier falsch – sollte man mal schauen welche Karte sich besser eignet.

Isch – hast du da schon Vergleiche gesehen/gefunden zwischen 7750er und GT640er? Wichtig ist mir Singel-Slot – eventuell passt eine low-format wie zum Beispiel ASUS oder Sparkle oder Club haben sehr geringe Bauhöhe und könnten sogar in Slot eines Blades Platz finden.

[SIZE=”3″]Mal ne Idee die man weiter verfolgen könnte:[/SIZE]

Blade ASROCK B75ITX, Splitter auf 2/3 oder 4 Grakas, Anordnung der Grakas liegend neben dem Blade. Das ITX ist 17 cm breit, die Grakas (Ohne Slotblende um die 65mm/80mm? Die Länge übersteigt die 170mm auch nicht. Ich schaffe die i7 mit boxed Kühler auf etwa 70mm zu packen, das sollte ausreichen für 3 Grakas, steigert man den Abstand auf 80mm an Stelle von 70mm für die Blades könnte man theoretisch auch 4 Grakas nehmen. Der Stromverbrauch liegt bei Vollast von 2 Blades mit einem i73770 bei 3,7 Ghz (ohne Grafik ) bei ca. 105-108 Watt was je Blade etwa 55 Watt entspricht. Versorgt von einem Pico 160xt wären da doch noch 2 Grakas mit etwa 50Watt möglich.Preis: Board etwa 80.-

Prozzi mit 4 Kernen i3: etwa 130.-

Speicher 8 GB Kingston Low-profile (nur 1 Riegel je Blade – sollte für 4 Cores reichen) ca. 35.-

macht gesamt je Blade ohne Graka knapp 245.-oder

Prozzi mit 8 Kernen Xeon: etwa 240.-

mit 8 GB und Board wie oben ein bisserl über 355.-und dann die Grakas.

Splitter habe ich leider keine Ahnung was 1 auf 2 kostet.Versteht das wer oder soll ich mal den Bleistift spitzen und eine Skizze vom Blade mit den seitlichen Grakas basteln?

-

19. November 2012 um 20:11 Uhr #929484

isch

Teilnehmer[QUOTE=VTG01;499255]

Ich schaffe 24 Task in ca 25min mit einer Karte.Er die WUs dürfen sich aber so viel CPU nehmen wie sie wollen.Da nach ein paar Durchläufe die WUs etwas Zeitversetzt arbeiten habe ich vielleicht 50% CPU Last im schnitt

Also das schaffe ich beim Besten Willen überhaupt nicht!Ich habe mich gestern nahezu den Ganzen tag herum gespielt und versucht den i7 zu optimieren. Das Beste was ich mit 2 5870er heraus bekomme sind 10 Tasks in etwa 23 Minuten. Das Verhältnis CPU/GPU steht dabei auf 0,7/0,18. Bei 0,7/0,20 ändert sich nahezu nichts (die Sekunden habe ich im Mittel rausgeschätzt) bei 0,5/0,20 brauche ich für 10 WU’s etwa 24 Minuten. Ich habe mich für die 0,5/0,20 Lösung entschieden da ich hier 3 Tasks LEIDEN mitrechnen kann.Ich habe auch noch weiter optimiert.Schaffe jetzt 30 WUs in 24min :DIch arbeite zur Zeit mit 12.10 Catalyst Treibern, die 12.11beta traue ich mich nicht drauf spielen da ich doch einige Probleme hatte 😯Und das ist mit ein Grund warum du dich nicht verbesserst.Die 12.11 Beta bringen richtig Leistung.Nach dem Contest kommen die 2 Karten raus – wieder in eine schwächere MAschine zum Collatz rechnen. Da wird keine CPU benötigt.Ich bin am überlegen ob ich mir stattdessen eine AMD 7750 oder eine GT640 rein baue und damit ein bisserl GPU-Projekte mitrechne. Hintergrund ist, dass der Rechner an einer USV hängt die die 400 Watt die er jetzt benötigt nicht einmal übernehmen kann. Bei 250Watt ist da Schluß. Die Gretchenfrage ist natürlich AMD oder NVIDIA!!Da ich davon ausgehe dass es POEM als Projekt wird – oder liege ich hier falsch – sollte man mal schauen welche Karte sich besser eignet.Isch – hast du da schon Vergleiche gesehen/gefunden zwischen 7750er und GT640er? Wichtig ist mir Singel-Slot – eventuell passt eine low-format wie zum Beispiel ASUS oder Sparkle oder Club haben sehr geringe Bauhöhe und könnten sogar in Slot eines Blades Platz finden.Nach WCG werde ich die 7750 bei POEm mal ordentlich testen und dann können wir uns entscheiden.

Mal ne Idee die man weiter verfolgen könnte:Blade ASROCK B75ITX, Splitter auf 2/3 oder 4 Grakas, Anordnung der Grakas liegend neben dem Blade. Das ITX ist 17 cm breit, die Grakas (Ohne Slotblende um die 65mm/80mm? Die Länge übersteigt die 170mm auch nicht. Ich schaffe die i7 mit boxed Kühler auf etwa 70mm zu packen, das sollte ausreichen für 3 Grakas, steigert man den Abstand auf 80mm an Stelle von 70mm für die Blades könnte man theoretisch auch 4 Grakas nehmen. Der Stromverbrauch liegt bei Vollast von 2 Blades mit einem i73770 bei 3,7 Ghz (ohne Grafik ) bei ca. 105-108 Watt was je Blade etwa 55 Watt entspricht. Versorgt von einem Pico 160xt wären da doch noch 2 Grakas mit etwa 50Watt möglich.Preis: Board etwa 80.-Prozzi mit 4 Kernen i3: etwa 130.- Speicher 8 GB Kingston Low-profile (nur 1 Riegel je Blade – sollte für 4 Cores reichen) ca. 35.-macht gesamt je Blade ohne Graka knapp 245.-oderProzzi mit 8 Kernen Xeon: etwa 240.-mit 8 GB und Board wie oben ein bisserl über 355.-und dann die Grakas.Splitter habe ich leider keine Ahnung was 1 auf 2 kostet.Versteht das wer oder soll ich mal den Bleistift spitzen und eine Skizze vom Blade mit den seitlichen Grakas basteln?[Um so mehr Blades man nutzt um so ineffizienter wird es ja.2-3 ITX/CPU/RAM verbrauchen dann ja mehr als ein ASRock Z77 WS mit einer CPU/RAM./QUOTE]

-

19. November 2012 um 20:11 Uhr #929480

littledevil

TeilnehmerLeistungsfähige Mobil-CPU sind auch nicht viel sparsamer – einzig beim Board spart man Einiges ein.

Bei Boards mit vielen Steckplätzen findet man ja leider kaum jemanden der mal in Richtung Sparsamkeit optimiert hat. In den Tests gehts ja meist um OC.

Wenn X1 genügt, wäre das ASRock H61DEL immer noch m,ein Favorit. Das hatten auch einige Bitcoiner im Einsatz.

Das ist schön kompakt, sparsam und hat 6 Pcie slot, von denen man 5 mittels x1 -> X16 Riser nutzbar machen kann. Ein Slot ist direkt x16Dazu passend wird der Intel Xeon E3-1270V2, 4x 3.50GHz vom BIOS unterstützt. Da wäre die Frage, ob sich der Aufpreis für den 1270 lohnt. Unter Features ist ” Idle States” gelistet. Haben das nicht alle?

Der E3-1240V2 schafft ja 3,8 GHz im Turbo – sollte ja ausreichen, oder? -

19. November 2012 um 21:11 Uhr #929485

VTG01

TeilnehmerIch habe auch noch weiter optimiert.Schaffe jetzt 30 WUs in 24min

Was soll ich dazu sagen –> mir drückt es die Tränen in die Augen!! :crymk: :crymk:

Und das ist mit ein Grund warum du dich nicht verbesserst.Die 12.11 Beta bringen richtig Leistung.

Ich hadere noch – muss wohl über Fernzugriff installieren, nur falls das in die Hose geht komme ich erst morgen am Abend zu Gerät – ich werfe eine Münze…

Nach WCG werde ich die 7750 bei POEm mal ordentlich testen und dann können wir uns entscheiden.

Auf das freue ich mich schon.

Um so mehr Blades man nutzt um so ineffizienter wird es ja.2-3 ITX/CPU/RAM verbrauchen dann ja mehr als ein ASRock Z77 WS mit einer CPU/RAM.

Das trifft POEM, nicht aber WCG – oder täusche ich mich da?

Nach WCG werde ich auch mal POEM auf den 5850er und 5870er testen.

-

19. November 2012 um 21:11 Uhr #929491

isch

TeilnehmerWie es bei WCG mit der GT640 aussieht weiß ich nicht aber hier sollten die ATI die Nase vorn haben.Tante Edit: Ich habe mir Grade mal die Host Stats von WCG angeschaut und die erst NV Karte ist ca auf Platz 120 und das auch nur weil es 3 x GTX 580.Der nächste ist dan ca 10 Plätze weiter hinten mit 2 GTX 580.Bis dahin sind es nur ATI 7xxx Karten.Keine 6xxx oder 5xxx auch nicht im 2 3 oder 4er Verbund.

-

24. November 2012 um 8:11 Uhr #929679

isch

Teilnehmer -

24. November 2012 um 9:11 Uhr #929681

VTG01

TeilnehmerDie ersten test mit meiner 7750 laufen und ich kann nur sagen7750

Also mir wäre das ganz recht …Kanst du ein neues Thema anfangen in dem die Test alle aufgelistet sind. Soll ich mit den 5850er und 5870 und dem i7 auch Projekte testen? Ich könnte heute bzw. morgen Grakas umstecken. Unter der Woche geht das leider nicht da der rechner nicht bei mir ist.

-

24. November 2012 um 10:11 Uhr #929685

isch

TeilnehmerJa ich kann ein neues Thema aufmachen.Bislang habe ich aber nur hochgerechnet was in 24h ercruncht wird.Was wirklich bei rum kommt werde ich in 2-3 Tagen sehen dann hat man einen vernünftigen Ansatz.

-

24. November 2012 um 15:11 Uhr #929697

isch

Teilnehmerin ca 15 Std habe ich 313000C gemacht.Sind dann 500k am Tag.Die app habe ich erst mal so pi mal Auge erstellt da muss ich noch einiges Testen.Was mir noch aufgefallen ist da waren einige WUs mit fast doppelter Laufzeit bei gleich Credits dabei.Ich weiß jetzt nicht ob das an den WU liegt oder an meiner Graka.

-

24. November 2012 um 15:11 Uhr #929696

phil68

TeilnehmerNaja… weggeben wird sich nicht lohnen. Es schadet nie sowohl NV, als auch ATI zu haben 😉

Grüße Dirk

-

24. November 2012 um 15:11 Uhr #929695

isch

Teilnehmerdie GT 640 kannst wieder weg gebenDas ganze geht aber nur mit den neuen Beta Treiber.Wie das dann wieder bei linux aussieht weiß ich nicht.Wenn wir dann das System aufbauen muss es halt mit win7 sein.

-

24. November 2012 um 15:11 Uhr #929694

phil68

Teilnehmer -

24. November 2012 um 16:11 Uhr #929699

VTG01

TeilnehmerWelche 7750er hast du zum Testen?

-

24. November 2012 um 17:11 Uhr #929700

-

25. November 2012 um 8:11 Uhr #929714

isch

TeilnehmerLeider habe ich mich mit den 500K am Tag vertan.Irgendwie läuft das auf den ATIs anders als auf den NV.Hatte ja neben bei noch Leiden laufen und das hat die ganze Sache aus gebremst.Die Leiden WUs die ich noch hatte habe ich noch zu ende rechnen lassen und dann nur noch POEM.

-

25. November 2012 um 19:11 Uhr #929743

Renovatio

TeilnehmerDann sind wir mal auf deine Resultate gespannt.

-

25. November 2012 um 22:11 Uhr #929759

littledevil

Teilnehmerisch;499489 said:

DieseWie schaut die von der Lautstärker her aus? Was ist die min Lüfterdrehzahl?

-

25. November 2012 um 23:11 Uhr #929763

isch

TeilnehmerMir war die zu laut und ich habe einen Arctic Cooling Accelero S1 Plus mit einem 120 bequiet drauf gemacht.

Muss aber dazu sagen das ich ein silent Freak bin 🙂

Lüfterdrehzahl war min 30% aber wie viel rpm das waren weiß ich nicht.

-

26. November 2012 um 18:11 Uhr #929796

ulv

TeilnehmerFinde ich total toll, dass du dich da so reinhängst. Danke!Optimierst du das System nur in Richtung Credits/Tag oder auch in Richtung Credits/Watt?Kannst du auch mal einen PCIe mit x1 probieren? Würde mich interessieren wegen dem Splitter.PS: Der gh-Wunschlisten-Link funktioniert leider nicht.

-

26. November 2012 um 18:11 Uhr #929797

isch

TeilnehmerHauptziel ist natürlich soviel Credit bei so wenig verbrauch wie möglich.gh habe ich mal geändert.Bei mir funzt der aber.Wie mache ich das mit x1.Habe keinen auf meinen Board.Ist ein Asrock b75M

-

26. November 2012 um 18:11 Uhr #929794

isch

TeilnehmerIch weiß garnicht so richtig wo ich anfangen soll.Als ersten könnt Ihr meine 500C/d Hochrechnung mal ganz schnell wieder vergessen.Die Einstellungen in der app.info waren ein Griff ins Klo und die neben bei laufenden CPU WUs haben die Sache noch verschlimmert.Dann hatte ich das Problem das er diese Nacht und Heute morgen abgestürzt ist.Ich habe jetzt mal ein paar Bios Einstellungen geändert und um 17.00Uhr eine neue Testphase angefangen.Sollte es wieder zu abstürzen kommen habe ich noch 2 andere Sachen in verdacht die ich dann halt noch mal testen muss.Danach kann ich die app.info noch mal etwas optimieren obwohl ich da im Moment keinen großen Spielraum mehr sehe.Dann mal hier ein paar Verbrauchswerte. CPU 3,7GHz GPU 800/800 app.ino 0.33/2/0.16[table “” not found /]

Die WU laufzeiten sind eigentlich 174xs und die 860K sind nur errechnet1750s:60=29,16min1440min:29=49,6549×6=294WUs294x2925C=859950Wie man sieht sollten es sogar noch etwas mehr sein.BAM sagt mir das ich gestern 816K und Free-DC 836k errechnet habe.Da in der Nacht aber noch ein paar CPU WUs liefen kommt das in etwa hin.Wie man sieht lastet eine GPU einen i7 @3,7GHz um die 30% aus was bedeutet das max 3 Gaka pro CPU Sinn machen.Dann habe ich da auch schon mal was zusammen gestellt.1 x Samsung SSD 840 Series 250GB, 2.5″, SATA 6Gb/s (MZ-7TD250BW)1 x Intel Xeon E3-1240V2, 4x 3.40GHz, Sockel-1155, boxed (BX80637E31240V2)1 x G.Skill DIMM 8GB PC3-12800U CL11-11-11-28 (DDR3-1600) (F3-1600C11S-8GNT)3 x Club 3D Radeon HD 7750, 1GB DDR3, VGA, DVI, HDMI (CGAX-7752Z)1 x ASRock Z77 Extreme3, Z77 (dual PC3-12800U DDR3)1 x Antec EarthWatts EA-450 Platinum, 450W ATX 2.32 (0761345-04740-1/0761345-04741-8)1 x Microsoft: Windows 7 Home Premium 64Bit inkl. Service Pack 1, DSP/SB, 1er-Pack (deutsch) (PC) (GFC-02054)Bei einem Blade macht das ca 900€ Anschaffungskosten wobei ich noch kein Gehäuse mit eingerechnet habe aber dafür eine Win7 Version. Der verbrauch sollte dann im schlimmsten Fall 200W betragen.Wobei wir dann ca 2,4Mio c/d errechnen.Hierbei habe ich aber noch nicht den geringeren Takt des Xeons bedacht (weniger verbrauch aber wahrscheinlich auch weniger C/d).GPU untervolting kommt ja auch noch dazu.ToDo:wenn ich die abstürze in Griff habe-app.info Optimieren um mehr C/D raus hohlen-mit 0,5 und 5 WUs testen-mit 3,4GHz testen (Xeon Takt)-GPU untervolten [in Afterburn leider nicht möglich)-GPU untervolten und gleichzeitig OC-GPU im x4 Slot testen da das vorgeschlagene Board 1x 3.0 x161x 3.0 x81x 2.0 x4hat-event. eine 2Graka hohlen um CPU last und c/d zu testen.Wenn noch wer was wissen will immer Fragen. -

26. November 2012 um 18:11 Uhr #929798

phil68

TeilnehmerHallo isch 🙂

Auf meinem Q9550 und der HD 6850 habe ich in der app_info.xml mit 0.5 CPU die größten Erfolge erzielt.

BAM sagt mir das ich gestern 816K und Free-DC 836k errechnet habe.

Selbst 800k ist für eine Karte ne echte Hausmarke :respekt:

Wie mache ich das mit x1.Habe keinen auf meinen Board.Ist ein Asrock b75M

Es reicht schon, wenn du den Vergleich zwischen x16 und x4 hast… wird sicher kaum etwas ausmachen.

Grüße Dirk

-

26. November 2012 um 19:11 Uhr #929804

isch

TeilnehmerCf wird nicht benötigt.THX für den link werde die mal beobachten.

-

26. November 2012 um 19:11 Uhr #929801

VTG01

TeilnehmerSchaut mal was da in der Bucht ist. Leider liefern die nicht nach Österreich, sonst würde ich da mitgehen…. und ob die Verpackung eine Beule hat sollte doch egal sein.PS: Ich habe gelesen dass die 7750 keine Crossfire Brücke benötigt und dennoch Crossfire läuft. Das sollte auch ein bisserl weniger “Monitorstecker” benötigen.

-

26. November 2012 um 19:11 Uhr #929799

isch

Teilnehmermit 0.5 kann ich auch mal testen bei das dann mit 3 Karten und einem i7 schon wieder schlecht aussieht.Dann müsste man auf 5 WUs senken was ich dann auch mal testen werde.

-

26. November 2012 um 19:11 Uhr #929800

isch

Teilnehmerphil68;499592 said:

Hallo isch :)Auf meinem Q9550 und der HD 6850 habe ich in der app_info.xml mit 0.5 CPU die größten Erfolge erzielt.BAM sagt mir das ich gestern 816K und Free-DC 836k errechnet habe.

Selbst 800k ist für eine Karte ne echte Hausmarke :respekt:

Wie mache ich das mit x1.Habe keinen auf meinen Board.Ist ein Asrock b75M

Es reicht schon, wenn du den Vergleich zwischen x16 und x4 hast… wird sicher kaum etwas ausmachen.Grüße Dirk

Wobei die 7750 kaum mehr verbraucht als die GT640 und die war ja bis zur Einführung der beta Treiber die beste GPU was c/w angeht.

-

26. November 2012 um 19:11 Uhr #929806

Sc0rp

TeilnehmerRe,

isch;499590 said:

Wie mache ich das mit x1.Habe keinen auf meinen Board.Ist ein Asrock b75Mein einfachsten Fall einfach mit (derbem aber dünnem) Klebeband abkleben, allerdings muss man da unglaublich vorsichtig sein. Besser ist es einen PCIe x1-Riser zu nehmen (den oder einen anderen)

Sc0rp

-

27. November 2012 um 11:11 Uhr #929840

littledevil

TeilnehmerVTG01;499595 said:

Leider liefern die nicht nach Österreich, sonst würde ich da mitgehen.Wenn Du den extra Versand nacxh Ö drauf legt, kann ich die für Dich ersteigern und schicke Sie Dir dann.

Bei interesse PN. Wir sollte nur nicht alle drauf bieten, sondern uns vorher absprechen. 😀 -

27. November 2012 um 18:11 Uhr #929901

isch

TeilnehmerLeider gab es Heute morgen wieder einen Absturz.Habe dann mal auf 5WUs reduziert und immer noch 99% Graka last gehabt aber die Laufzeiten haben sich auf 1500s reduziert.Heute Mittag dann wieder einen.Habe jetzt auf 4 gestellt und die Auslastung liegt bei 97-98%.Sollte es jetzt immer noch abstürze geben weiß ich auch nicht mehr woran das liegen kann.Dadurch das jetzt nur noch 4 WUs laufen hat sich auch die CPU last auf 25%.So könnte man auch wieder 4Karten mit einem i7 betreiben.Was mich an der sache allerdings wundert das ich bei 4 WUs fast 100% und in anderen Foren sind es bei 6WU meist unter 90% ???Wie lange jetzt die Laufzeiten sind und wie viel c/d es geben wird schreibe ich später.Hatte bei 4 WUs auch wieder einen Absturz.Ich vermute mal das die CPU im Teillast Bereich durch dieses sch… offset gedönse nicht stabil ist. Dann gibt es leider schlechte Nachrichten:

Hi everybody,I have to apologize for the long period of silence regarding this topic, but I didn’t want to give any misleading information before we discussed the problem here.We are still waiting for our new server hardware, but unfortunately this won’t fix the problem here entirely.Fact is, these GPU calculations are running so rapid, that we have to evaluate real floods of information. We were talking about possibilities to send out more GPU work units, but at the moment there is no way to process it in time.I want to thank all of you for spending so much computing time. It’s absolutely okay to give your GPU power to another project now, there may be more use for it at the moment. The crystallization studies will still continue, but the follow-up projects with GPU support are not yet in a state to be sent out over the BOINC network, so the situation is not likely to get better in the near future.I hope you can understand this, and are still willing to support us.Best regardsThomas

Rechne grade meine letzten 4 WUsDie haben ca 1360s gebraucht bei 98% GPU und 25 CPU last.Verbrauch lag bei 85W.Wenn die WUs durch sind baue ich die Graka aus und rechne Leiden.

-

4. Dezember 2012 um 20:12 Uhr #930180

ulv

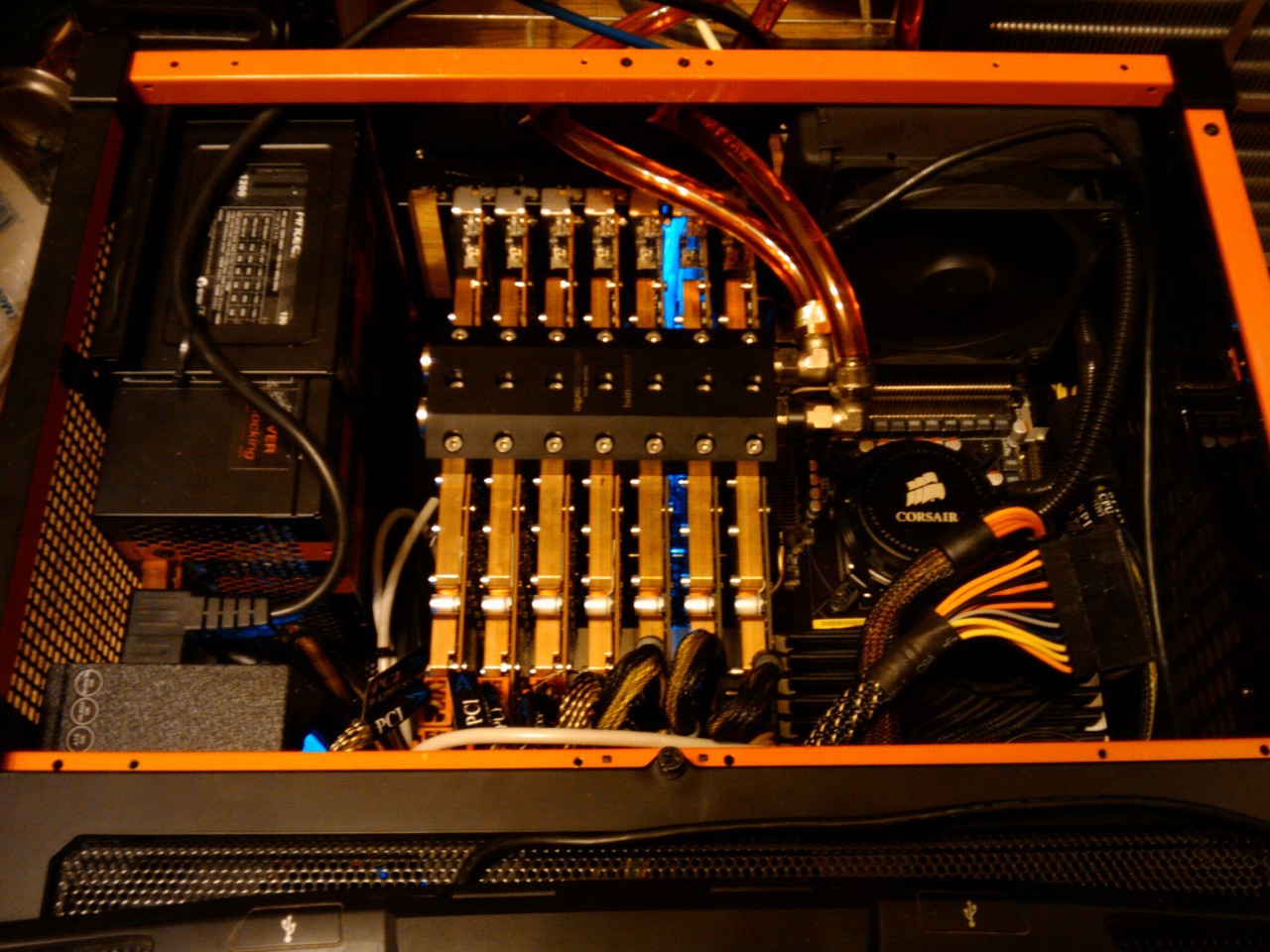

TeilnehmerIch würde gerne nochmal auf das Gehäuse zu sprechen kommen:

Die Lösung mit ITX Boards und (Non-GPU-) Xeon 1155 + Splitter lässt mich nicht mehr los.

VJoe said:

Darf ich mich da mal bezüglich des Gehäusebaus einschalten?Das wäre ja ein Traum. Bei deinen Qualitäten… sehr gerne. :d:

Mit den 150°-Alfer-Verbindern kann man wenn ich es richtig verstehe nur ein 12-Eck bauen, oder? Das würde vermutlich auch gut passen:

Also 6 ITX mit dem Gesicht (CPU+Kühler) nach innen um ein Netzteil und außen herum bis zu 24 Grakas. :-kRund würde mir aber schon auch sehr gut gefallen. Evtl. nur ein kleines rundes Gehäuse an dessen Rand die PCIe Steckplätze sind und die Grakas dann freifliegend drumherum in einem Gitter-Käfig, der bündig mit dem Lüfter (siehe unten) abschließt?

Ich hab jetzt auch schon einen Lüfter – ähm, besser müsste man wohl Gebläse sagen – gefunden:

http://www.ebmpapst.com/media/content/info-center/downloads_10/catalogs/update_2011_1/axial/Axialventilator_AC-HyBlade_DE.pdf

Das sind sehr sparsame Lüfter! Die gibt es mit 50cm bis fast 1 Meter Durchmesser. 😯

Kein Scherz die gibt es schon ab 90 Watt. Etwas gedrosselt sind es vermutlich nur 20-30 Watt. Total leise und zuverlässig. -

4. Dezember 2012 um 22:12 Uhr #930182

Gillian

TeilnehmerOptisch fände ich ein rundes oder auch ein 12-eckiges Gehäuse ‘richtig scharf’ 😉

Aber technsich wäre es doch sicher schlauer, wenn wir das ganze modularer aufbauen, ich kann mir nicht vorstellen, dass wir alle 24 GraKas an einem Netzteil betreiben wollen.

Oder doch?

Dann bin ich sofort für die 12-Eck Variante, kann dazu aber handwerklich kaum was beitragen 🙁

Gruß

Gunnar

-

5. Dezember 2012 um 8:12 Uhr #930186

Jabba

TeilnehmerNachdem das Thema wieder Fahrt auf nimmt, darf ich auch mal meinen Senf dazu beitragen.

Da ich ja noch aus diversen Testbauten einen 4fach PCIe Splitter habe und demnächst ein Mini ITX 1155 Board mit Xeon ins Haus steht, werde ich selbiges mit dem Splitter bestücken und testen.

Diese Splitter funktionieren nicht auf jedem Board. Bspw. können unsere Mini ITX Platinen im EMK2 nicht mit dem Splitter umgehen – wird einfach nicht erkannt. Andere µATX Boards funktionieren problemlos.

Ein Nachteil ist der Preis des Splitters, der seinerzeit bei deutlich über €200 lag. Wer schön sein will muß eben leiden.Bei der Länge der PCIe Kabel kann ich leichte Entwarnung geben. Ich konnte bereits zwei ineinander gesteckte PCIe Verlängerungen von jeweils ca. 17cm erfolgreich betreiben. Allerdings auch hier wieder die Einschränkung: geht nicht in jedem Slot, nicht mit jedem Board, nicht mit jedem Kabel. Scheinbar ist man hier am Ende der Spezifikation.

Was mir beim Bau solcher Graka-Gräber immer wieder in die Quere kam ist die Höhe der Dualslotkühler. Single Slot Varianten sind hierbei deutlich angenehmer zu verbauen und auch zu kühlen. Wahlweise auch ein Singleslot Wasserkühler.

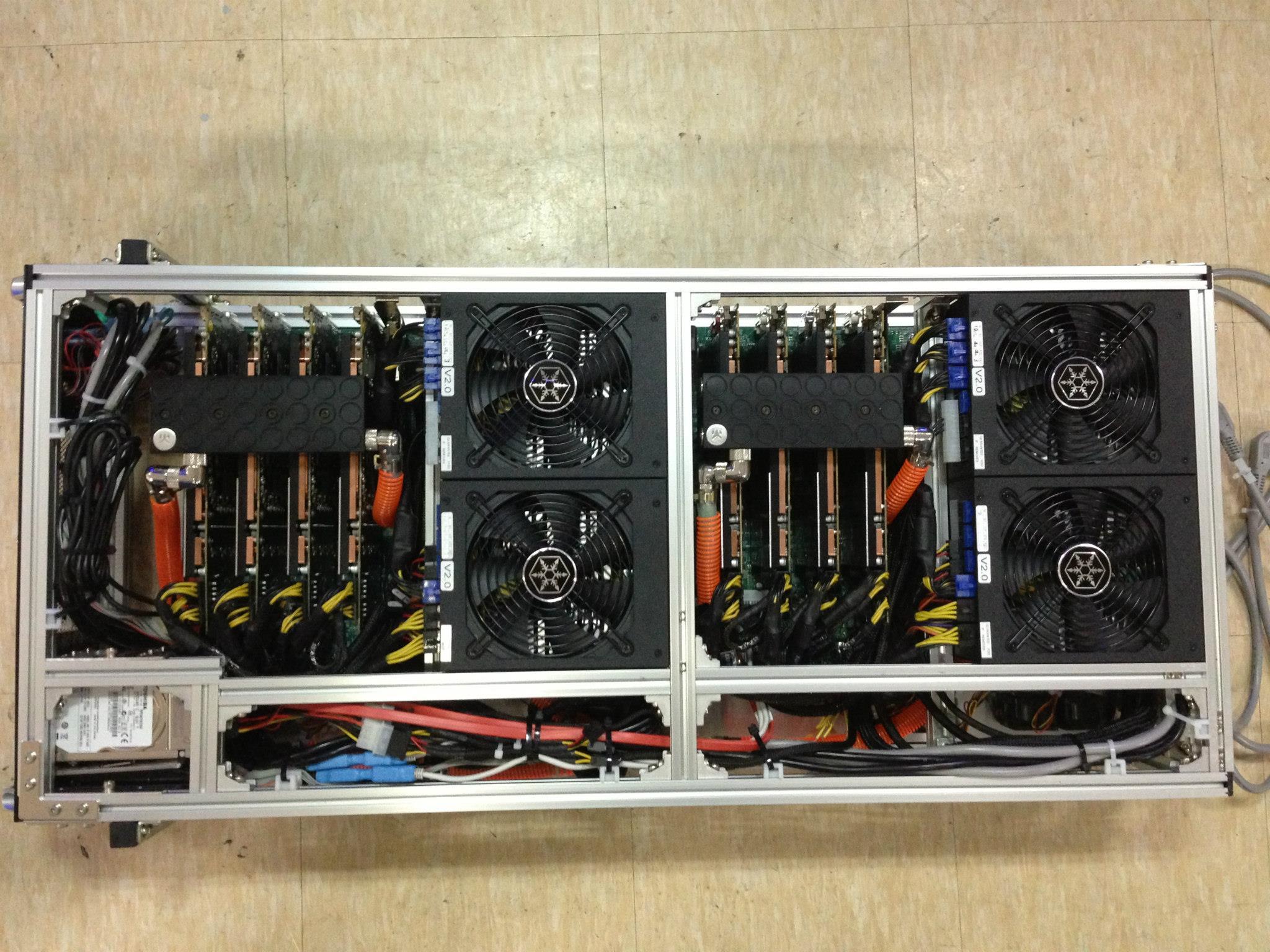

Mal ein kleiner Praxiswert aus dem Bitcoinmining:

7 Rechner bestückt mit jeweils 4 x 5870 erzeugten trotz geschlossenem Gehäuse, 6 Lüftern je Gehäuse und zwei extern anblasenden Ventilatoren plus einer Klimaanlage eine Tischtemperatur von weit über 40°. Die Aura rund um die Rechner war nur noch als ungemütlich zu beschreiben. 😉

Kein Wunder bei 7 KW Abwärme….Gruß

Jabba

-

5. Dezember 2012 um 12:12 Uhr #930194

ulv

TeilnehmerDas hört sich vielversprechend an! Hoffentlich findet sich ein ITX wo der Splitter läuft.

Mir würde mitlerweile die Lösung mit den 6 ITX in der Mitte am allerbesten gefallen. Also die Lösung mit den CPU Kühlern nach innen. Und dem Splitter auf der Rückseite vom ITX. Das muss dann auch nicht mehr rund sein. Auf der Rückseite der ITX wären dann die 5 PCIe-Slots montiert die alle nach außen zeigen. (Je GPU wären dort etwa 4cm Platz). Das würde mit einem einzigen ITX schon funktionieren und kann dann mit der Zeit erweitert wedern bis evtl. der Stern voll wird. Das Netzteil (mehr als 1,5 kW kommt für mich nicht in Frage!) kann dann ja auch unten in eine Ecke und in die andere Ecke der Switch, SSD etc.

Wenn ich mich nicht verrechnet habe dann ginge das immer noch mit normalen PC Abmaßen also ca. 60cm Höhe, 60cm Breite und ca. 30cm Tiefe ab.Und ich will unbedingt so einen Mörder-Lüfter! 😀

-

5. Dezember 2012 um 12:12 Uhr #930193

x20011

TeilnehmerJabba;499991 said:

Mal ein kleiner Praxiswert aus dem Bitcoinmining:

7 Rechner bestückt mit jeweils 4 x 5870 erzeugten trotz geschlossenem Gehäuse, 6 Lüftern je Gehäuse und zwei extern anblasenden Ventilatoren plus einer Klimaanlage eine Tischtemperatur von weit über 40°. Die Aura rund um die Rechner war nur noch als ungemütlich zu beschreiben. 😉

Kein Wunder bei 7 KW Abwärme….Ich habe mich eben mal in das Thema bitcoinmining eingelesen.Lohnt sich das bei dem Hardware Aufwand und den stromkosten überhaupt?

-

5. Dezember 2012 um 12:12 Uhr #930195

Jabba

Teilnehmer@x20011

Seit Mitte diesen Jahres macht es kaum noch Sinn mit Grakas zu rechnen. Die Stromkosten sind einfach zu hoch. Es sei denn Du spekulierst auf massiv steigende BTC Kurse.

Ansonsten brauchst Du eine Stromflat.

Ich selbst habe bereits auf FPGAs umgestellt. Im Januar / Februar zündet die nächste Evolutionsstufe – dann kommen ASICs. -

5. Dezember 2012 um 13:12 Uhr #930196

littledevil

Teilnehmerulv;499981 said:

Das sind sehr sparsame Lüfter! Die gibt es mit 50cm bis fast 1 Meter Durchmesser. :shock:……Etwas gedrosselt sind es vermutlich nur 20-30 Watt. Total leise und zuverlässig.

hast Du die schon mal Live erlebt?

-

5. Dezember 2012 um 18:12 Uhr #930207

ulv

Teilnehmerlittledevil;500001 said:

hast Du die schon mal Live erlebt?Im Datenblatt steht 90 Watt bei 560 Umin => 50 dB(A) bei ca. 3000m³/h (1800CFM) (Bei einem Druck von 29 Pa = 2,858 Aqmm)

Zum Vergleich die 8 Lüfter vom E=mk² haben 8*3,6 Watt = ca. 30 Watt haben dabei auch schon je 38 dB(A) bei je 175 m³/h

=> Bei 8 Lüftern macht das +9bB = 47dB(A) bei ca. 700 m³/h (Bei einem Druck von 5,484 Aqmm).Den großen Lüfter kann man aber noch um einiges drosseln, wir brauchen ja nicht 3000m³/h (der E=mk² braucht ja tatsächlich auch nur so 300 m³/h)

Der große Lüfter wird gedrosselt also um ein vielfaches leiser sein als der E=mk².BTW: Die Lüfter kennst du von Klimaanlagen an jedem Supermarkt. Ich kenne die bzw. ähnliche aus dem Rechenzentrum. Ist halt ein besserer Standventilator…

-

6. Dezember 2012 um 11:12 Uhr #930233

littledevil

TeilnehmerIst das dann ein AC oder DC-Lüfter?

-

6. Dezember 2012 um 12:12 Uhr #930234

-

6. Dezember 2012 um 15:12 Uhr #930243

Jabba

TeilnehmerKann man per Kondensator machen.Dann allerdings nicht regelbar.

-

6. Dezember 2012 um 15:12 Uhr #930242

littledevil

TeilnehmerWomit willst Du die drosseln ulv?

-

6. Dezember 2012 um 16:12 Uhr #930246

ulv

TeilnehmerDie Lüfterdrehzahl kann man z.B. mit so etwas steuern:

http://www.conrad.de/ce/de/product/084529/Aber auch z.B. aller Dimmer für Hochvolt-Halogen.

-

6. Dezember 2012 um 22:12 Uhr #930256

Renovatio

TeilnehmerBin mal auf den Test des Lüfters gespannt. ^^

Wäre sicherlich eine gute Alternative gegenüber den kleineren Lüftern. -

9. Dezember 2012 um 12:12 Uhr #930354

VJoe2max

Teilnehmer@ulv: Hast natürlich recht mit den Alfer-Winkeln. Ein Zwölfeck müsste es werden. Das würde aus meiner Sicht für zwölf ITX-Boards oder µATX-baords mit je einer Karte (ITX) oder zwei Karten (µATX) sprechen. Von der Komplexität her wäre der Aufbau so sicher einfacher und weniger Fehleranfällig als mit Splittern, es könnten sich Viele mit einem ganzen System beteiligen und die CPU-Performance pro Board wäre nicht so kritisch. Insgesamt kann man auf billigere Komponenten setzen und muss nicht auf irgendwelche, wo möglich anfälligen Splitterkonstrukte zurückgreifen. Wenn das dann irgendwann nicht reicht baut man halt ein zweites Stockwerk mit weiteren zwölf ITX-Bays drauf. Das Belüftungskonzept mit einem zentralen Riesenlüfter könnte man dahingehend denke ich sogar beibehalten.

-

21. Dezember 2012 um 18:12 Uhr #930925

Obi Wan

Administratorvor Weihnachten geht nix mehr, oder ist das Projekt bis ins nächste Jahr auf Eis gelegt ?

-

21. Dezember 2012 um 22:12 Uhr #930942

Renovatio

TeilnehmerWird sicherlich noch was dauern bis hier weitergeht. Bin mal aber gespannt auf die Recherchen. 😀

-

21. Dezember 2012 um 22:12 Uhr #930935

littledevil

TeilnehmerWir sind ja noch in der Recherchephase… 😉

Ich würde sogar behaupten, das da bis zum Penthalon noch nix fertig ist… #-o -

30. Dezember 2012 um 12:12 Uhr #931221

ulv

TeilnehmerVJoe2max;500174 said:

@ulv: Hast natürlich recht mit den Alfer-Winkeln. Ein Zwölfeck müsste es werden. Das würde aus meiner Sicht für zwölf ITX-Boards oder µATX-baords mit je einer Karte (ITX) oder zwei Karten (µATX) sprechen. Von der Komplexität her wäre der Aufbau so sicher einfacher und weniger Fehleranfällig als mit Splittern, es könnten sich Viele mit einem ganzen System beteiligen und die CPU-Performance pro Board wäre nicht so kritisch. Insgesamt kann man auf billigere Komponenten setzen und muss nicht auf irgendwelche, wo möglich anfälligen Splitterkonstrukte zurückgreifen. Wenn das dann irgendwann nicht reicht baut man halt ein zweites Stockwerk mit weiteren zwölf ITX-Bays drauf. Das Belüftungskonzept mit einem zentralen Riesenlüfter könnte man dahingehend denke ich sogar beibehalten.Sorry, für die späte Antwort. Bei mir war einfach gnadenlos viel los.Die Splitter sind von Peter ausgiebig getestet worden und laufen sehr stabil. Die sehr flexiblen auf Plastik gedruckten Leitungen sind für die Ewigkeit. Auch logisch ist der Splitter eine sehr saubere Lösung trennt er doch die PCIe x4 nur in einzelne PCIe x1 auf. Das ist kein Murks sondern mal einen schöne und Software-Transparente Lösung. Solche Splitter-Chips sind auf praktisch jedem Mainboard drauf.Zumindest Dirk und ich wollen nicht nur einen Rechner von der Stange und gerade die Splitter machen meiner Meinung nach den Unterschied so wie die PICOs und Samuel im E=mk² den Unterschied machen. Ich möchte, dass das einfach auch beeindruckend und besonders aussieht.So zum Beispiel:

Das Gehäuse könnte auch mit bis zu 6 ITX noch 12-eckig sein. Man müsste nur achten, dass alle Teile symmetrisch sind, dann kann man das so oder so ähnlich lasern oder fräßen lassen. Was denkst du, ist das machbar?Zugegeben das ist nicht die günstigste Lösung, aber das Gehäuse incl. Splittern könnte man vermutlich über mehrere Jahre so beibehalten und nur die ITX und Grakas tauschen. Schön wäre es wenn das langsam wachsen kann und auch die etwas ältere Hardware noch bei Bedarf mitrechnen kann.Mehr als 24 Grakas machen aber wohl keinen Sinn. :DIch denke, dass langfristig bei allen GPU-Projekten die CPU-Last weiter sinken wird. Die Probleme sind meiner Meinung nach nur in der Umstellungsphase gegeben. Und dann werden hoffentlich 4 GPUs auch an einer (sehr) keinen CPU laufen. Die PICOs bringen ja eh auch nur so 70 Watt! Und 12 ATX Netzteile kommen wohl nicht recht in Frage, oder?

-

30. Dezember 2012 um 12:12 Uhr #931224

isch

TeilnehmerMit den Splittern wird das bei POEM wohl nicht werden.IM P3D Forum haben einiger reichlich getestet was am meisten C/D bringt.http://www.planet3dnow.de/vbulletin/showpost.php?p=4706929&postcount=1145http://www.planet3dnow.de/vbulletin/showpost.php?p=4708146&postcount=1230http://www.planet3dnow.de/vbulletin/showpost.php?p=4710047&postcount=1275http://www.planet3dnow.de/vbulletin/showpost.php?p=4709823&postcount=1267

-

30. Dezember 2012 um 13:12 Uhr #931230

VJoe2max

TeilnehmerHmm – wären die Grakas dann die Striche außen? Da müsste dann noch was außen rum, damit die Karten nicht so frei in der Gegend rum hängen – oder?Wenn die Karten nach innen zeigen würden, wäre das kühltechnisch sicher einfacher zu bewerkstelligen. Machbar ist jedenfalls fast alles ;). Da muss man auch nicht viel fertigen lassen – höchstens zur Zeitersaprnis. Die Blechtafeln kann man sich z.B. zuschneiden lassen – ist aber mehr Zeitersparnis, als wirklich nötig. Evtl. hab ich auch bald ne Tafelshere – da hätte sich das Thema auch erledigt. Dass ein Gehäuse, welches komplett aus Alu-Profilen und Alu-Platten besteht, nicht ganz so billig, wie irgendwelche PC-Gehäuse von der Stange sein wird, versteht sich. Dafür ist das Ganze aber stabil, erweiterbar und genau auf die Hardware abstimmbar. Insgesamt sollte so eine Konstruktion auf jeden Fall deutlich billiger sein, als wenn man sich da was Individuelles komplett anfertigen lässt. Abgesehen davon kann man so auch problemlos erweitern und umbauen.Wenn ihr da schon ein konkretes Konzept im Kopf habt, sollten wir uns vllt,. in absehbarer Zeit mal treffen und die Details besprechen, oder ne kleine Planungs-Session machen ;).Wäre dann natürlich gut, wenn zumindest so ein Splitter zum Maß nehmen da wäre. Der Rest ergibt sich dann.Was die Netzteile angeht: Könnte mir durchaus vorstellen, dass man sechs oder zwölf-ATX-Netzteile formschön unterbringen kann, aber ich glaube das ist doch etwas zu viel des Guten – oder? Hinsichtlich Effizienz wird das denke ich eher schwierig.

-

30. Dezember 2012 um 13:12 Uhr #931226

schannall

Teilnehmerulv;501096 said:

Die PICOs bringen ja eh auch nur so 70 Watt! Und 12 ATX Netzteile kommen wohl nicht recht in Frage, oder?Warum nicht einfach 2 oder 3 ATX Netzteile und da dann einfach auf 4-6 Boards verteilen?

sC

-

30. Dezember 2012 um 14:12 Uhr #931237

littledevil

Teilnehmer@isch dann müsste die ja @x1 stark einbrechen, oder?

-

30. Dezember 2012 um 15:12 Uhr #931243

isch

TeilnehmerJa vermute ich.Es bringt ja nicht wenn 4 Stück @ x1 nur so viel wie zwei @ x16 schaffen.Und wenn ich das richtig sehe sind das doch nur PCIe Splitter und keine PCIe Gen3 was ja dann noch mal eine extreme Reduzierung der Bandbreite wäre.

-

30. Dezember 2012 um 16:12 Uhr #931246

littledevil

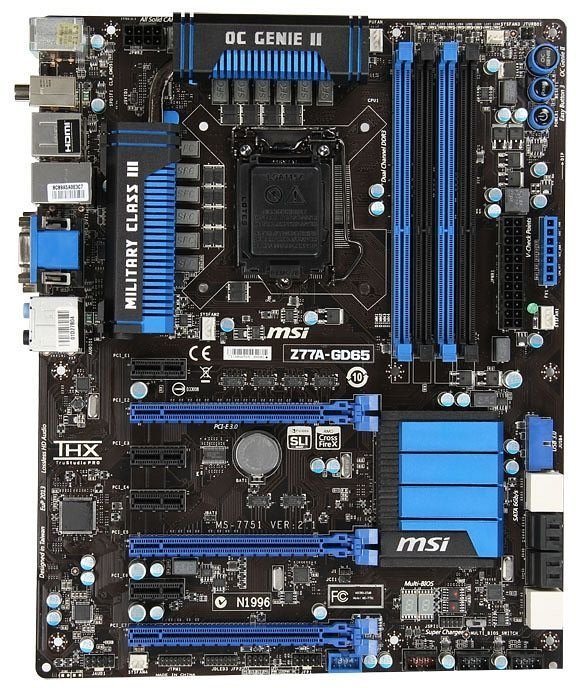

Teilnehmeralso eher in richtung 3 PCIe 3.0 x16 steckplätze pro Baord planen`

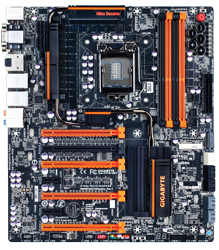

z.b. MSI Z77A-GD65

-

30. Dezember 2012 um 18:12 Uhr #931253

Lukas

TeilnehmerHi ich wollte mal fragen ob ich mich wärend den Planungen “einschleichen “dürfte und euch helfen dürfte.

Also Wir wissen jetzt dass wir ein mainboard brauchen dass wenig Strom zieht bzw keine Unnötige Funktionen haben soll , wass drei PCie x16 anschlüsse haben soll und ein i7 oder Xenon drauf soll

-

30. Dezember 2012 um 18:12 Uhr #931254

Obi Wan

Administratorich denke Lukas, jeder ist hier willkommen 😉

-

30. Dezember 2012 um 18:12 Uhr #931257

Lukas

Teilnehmer@ Obi thxBraucht ihr vllt iw Werte von i7 3770k und ich hätte da noch ein Mainboard http://geizhals.de/749609 Halten wir jetzt noch ein einer ” runden ” Lösung fest ? und ham wir uns schon um Kühlung der Cpu befasst weil im eim geschlossenen Case wenn der Lüfter oben ned ist kann der CPU schon anfangen zu schwitzen. Ich fande die Idee mit mehreren case von jeweils 4 Gk drin sind auch ned so schlecht

-

30. Dezember 2012 um 19:12 Uhr #931263

isch

TeilnehmerHallo Lukas und Willkommen an Boarddein verlinktes Board ist ja sogar µATX was natürlich noch besser ist.Gigabyte ist leider für nicht Stromsparende Boards bekannt.Das MSI ist dagegen schon Stromsparend.Ich habe das GD55 und das liefert gute werte.

-

30. Dezember 2012 um 19:12 Uhr #931264

VTG01

Teilnehmerhmm, Auch mal ein Vorschlag von mir:

ASROCK Z77 WS,

Das Board hat einen zusätzlichen Stromamschluss für die Karten, theoretisch passen dann auch 6 Grakas Single-Slot in X16 Steckplätze rein. Theroretisch sind auch 4 Single-Slots und 2 Dualslot Karten mit extra Stromstecker möglich. Als CPU bleibt wohl nur ein 3770K über.Es stellt sich die Frage ob man auch 2 Graka Projekte parallel rechnen kann – samt definition welche Graka wo rechnet. So wäre es möglich POEM zu optimieren und parallel ein 100% GPU-Projekt zu rechnen. So wäre es sicher möglich 6 GRAKAS in einem Rechner auszunutzen.

-

30. Dezember 2012 um 20:12 Uhr #931265

ulv

TeilnehmerDass Poem mehr Punkte/Tag macht je mehr die CPU glüht verstehen wir denke ich alle. Wie gut das auch für Punkte/Watt gilt ist für mich immer noch offen.

Nix gegen Poem aber ich denke wir müssen nochmal grundlegend entscheiden ob der neue vom Design her ein 100%-GPU Rechner werden soll oder bzw. oder auch ein Poem-CPU-GPU-Hybrid.

BTW: Wenn es bei Poem einen deutlichen Unterschied zwischen Single-, Dual- und Tripple Channel RAM gibt dann ist vermutlich auch der PCIe x1 eine große Poem-Bremse.

-

30. Dezember 2012 um 21:12 Uhr #931266

isch

TeilnehmerJa Quadchannel auf einem x79 ist am schnellsten und schneller RAM bringt auch noch mal einiges.

Aber die x79er Boards/CPU verbrauch ja so viel.

Hier noch der 3930k@3,8GHz, MSI X79A-GD45 (8D), 16GB DDR1600 Quadchannel mit 3 x HD7750@900MHz.

GPU1, PCIe3.0 x16, mit 6WUs, GPU-Last 92%, 2050s, gibt 740k

GPU2, PCIe3.0 x16, mit 6WUs, GPU-Last 92%, 2050s, gibt 740k

GPU3, PCIe3.0 x8, mit 6WUs, GPU-Last 91%, 2230s, gibt 680k

= 2160k/Tag bei 270WHier mal mein Sys

i7 3770k 4,3GHz @ 1,176V

MSI Z77A-GD55

Crucial SATA RealSSD C300

16GB Crucial Ballistix Tactical 1600MHz @ 8-8-8-24-1T @ 1,4V

HIS Radeon HD 7870 GHz Edition @ Arctic Cooling Accelero S1 Plus mit 2 Noiseblocker NB-eLoop S-Series B12-1 @ 5V

FSP Fortron/Source Aurum Gold 400WIdle 43W-44W

Prime95 129W

8x Leiden in einer VM 110Wmacht noch 160W für 3 Grakas die aber bei weitem nicht so viel verbrauchen.

Wenn ich jetzt noch runter takten und die 7870 raus nehme bin ich bei weit unter 100W

-

30. Dezember 2012 um 22:12 Uhr #931271

littledevil

TeilnehmerNaja soviel ist das doch gar nicht. Du müßtest den 3770k ja auf über 5GHz laufen lassen, um eine vergleichbare Leistung zu erzielen… :devil:

Ich denkemal, das man mit optimeirungen da schon einiges heraus holen kann.

Habe leider immer noch keine CPU für mein GIGABYTE X79-UD3

-

31. Dezember 2012 um 11:12 Uhr #931289

Burntime

TeilnehmerWieviel CPU-Leistung bräuchte ich denn um mit 12 Grafikkarten zu Arbeiten?Würden 6 Xeon Kerne mit 2 GHZ ausreichen?

-

31. Dezember 2012 um 14:12 Uhr #931297

Lukas

Teilnehmer@above

Irgendeiner hat ausprobiert dass der 3770k mit 1 GK 30 % Auslastung hatte und mit 2 ca. 60 % ( sofern ich mich erinnern kann 😀 ) also 3 90 % und 4 waren 120 % ( geht ned ) der 37k hat 4 kerne und kann drei Gpus nutzen also müsste ( stimmt auch nicht kommt auf CPU an) der Xenon 5 schaffen. -

31. Dezember 2012 um 14:12 Uhr #931299

isch

TeilnehmerBei 2GHz verhungern dir die Grakas.Damit kannst nicht mal eine Karte ordentlich versorgen.Bei den Optimierten Anwendungen auf die ATI 7xxx und NV 6xx Karten wir auch viel CPU Power benötigt (da für diese aufgaben die GPU nicht geeignet oder zu langsam ist)

-

31. Dezember 2012 um 15:12 Uhr #931302

Lukas

TeilnehmerWirf hier mal noch eine Idee in den Raum 😀

Headpipe Kühler wird aber bei der idee nix wenn mans aus der Perspektive nimmt

Schreibt euren Komments ruhig dazu

P.S Bin nicht sehr gut in Sketchup 🙂

-

31. Dezember 2012 um 16:12 Uhr #931307

Lukas

Teilnehmer@ ulv Meinst du dass allgemein oder spezifisch auf meine Zeichnung?

-

31. Dezember 2012 um 16:12 Uhr #931304

ulv

TeilnehmerAlso ihr würde euch bitten einen eigenen Thread für einen Poem-Only-Rechner aufzumachen.

Das passt aus meiner Sicht einfach nicht zusammen!