News: NextGen Grafik, PCI-E 2.0 …

Willkommen in der Mk-Community › Foren › Hardware › PC Komponenten › Grafikkarten › News: NextGen Grafik, PCI-E 2.0 …

- Dieses Thema hat 133 Antworten und 32 Teilnehmer, und wurde zuletzt aktualisiert vor 17 Jahren, 1 Monat von

bluefisch200.

-

AutorBeiträge

-

-

11. Oktober 2006 um 16:10 Uhr #644541

tobomax

Teilnehmerhey, danke für die infos!

ich frag mich nur warum die jetzt schon wieder ne neue schnittstelle rausbringen wollen. pcie is doch noch gar nicht soo alst.

weisste wann der g80 chip von nvidia rauskommt?

-

11. Oktober 2006 um 16:10 Uhr #644545

-

11. Oktober 2006 um 16:10 Uhr #644544

steeve

Teilnehmertobomax said:

Weisste wann der G80 chip von nvidia rauskommt?Die karten sollen angeblich schon im november käuflich sein … das wird aber eher das gleiche spiel wie letzte generation: die karten sind raus, nach zehn tagen waren alle shops leer [zu wenig karten]. Die ATI karte kommen ungefähr ein monat später, deswegen würde ich abwarten … man weiß nie was die konkurrenz noch so verdeckt hält 😉 .

Und was PCI-E 2.0 angeht, echt krank. Als ob 2.5 Gbps nicht ausreichen werden und dazu noch sind die stolz, dass die schnittstelle bis zu 300W liefern kann 😡 … toll, solche karten hole ich mir aus protest nicht, egal wie stark die sind.

-

11. Oktober 2006 um 16:10 Uhr #480209

steeve

TeilnehmerIm internet findet man viele news zu NextGen-grafikkarten von ATI und nVidia. Auch die neue PCI-E schnittstelle ist fertig und heißt PCI-E 2.0. Deswegen poste ich hier eine kleine sammlung an links und bildern:PCI Express 2.0 [news.com.com] ist wie gesagt neue schnittstelle für grafikkarte. Hauptgrund warum dies eingeführt wird ist die geschwindigkeit: sie wird sich von 2.5Gbps [PCI-E 1.0] auf 5Gbps verdoppeln und die schnittstelle an sich wird die grafikkarte mit mehr strom versorgen können, die rede ist von 225 bis 300 watt.Hier [pcgameshardware.de] findet ihr die infos zu neuen nVidia-karten:

Geforce 8800 GTX:Chiptakt: 575 MHzSpeichertakt: 900 MHzSpeichermenge: 768 MByteSpeicherinterface: 384 BitTheoret. Speicherbandbreite: 86 GByte/sShaderzahl: 128 Unified-Shader mit 1.350 MHzGeforce 8800 GTS:Chiptakt: 500 MHzSpeichertakt: 900 MHzSpeichermenge: 640 MByteSpeicherinterface: 320 BitTheoret. Speicherbandbreite: 64 GByte/sShaderzahl: 96 Unified-Shader mit 1.200 MHz

Wie es aussieht, wird die grafikkarte luftgekühlt, aber der kühler ist so konzipiert sodass man hat auch möglichkeiten hat den kühler mit wasser zu kühlen [wasserkühlung vorausgesetzt] … ich finde die idee gut.ATI dagegen hält ihre karten wenig verdeckt, bekannt ist nur, dass die GPU mit über 700 MHz getaktet wird und dass R600 über 500 Mill transistoren hat [nicht offiziell bestätigt]. Bei PCGH wird die karte als echter monster bezeichnet, die karte an sich ist deutlich schneller als schnellste DX9-karte. Trotzdem gibt es neuigkeiten bei ATI, die man sehen kann ^^:

// Sorry für die auflösung, die bilder habe ich nur von dailytech.com verlinkt.Hier [dailytech.com] findet ihr infos zu RV570.Interessant bei neuen ATI-karten sind aber [vorletztes bild] die “anschlüsse” die man üblicherweise bei SLI-nVidia-karten stehen. Sieht ganz danach aus, als hätte ATI die Crossfire-technik “leicht” modifiziert und man würde dazu noch sagen, dass man auch da vier karten anschließen kann. Stromverbrauch ist übrigens nur leicht angestiegen. PS: X1950 Pro wird ~200€ kosten und deutlich schneller als die X1900 GT.Die karten beider hersteller werden echte monster sein, trotzdem muss man abwarten um zu sehen wie sich die Unified-Shader-Architektur in der praxis schlägt. Die karte kommen ende 06 bzw anfang 07 [ab november gehts los] … Es gab gerüchten, dass die karten bis zu 300W fressen werden, das stimmt nicht, keine der (einzel)karten beider hersteller wird die 200W grenze überschreiten, was sich gut anhört, aber trotzdem zuviel ist. Naja, alles was man noch sagen kann ist abwarten und :kaffee: …Quellen: news.com.com, dailytech.com, pcgameshardware.deBilder: pcgameshardware.de, dailytech.com

-

11. Oktober 2006 um 16:10 Uhr #644547

steeve

TeilnehmerKäsetoast said:

@steeve:Hast du bezüglich der Leistungsaufnahme auch eine offizielle Quelle parat? Fänd’ ich sehr nützlich um endlich die ganzen Gerüchte um die 250 / 300 Watt Kraftwerke nicht nur mit Logik, sondern auch mit harten Fakten wiederlegen zu können… 😉Also die ATI high-end karte sollte angeblich max 160W verbrauchen [jetzt sind es 125W] und nVidias high-end karte wird auch angeblich einige watt mehr verbruchen [jetzt 145W]. Suche gerade die links als beweismittel …Die 250/300 W wären echt abnormal, dann könnte man die karten nur mit der wakü kühlen, massentaglich wär das nicht wirklich.

-

11. Oktober 2006 um 16:10 Uhr #644543

Patty

Teilnehmerklasse, war dringend notwenig, wo pcie schon so alt ist:x

finde ich jetzt mal total schwachsinnig… -

11. Oktober 2006 um 17:10 Uhr #644553

An00bis

Teilnehmerdie angabe von 128 unified shadern halte ich für nicht realistisch

-

11. Oktober 2006 um 17:10 Uhr #644556

Edder

TeilnehmerWahnfried said:

Ist echt ne Frechheit fals es nicht gehen sollte,denn ich glaube nicht das dann auch Boards mit Sokel939 und PCI-E2.0 geben wird!ich glaube auch das 939 Boards das nicht mehr unterstützen werden, wenn ich das mit PCI-E 2.0 vorher gewusst hätte, hätte ich mit dem Boardkauf noch etwas gewartet, frechheit.:evil:

warum kann es nicht standard Sockel und standard Steckplätze geben ???:-k -

11. Oktober 2006 um 17:10 Uhr #644555

Poweruser

TeilnehmerIch hoffe die Wasserkühlung ist mehr als nur der gebogene Kanal, den man durch die Plastikabdeckung sieht, ansonsten liegt die WaKü Temp in ungewöhnlichen Bereichen… 😆

-

11. Oktober 2006 um 17:10 Uhr #644554

Wahnfried

TeilnehmerPCI-E 2.0, werden dann aktuelle Boards mit einem BIOS-Update fit gemacht oder muss man sich ein neues Kaufen ?

Na das würde mich auch ganz brennend Interessieren!Ist echt ne Frechheit fals es nicht gehen sollte,denn ich glaube nicht das dann auch Boards mit Sokel939 und PCI-E2.0 geben wird!Das würde für mich heißen das ich alles was ich vor 8Monaten 😮 gekauft habe CPU/BOARD/Graka/RAM mit viel verlust verkaufen müßte !:evil: Das fänd ich SCHHHAAADE :evil:Tschau TH.

-

11. Oktober 2006 um 17:10 Uhr #644550

Edder

TeilnehmerPCI-E 2.0, werden dann aktuelle Boards mit einem BIOS-Update fit gemacht oder muss man sich ein neues Kaufen ?

wegen der nötigen Kühlung setzen solche Karten aber auch mechanische Änderungen an PC-Gehäusen voraus.

das habe ich grade gelesen, kommt dann deswegen auch nen neuer Gehäusestandard heraus ? weis das vielleicht jemand ?

-

11. Oktober 2006 um 17:10 Uhr #644557

Käsetoast

TeilnehmerSoweit ich weiß, wollte man PCI-E 2 ähnlich wie bei AGP abwärtskompatibel halten. Ob das dann aber auch so umgesetzt wird, kann ich jetzt leider nicht beschwören…

Mahlzeit

Käsetoast -

11. Oktober 2006 um 20:10 Uhr #644595

ArcticRevenge

TeilnehmerZitat von Poweruser

Ich hoffe die Wasserkühlung ist mehr als nur der gebogene Kanal, den man durch die Plastikabdeckung sieht, ansonsten liegt die WaKü Temp in ungewöhnlichen Bereichen…Boah ich lach mich krumm:D . Das wär ja echt die größte Frechheit in der PC Geschichte.x(

-

11. Oktober 2006 um 20:10 Uhr #644588

steeve

TeilnehmerWahnfried said:

PCI-E 2.0, werden dann aktuelle Boards mit einem BIOS-Update fit gemacht oder muss man sich ein neues Kaufen ?

Na das würde mich auch ganz brennend Interessieren!Ist echt ne Frechheit fals es nicht gehen sollte,denn ich glaube nicht das dann auch Boards mit Sokel939 und PCI-E2.0 geben wird!

Also das wird überhaupt nicht gehen. Wenn da steht, dass neuer slot 225 bis 300 watt liefern wird, dann müssen die da etwas elektrisch ändern damit das überhaupt funktioniert. Und ganz ehrlich gesagt glaube ich irgendwie, dass der slot auch anders aussehen wird … jetztige PCI-E slots haben 16 lanes und ich glaube, dass PCI-E 2.0 24 oder sogar 32 lanes haben wird [nochmal: ist nur meine vermutung ^^].

Wahnfried said:

Das würde für mich heißen das ich alles was ich vor 8Monaten 😮 gekauft habe CPU/BOARD/Graka/RAM mit viel verlust verkaufen müßte !Wenn Du genug schnelle teile hast, dann musst die gar nicht erst verkaufen. Man muss nicht immer das schnellste haben 😉 … aus dem grund kaufe ich mir auch keine super hardware. Das wort zukunftssicher ist mittlerweile ein scherz. Man sieht am besten an zwei beispielen: 1) vor kurzer zeit ist AM2 rausgekommen und schon jetzt ist die rede von AM2+ bzw AM3; 2) bei intel hat man socjel 775 seit einiger zeit, aber in der zeit musste man immer wieder neues board für neue cpus holen: 900er serie für normale cpus, dual-core ging erst ab 945-serie, dann kam core-duo wieder was neue, jetzt hat man core2duo auch neuer chipsatz und für quad-core wird auch was neues brauchen …Deswegen hört am besten auf alten steeve ^^:-minimales board kaufen mit guten eigenschaften und OC-freundlich, von guten herstellern wegen BIOS-updates-kleine bis mittlere cpu kaufen und passend [dual oder single, nicht das man später bereut, die cpus gibts nicht mehr]-speicher soviel kaufen, wieviel man braucht, vielleicht “bisschen” mehr, wenn man sieht, dass die preise drastisch steigen werden [z.b. DDR1]-gute grafikkarte -> mittel bis oberklasse für intensive spieler – auch auf eigenschaften achten: neuste technik wie z.b. ShaderModel 3 …-beim netzteil kann man ruhig bisschen mehr ausgeben und dann muss auch das netzteil nicht immer neukaufen-bei den laufwerken auch gute teile holen, weil da sich sowieso nicht viel ändertWenn man nach dieser art kauft, dann ärgert man sich später auch nicht, dass man was weiß ich wieviel für die hardware ausgegeben hat und dass die nichts mehr wert sind … für spieler ist ehe die graka das wichtigste, speicher kann auch bei ebay relativ günstig kaufen und cpu kann übertakten. So holt man sich mehr leistung und man hat auch spaß an hardware … einfach pragmatisch nachdenken ^^ .

-

11. Oktober 2006 um 21:10 Uhr #644602

-666-

Teilnehmerdas mit dem neuen PCI-e Slot find ich erlich ehrlich gesagt auch eine frechheit dann darf man sich ja wieder n neues Mobo + Grafik zulegen:evil:

-

11. Oktober 2006 um 21:10 Uhr #644606

steeve

Teilnehmer-666- said:

das mit dem neuen PCI-e Slot find ich aich ehrlich gesagt auch eine frechheit dann darf man sich ja wieder n neues Mobo + Grafik zulegen:evil:Muss man aber nicht …

Die die z.b ein board mit nforce3 ultra und AGP haben kommen vollkommen klar: nforce3 kommt mit dual-core klar und eine starke AGP-karte findet immernoch [7800er].

Auch derjenige der ein 754 system hat, kann ruhig bis ende 2006 abwarten, wenn er unbedingt dual-core haben will, am sonsten kann er weiter sein pc nutzen. -

11. Oktober 2006 um 21:10 Uhr #644612

Edder

Teilnehmer-666- said:

das mit dem neuen PCI-e Slot find ich erlich ehrlich gesagt auch eine frechheit dann darf man sich ja wieder n neues Mobo + Grafik zulegendas habe ich auch gedacht, aber jetzt denk ich anders:D

ich glaube ich werde mir das was steeve gesagt hat ans Herz legen, wieso immer die beste Hardware haben und dann nur ärgern wie ich.

-

12. Oktober 2006 um 1:10 Uhr #644647

-666-

Teilnehmerdie Karte soll potenzial haben mal sehen was erste tests zeigen wenn die draußen ist

-

12. Oktober 2006 um 4:10 Uhr #644653

Titan

Teilnehmer-666-;177243 said:

das mit dem neuen PCI-e Slot find ich erlich ehrlich gesagt auch eine frechheit dann darf man sich ja wieder n neues Mobo + Grafik zulegen:evil:dafür hab ich mir des asrock mit uli chipsatz geholt um das ich nich glaich noch ne neue graka kaufen muste

-

12. Oktober 2006 um 9:10 Uhr #644668

Neptun

Moderatorinteressante Infos…

-

12. Oktober 2006 um 10:10 Uhr #644677

Wahnfried

TeilnehmerWenn Du genug schnelle teile hast, dann musst die gar nicht erst verkaufen. Man muss nicht immer das schnellste haben

Jaa hast ja recht 🙄 !Mein System ist mit deinem fast identisch,außer der 7900GT EE die ich besitze(alles siehe Profil)!Geht auch echt ab wie ein Zäpfchen(ca54003Dmarks im 06er). :)Ich spiele aber fast immer in 1280×1024 und AA,und sehr Grafiklastige Spiele,und ich hoffe das ich das in nem Jahr auch noch kann.(ich glaube nich so recht dran). x(Es ist ja schon ein Prob ne ident. 7900GT zu bekommen!War gestern mal Shoppen und bekam zu hören das es nur noch 7950er gibt und das auch nich funzt wegen,ist anderer CHIP! :(Stimmt das überhaupt,damit SLI funzt müssen die Karten ein Ident. Bios haben?? TH.

-

12. Oktober 2006 um 11:10 Uhr #644682

steeve

TeilnehmerWahnfried said:

Ich spiele aber fast immer in 1280×1024 und AA,und sehr Grafiklastige Spiele,und ich hoffe das ich das in nem Jahr auch noch kann.(ich glaube nich so recht dran). x(Stimmt, wenn man sich alleine die (mindest-)anforderungen bei Crysis, Splinter Cell 4, Gothic 3 … anschaut kriegt man schon gänsehaut.

Wahnfried said:

Es ist ja schon ein Prob ne ident. 7900GT zu bekommen!War gestern mal Shoppen und bekam zu hören das es nur noch 7950er gibt und das auch nich funzt wegen,ist anderer CHIP! :(Stimmt das überhaupt,damit SLI funzt müssen die Karten ein Ident. Bios haben??Das ist ein grund, warum ich SLI damals kritisiert habe … als hätte ich das gewusst, habe ich immer gesagt: das wird nur ne reine abzocke sein, wie schnell sich markt entwickelt, wird daraus nichts … sich nach z.b. einem jahr ganz entspannt zweite graka zu holen und die leistung zu “verdoppelt” [in der praxis sind es aber 0%-80%, meist aber nur 50% – wenn das spiel optimiert ist] … entweder muss man sich sofort zwei karten holen [was meiner meinung nach absurd ist, 100% mehr preis für 50% mehr leistung] … oder man holt sich die karte bei ebay [was nicht immer risikofrei verläuft].Die chips müssen gleich sein, dass mit BIOS geht, wenn die karten verschiedener hersteller sind [z.b. Sparkle und Powercolor], wenn SLI nicht funktioniert, dann installiert man auf der anderen karte gleiche BIOS-version wie bei der ersten karte und dann funktioniert das … aber bei verschiedenen chips wird das nicht gehen. Es gab auch berichte von foren-usern die nicht mal eine GT und GTX version zusammen zum laufen brachten.

-

12. Oktober 2006 um 14:10 Uhr #644698

Wahnfried

TeilnehmerStimmt, wenn man sich alleine die (mindest-)anforderungen bei Crysis, Splinter Cell 4, Gothic 3 … anschaut kriegt man schon gänsehaut.

Genaaau so ist das! 😉 Und Crysis will ich doch auf jeden fall Zocken!!!Haste mal die Demos gesehen 😯 😯 total Abgefahren!!Habe bei E-Bay mal gesucht.Es gibt aber nur ne XFX 7900GT Extr. Ed. VIVO.Was denkst du ob das Funztwenn ich meine”NICHT VIVO”(Tacktraten alles gleich)und Die im SLI verbund betreiben würde??Wei gesagt meine ist genauso aber hat KEIN Video in!und könnte man diese Funktion noch nutzen???Sorrry an alle,wegen”Nicht zum Thema gehörend” :)TH

-

12. Oktober 2006 um 18:10 Uhr #644717

tuxthekiller

TeilnehmerIch warte mal auf Rat von dem “alten steeve”:

Soll ich jetzt die Karte kaufen: http://geizhals.at/deutschland/MSI_NX7900GTO-T2D512E_V801-089_a216395.html ?

Oder auf die neue Generation warten? ich habe ein Sockel 939 System. -

13. Oktober 2006 um 1:10 Uhr #635347

steeve

Teilnehmer@WahnfriedDas kann ich dir schon nicht mit 100% sicherheit sagen … am besten Du suchst die leute die sowas praktisch besser kennen, die können schon genau sagen, was geht und was nicht. [Hardwareluxx oder Computerbase haben monumentale foren, da findest Du ne antwort 99,9% ;)]@tuxthekillerAm besten Du holst die karte, für ~230€ hast Du power und 512MB, die karte geht beim OCen sehr gut ab. Auf die neue generation zu warten lohnt sich nicht, weil die karten am anfang 500€+ kosten werden [kleinre modelle kommen später erst] und v!sta an sich wird müll. Ja ok DX10 und SM4.0 werden schön aussehen, aber da stimmt dieser preis/leistung-verhältnis nicht mehr.Kurz und knapp: hol dir die karte, die Du gepostet hast, hast spaß daran und dann in ungefähr einem jahr, wo die technik [DX10 / SM4.0] nicht mehr so neu ist, wenn v!sta auch einigermaßen “stabil” läuft und natürlich wenn neue AMD cpus rauskommen 😉 [falls bedarf auf neue cpu/speicher/board besteht, aber eher nicht :-k] … erst dann kannst Du ruhig zu nextgen-karten greifen, dann lohnt sich das auch, dann gibts auch spielen die davon gebrauch machen.Alles klar … fragen ^^ ?EDIT:Hier [xtremesystems.org] ein test zu der grafikkarte.

-

21. Oktober 2006 um 16:10 Uhr #646029

braeter

TeilnehmerRate mal wer gestern 2 bestellt hat und auf n Liefertermin wartet ^^

-

21. Oktober 2006 um 16:10 Uhr #646030

milhouse

Teilnehmerdas passt aber nicht zu deiner sig 😛

-

21. Oktober 2006 um 16:10 Uhr #646027

toor

TeilnehmerIch habe gerade bei bit-tech einen Test (engl.) zur ATi Radeon X1950 Pro von Sapphire entdeckt. 😀

Viel Spass beim Lesen 🙂

-

21. Oktober 2006 um 19:10 Uhr #645944

F!ghter

TeilnehmerWie krank das doch ist… 😮

Vor nem Jahr hatte ich schon das Thema Aufrüsten zurückgestellt, d aich warten wollte bis PCIe ausgereift ist und es mehr Angebot auf dem Markt gibt zu den neuen Technologien jetzt kommen sie schon wieder mit dem nächsten…und ich kann mir noch ned ma PCIe leisten -.- 😡

Sinn wo bist du? Die Karten bringen mehr Leistung als jedes neuste Spiel überhaupt braucht. Lohnt es sich da soviel Geld auszugeben? Meiner Ansicht nach nicht aber ich bin auch kein Freund der “Ah ne neue Graka kaufen wa die mal auch wenn sie nach 3 Wochen 200öken billiger ist hauptsache aktuell) 🙁

-

21. Oktober 2006 um 20:10 Uhr #646053

braeter

TeilnehmerWie is das gleich noch mit den Links gewesen? ;)Hab meinen Kauf auch nach dem Bericht von k-Hardware getätigt.Wer die Graka kauft, sollt sich im klaren drüber sein das was das Ocing angeht, kaum noch was drin sein wird.VoltMod oder die Option die PCI-E Spannung im Bios anzuheben muss da schon gegeben sein.In meinem Fall aber n kluger kauf mein ich.

-

21. Oktober 2006 um 20:10 Uhr #646046

DeriC

Teilnehmermanchmal braucht man gar net soweit übern Tellerrand schauen 😉 http://www.k-hardware.de/artikel.php?s=&artikel_id=5901

[SIZE=”1″]Quelle:[/SIZE] [K-Hardware.de] :+

-

21. Oktober 2006 um 21:10 Uhr #646058

braeter

TeilnehmerDericC, danke für den sanften schlag mit m Vorschlaghammer. Habs grad geändert 😉

-

21. Oktober 2006 um 21:10 Uhr #646057

DeriC

Teilnehmer:wie: 😉 hatte schlauerweise erst auf die MK News verlinkt, deswegen keine Quelle angegeben, aber das wollt natürlich wieder net richtig, weswegen ich nur schnell den Link getauscht hab, das “Pe(r)fekte Posting” 😀 hatt ich dabei dann leider völlig ausgeblendet

-

21. Oktober 2006 um 23:10 Uhr #646065

WaldSchRad

Teilnehmerich erhoff mir durch diese neue schnittstelle preissenkungen.

also eigentlich hats auch nen sinn… -

22. Oktober 2006 um 0:10 Uhr #646073

steeve

TeilnehmerDie X1950Pro ist auf jeden fall neuer preis/leistungs-hammer. Die karte ist schon ab ~170€ zu haben und von der lesitung her mit der 7900er GT zu vergleichen.Ich bin allgemein gegen SLI/Crossfire, aber wenn sich jemand dual-graka-system auf basis dieser karten aufbaut, dann ist das ok [da zwei karten insgesamt ~350€ kosten].Ganz nebenbei … die karte wird wenig strom verbrauchen [vielleciht sogar weniger als konkurrenz :-k], da ATI mit 80nm angefangen hat.

-

22. Oktober 2006 um 2:10 Uhr #646077

braeter

TeilnehmerVon 98 watt unter last ist die Rede. 5 Watt mehr als die 90nm nVidia.

-

22. Oktober 2006 um 22:10 Uhr #646216

steeve

TeilnehmerBin gerade auf interessante news gestoßen:

[SIZE=”4″]ATi Radeon X1950 Pro für AGP[/SIZE]

[SIZE=”1″]Quelle: ComputerBase.de[/SIZE]Die AGP-board-besitzer können sich echt freuen. Noch ein grund mehr nicht auf neuste plattform umzusteigen, falls noch nicht … ATi *schulterklopf* :d: .

-

22. Oktober 2006 um 23:10 Uhr #646219

Käsetoast

TeilnehmerOb die X1950 Pro (also als PCIe Version) vom Layout her mit den anderen X1900er Karten ist, weiß hier aber auch keiner, oder? Habe bisher nur Nahaufnahmen vom Chip sowie Bilder mit Luftkühler gesehen. Wäre nämlich schon eine Überlegung wert die anstatt der X1900 XT zu kaufen. Vorher müsste ich halt wissen, ob da der GPU-X draufpasst… :-k Ach ja – Bei tweakpc.de gibt’s schon nen Test dazu…MahlzeitKäsetoast

-

1. November 2006 um 21:11 Uhr #646852

-666-

Teilnehmerhab heute einen Artikel über die 8800GTX gelesen klingt sehr vielversprechenddie Karte siehe linkhttp://vic.expreview.com/attachment/1161849814.jpg

-

1. November 2006 um 21:11 Uhr #646861

steeve

Teilnehmer-666- said:

hab heute einen Artikel über die 8800GTX gelesen klingt sehr vielversprechenddie Karte siehe linkhttp://vic.expreview.com/attachment/1161849814.jpgAlso wenn ich ganz ehrlich bin, ist das gar nicht interessant. Vor allem, weil man 3dmarks relativ leicht manipulieren kann [es gab wenige fälle wo hersteller einiges versuchten].Die graka kann man erst als interessant abstempeln, wenn man reale spieleenchmarks sieht … und die karte wird erst richtig interessant, wenn man auch die konkurrenz vergleichen kann … 😉

-

5. November 2006 um 0:11 Uhr #647388

steeve

TeilnehmerHier bei xbitlabs.com gibts ein test zu neuer X1950Pro.

Im test wurde die karte auf herz und nieren geprüft, unter anderem auch stromverbrauch:

[SIZE=”1″][Bildquelle: xbitlabs.com][/SIZE]65W bei volllast und 30W im durchschnitt im leerlauf finde ich sehr gut. Wer sich einen spielerechner mit niedrigem stromverbrauch zusammenbauen will, kann ruhig die X1950Pro verwenden.

X2 3800+ EE SFF -> 35W

Radeon X1950Pro -> 65W

ATI RD580 _____ -> >10W

Speicher 2xriegeln-> 5W

1xHD + 1xDVD-RW-> 15W=> Nicht mal 150W bei volllast erreicht der rechner [im leerlauf wären es ~65W] und hat genug leistung für alle aktuelle und [nah]kommende spiele.

Ist das nicht ein traum-pc?

-

5. November 2006 um 0:11 Uhr #647393

-666-

Teilnehmersteeve;181525 said:

-666- said:

hab heute einen Artikel über die 8800GTX gelesen klingt sehr vielversprechend

die Karte siehe linkAlso wenn ich ganz ehrlich bin, ist das gar nicht interessant. Vor allem, weil man 3dmarks relativ leicht manipulieren kann [es gab wenige fälle wo hersteller einiges versuchten].

Die graka kann man erst als interessant abstempeln, wenn man reale spieleenchmarks sieht … und die karte wird erst richtig interessant, wenn man auch die konkurrenz vergleichen kann … 😉ich werde 2 bekommen warscheinlich dann kann ich mal reale ergebnisse posten vorrausgesetzt ich find n Case wo die reinpassen weill 27c in der länge ist schon sehr viel

-

5. November 2006 um 12:11 Uhr #647454

vamp

TeilnehmerEs kommt immer darauf an mit welchen Einstellungen man ein Spiel spielen möchte. 24″ Displays sind mit 1000€ gar nicht mal so teuer geworden. Wenn ich mal im Vergleich mit meinen 18″ Dell TFT Display vor 4 Jahren vergleiche, der 830€ gekostet hat.

Entprechend wird auch die Auflösung werden, nähmlich 1920X1200. Und ob da 2X 7900GTOs nicht zu schwach dafür wären :-kDie 8800GTX ist bis zu 100% schneller als die 19500XTX. Was hat nochmal die 6800Ultra bei ihrer Einführung gekostet ? 😉

edit: Der Stromverbrauch ist auch nicht so monströs. Zählt mal wieviel 2 Karten aus dem Midrange zusammen verbrauchen werden.

Hier ist der Benschmark von GTX…

-

5. November 2006 um 15:11 Uhr #647497

vamp

TeilnehmerVerstehe deinen Sarkasmus nicht. Irgendwann sind die Grenzen des Machbaren eben erreicht.

Ich glaub dein Problem ist dass du einfach zuviel von der Karte erwartet hast und nun wurden die nicht ganz erfüllt.

Sowohl vom Preis her als auch von der Leistung ist die Grafikkarte in Ordnung.Und wie kommts dass offensichtlich Niemand ausser dir die genauen Spezifikationen von der kommenden R600 kennt ?

Wie gut die im allgemeinen wird kannst du wohl kaum wissen. Also, Ball flach halten -

5. November 2006 um 15:11 Uhr #647491

steeve

Teilnehmervamp said:

Die 8800GTX ist bis zu 100% schneller als die 19500XTX.Toll, nVidia hat echt tolle arbeit geleistet =D> . Eine neuentwickelte graka ist schneller als eine der letzten generation.Lass uns mal bitte sehen wie schneller ist die X1900XTX als die alte 6800Ultra [@ computerbase.de]: @1280×1024 4xAA/16xAF durchschnitt aus allen spielen-> 6800 Ultra – 29,1 fps-> X1900XTX – 72,7 fps=> ~250%Interessant zurückzublicken … aber die [eine generation jüngere] ATI karte ist nicht 100% sonder 250% schneller … interessant. 😉

vamp said:

edit: Der Stromverbrauch ist auch nicht so monströs. Zählt mal wieviel 2 Karten aus dem Midrange zusammen verbrauchen werden.Stromverbrauch ist sehr hoch … die neue geforce frisst schon im leerlauf 50W mehr. Zwei stromanschlüsse sehen schon bisschen krank aus … die karte verbrauch bestimmt knapp 200W. Im leerlauf wären es dann 80-90W 😯 😡 .

vamp said:

Hier ist der Benschmark von GTX…http://dailytech.com/article.aspx?newsid=4812OK, das sind die ersten benchmarks … das erinnert mich bisschen an Core2-Duo-CPU. In Intels gesponsorten hinterzimmertests war die CPU 40-50% schneller, am ende hat sich rausgestellt, dass die cpu nicht mal die hälfte davon schneller ist.Also lieber abwarten … 😉 Mein persönlicher fazit lautet:G80 ist eher eine lachnummer:- GDDR3-Speicher -> max 900MHz – nichts übertakten 😆 – 384 bit speicheranbindung- in 90 nm gefertigt -> hoher stromverbrauch-> hoher stromverbrauch und nichts dahinterR600 wird schneller weil:- GDDR4-Speicher -> max 1450MHz – come on baby *peitschenklang* 😉 – 512 bit speicheranbindung- in 65 nm gefertigt -> wird weniger strom verbrauchen als jetztige X19er serieVor allem interessiert mich wie die texturfilterung arbeitet und ob dies endlich kein flimmerkasten mehr ist, wie man es bei jetztiger 7er serie kennt…Tut mir leid n vidia, aber so eine schrott-karte kommt mir nicht in die kiste … [-(

-

5. November 2006 um 15:11 Uhr #647494

Spicy_Ice

TeilnehmerHAllo

Die Ati X1950 hat ja schon GDDR4 verbaut.Das sollte man auch nicht vergessen.Wenn jetz alle 4 Monate eine Neue Grafikkarten generation rauskommt,dann wird es wieder Schuldner geben ,wie damals als die Medien von den Handys die Jugendlichen benutzen sprachen.:D

Gruß Spicy

-

5. November 2006 um 16:11 Uhr #647505

Käsetoast

TeilnehmerMich interessiert eher Folgendes:

Gibt’s beim G80 jetzt wirklich “echte” Unified Shader, oder bleibt es bei dem, was man uns bis vor zwei / drei Monaten die ganze Zeit verklickert hat und zwar das man einfach an die bisherige Architektur ne Geometry Shadereinheit “dranpappt”?Oft wird auch davon geredet, dass der G80 Refresh dann ja mit GDDR4 aufwarten wird. Ich halte das bislang noch für ein wenig unwahrscheinlich, da dafür ja der komplette Speichercontroller umgebaut werden müsste und das wird sich nur für einen Refresh nicht lohnen. ATIs Ringbus-Controller hingegen ist ja schon länger dafür ausgelegt (ich bin mir jetzt aber nicht sicher ob’s schon bei den X1800ern oder erst bei den X1900ern auch wirklich verfügbar war)…

Am Meisten interessiert mich aber eigentlich auch, ob NVIDIA jetzt endlich mal die Filteroptimierungen zurückgedreht hat und was qualitativ hochwertigeres anzubieten hat…

Mahlzeit

Käsetoast -

5. November 2006 um 16:11 Uhr #647503

steeve

Teilnehmervamp said:

@steeveVerstehe deinen Sarkasmus nicht. Irgendwann sind die Grenzen des Machbaren eben erreicht.Ich glaub dein Problem ist dass du einfach zuviel von der Karte erwartet hast und nun wurden die nicht ganz erfüllt.Sowohl vom Preis her als auch von der Leistung ist die Grafikkarte in Ordnung.Ich hab kein problem. Problem im allgemeinen ist, dass erst eine grafikkarte rauskommt und niemand auf die der konkurrenz abwarten will und schon ist die grafikkarte die beste, obwohl die karte nicht so tolle ist. Nicht nur die leistung zählt…Eine andere frage: würdest Du dir einen wagen holen, der 50l auf 100km verbraucht holen, obwohl er “nur” 250km/h erreicht. 250km sind auf jeden fall schnell, aber wenn man die 50l benzinverbrauch ansieht [ohne die versicherungskosten] ist der wagen eher flop als top. Verstehst Du was ich sagen will?Und was G80 angeht: jetztige architektur, die nvidia seit der FX-serie immer wieder verbessert, wird schon sehr bald durch neue ersetzt werden müssen. Seit der FX-serie wird die leistung auf kosten der bildqualität gesteigert und langsam werden die etwas unternehmen müssen, besonders wenn sie die R600 in der aktion sehen. ATI hat die teile letzter architektur vom grund auf neuentwickelt und jetzt kommt die zeit wo dieser chip nur weiter optimiert wird [siehe entwicklung von R520 bis R580]. Deswegen bin ich der meinung, dass der R600 um einiges schneller wird und [wie immer bei ATI so ist] wird auch die bildqualität besser. Und wegen dem 65nm fertigungsprozess wird die karte viel sparsamer sein als die 8800er.

vamp said:

Und wie kommts dass offensichtlich Niemand ausser dir die genauen Spezifikationen von der kommenden R600 kennt ?Wie gut die im allgemeinen wird kannst du wohl kaum wissen. Also, Ball flach haltenIch verfolge einfach die news, ich weiß nur soviel, was aus den “vertraulichen” quellen rauskommt ;):http://www.hartware.de/news_39375.htmlhttp://www.hardtecs4u.com/?id=1151531389,21552,ht4u.phphttp://www.pcgameshardware.de/?article_id=473281http://www.teccentral.de/forum/showthread.php?t=53179

-

5. November 2006 um 17:11 Uhr #647345

steeve

Teilnehmer@KäsetoastSoweit ich weiß wird der G80 unified shader nicht haben, aber 32 pixel-shader und 16 kombinierte geometry- und vertex-shader. Der R600 dagegen wird insgesamt 64 unified shader haben und ob die als pixel- oder vertex-shader genutzt werden hängt vom spieleentwicklern ab, die leistung ist da.Der R600 ist so entwickelt, dass er bis zu 1GB vram verwalten kann und die architektur wird schon eine längere weile ausreichen, durch erweiterungen und neuen features wird der chip immer aktuell und schnell bleiben. Aktuelle architektur bei nvidia wird meiner meinung nach noch bei dieser generation eingesetzt, dann muss ihnen etwas einfallen … natürlich wird nicht die komplette architektur verändert, aber einige teile wie speicher-controller muss schon geändert werden. Man sieht heutzutage, wie die nvidia karten bei der kantenglättung einbrechen.Ich habe so meine vermutungen, aber abwarten und :kaffee:

-

5. November 2006 um 18:11 Uhr #647516

-666-

Teilnehmersteeve;182326 said:

-666- said:

ich finde es nur bescheuert das alle nasenlänge was neues kommt

kaum ist was neues rasugekommen sind schon Informationen zum nachfolger draußen ätzend sowas👿

Niemand wird zum glück gezwungen es zu kaufen … 😉

Ich bleibe bei meiner X1800XT bis reichlich spiele auf dem markt kommen [dauert bestimmt ein jahr] und bis stromverbrauch gesunken wird [wird wahrscheinlich mit dem R600 geschen, aber spiele fehlen dann].

da geb ich dir Recht sicherlich keiner wird gezwungen zu kaufen am besten mal abwarten was Ati und mit dem R600 bescheren wird

-

5. November 2006 um 18:11 Uhr #647514

steeve

Teilnehmer-666- said:

ich finde es nur bescheuert das alle nasenlänge was neues kommtkaum ist was neues rasugekommen sind schon Informationen zum nachfolger draußen ätzend sowas:evil:Niemand wird zum glück gezwungen es zu kaufen … ;)Ich bleibe bei meiner X1800XT bis reichlich spiele auf dem markt kommen [dauert bestimmt ein jahr] und bis stromverbrauch gesunken wird [wird wahrscheinlich mit dem R600 geschen, aber spiele fehlen dann].

-

5. November 2006 um 18:11 Uhr #647527

vamp

TeilnehmerDie 8800 haben ganz sicher Unified Shader und zwar hat GTS 96 davon, GTX 128.

Die ganzen Links übrigens sind von 06/05.2006. Vertrauten Quellen 😀

Deine Angaben sind doch reine Vermutungen. Es ist überhaupt nichts über die neue ATIs GK bekannt.

65µm, 512Bit, 1GB Vram und 50W Stromverbrauch :—)

-

5. November 2006 um 18:11 Uhr #647511

-666-

Teilnehmerich finde es nur bescheuert das alle nasenlänge was neues kommt

kaum ist was neues rasugekommen sind schon Informationen zum nachfolger draußen ätzend sowas👿

-

5. November 2006 um 19:11 Uhr #647533

steeve

Teilnehmervamp said:

Die 8800 haben ganz sicher Unified Shader und zwar hat GTS 96 davon, GTX 128.Die ganzen Links übrigens sind von 06/05.2006. Vertrauten Quellen 😀 Deine Angaben sind doch reine Vermutungen. Es ist überhaupt nichts über die neue ATIs GK bekannt.65µm, 512Bit, 1GB Vram und 50W Stromverbrauch :—)Das ist jetzt die frage. Ich weiß, dass die 8800er angeblich unified shader haben [habe noch im ersten post die daten gepostet], aber bis vor kurzer zeit hat nvidia gesagt, dass die für jetztige generation das nicht geplant haben. Ob man in kurzer zeit das ganz schnell in die architektur aufnehmen kann weiß ich nicht, im test von dailytech wurden die shaader gar nicht erwähnt.

Käsetoast said:

Das ist eben jetzt die große Frage:Von NVIDIA kam selbst vor nicht allzu langer Zeit immer wieder das Statement, dass man noch keine echten Unififed Shader anbieten wird, sondern die DX10 Anforderungen lediglich durch Hinzufügen von Geometry Shader-Einheiten erfüllt. In den ganzen Foren kommt seit kurzem aber eben das ganze “Olé, olé – 128 Unified Shader Einheiten!”. Ob das aber wirklich so gemeint war, oder ob insgesamt einfach nur 128 Einheiten realisiert wurden, wird nirgendwo erwähnt. Wär’ schon schade wenn NVIDIA’s Marketingabteilung 2/3 Monate vor dem Release nicht weiß was da entwickelt wird… 😀Mir ist die ganze situation auch bisschen stinkig … deswegen existieren die karten für mich immernoch nicht, bis man die im handel nicht findet und ERST WENN diese exemplare getestet werden.

vamp said:

Ich persönlich würde lieber ATI vorziehen, wegen des Bildquallitäts. Man, aber das sind doch noch mindestens 4 Monate. Und vielleicht in noch 4 Monaten bringt Nvidia eine neuere Serie von G80. Wenn dann die neue Serie von Nvidia endlich da ist, warten wieder ein paar Monate bis ATIs Gegenstück zum Vergleich da ist. So wird man sich nie was kaufen 🙄Die ATIs karten sollen schon im janur verfügbar sein … in vier monaten wäre bisschen ungünstig, da neutrale hardcore-gamer sofort zu irgendeiner karte zugreifen, die schon draußen ist.Wie war das mit den 7800er und X1800er, es waren zwei monate vergangen bis ATI mit ihren karten auf dem markt kam, oder ?

-

5. November 2006 um 19:11 Uhr #647529

vamp

TeilnehmerIch persönlich würde lieber ATI vorziehen, wegen des Bildquallitäts. Man, aber das sind doch noch mindestens 4 Monate. Und vielleicht in noch 4 Monaten bringt Nvidia eine neuere Serie von G80. Wenn dann die neue Serie von Nvidia endlich da ist, warten wieder ein paar Monate bis ATIs Gegenstück zum Vergleich da ist. So wird man sich nie was kaufen 🙄

-

5. November 2006 um 19:11 Uhr #647528

Käsetoast

Teilnehmervamp said:

Die 8800 haben ganz sicher Unified Shader und zwar hat GTS 96 davon, GTX 128.Das ist eben jetzt die große Frage:

Von NVIDIA kam selbst vor nicht allzu langer Zeit immer wieder das Statement, dass man noch keine echten Unififed Shader anbieten wird, sondern die DX10 Anforderungen lediglich durch Hinzufügen von Geometry Shader-Einheiten erfüllt. In den ganzen Foren kommt seit kurzem aber eben das ganze “Olé, olé – 128 Unified Shader Einheiten!”. Ob das aber wirklich so gemeint war, oder ob insgesamt einfach nur 128 Einheiten realisiert wurden, wird nirgendwo erwähnt. Wär’ schon schade wenn NVIDIA’s Marketingabteilung 2/3 Monate vor dem Release nicht weiß was da entwickelt wird… 😀vamp said:

Deine Angaben sind doch reine Vermutungen. Es ist überhaupt nichts über die neue ATIs GK bekannt.Naja – es gab da noch diesen angeblichen “Test” wo dann irgendwie rauskam, dass der G80 nett wäre, aber die neuen ATIs wären einfach nur Monster. Fand’ das aber nicht sehr glaubwürdig und muss auch nochmal rauskramen, woher das ursprünglich stammte…

Mahlzeit

Käsetoast -

7. November 2006 um 15:11 Uhr #647834

vamp

TeilnehmerInzwischen ist etwas mehr über die 8800GTX bekannt…

AF x16 Filterung Vergleich zwischen- 7900GTX, 1950XTX und 8800GTX

7900GTX

**************

1950XTX

**************

8800GTX

Scheint also sogar besser zu sein als bei ATI.

Bei der anisotropen Filterung sind 2 Dinge wichtig:

1. Winkel(un)abhängigkeit

Bei dem Testbild der 7900 GTX fällt diese sternförmige Anordnung auf. Dieses beschreibt die Winkelabhängigkeit bei der Filterung. Dieser “Stern” bewegt sich bei einer Drehung halt mit und man merkt, wenn man genau hinschaut, dass einige Bereiche halt anders gefiltert werden.2. Übergänge

Je “diffuser” die einzelnen Farben ineinander übergehen, desto weniger “fällt” die Filterung auf. Je härter die Übergänge, desto ausgeprägter das banding.

Wenn man beispielsweise CS mit einer kleinen Filterstufe zockt und man läuft, dann sieht man ein banding auf dem Boden, welches man vor sich “herschiebt”. Dieses banding ist ein Zeichen für eine suboptimale Filterung.~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~

Hier sind Haufen Bilder und Benchmarks mit der 8800GTX :d:

http://www.xtremesystems.org/forums/showthread.php?t=121980

Verbrauchen tut die GTX nicht wirklich viel, aber schon im nichtübertakteten Zustand wird sie bis zu 90°C heiss :-k

ps: der hat auch bei 3D06 die 14K Marke geknackt 😎

-

7. November 2006 um 21:11 Uhr #647915

-666-

Teilnehmer:biggrin: sauber die Karte im SLI verbund rockt die ja mal richtigund hier mal der Link einer 8800GTX mit Wakühler drauf http://www.awardfabrik.de/forum/showthread.php?p=11337#post11337

-

8. November 2006 um 15:11 Uhr #647999

vamp

TeilnehmerUnd erster Review 🙂

http://www.awardfabrik.de/index.php?p=reviewpages&id=68&seite=1

-

8. November 2006 um 16:11 Uhr #648010

-666-

Teilnehmersuper Werte hat der Kühler über 30c unterschied :respekt:

mal sehen ob ich für meine G80 einen ergattern kann -

8. November 2006 um 19:11 Uhr #648037

vamp

TeilnehmerNaja, das Teil wird sicher nicht billig und deshalb wenn schon dann lieber komplett aus Kupfer

-

8. November 2006 um 20:11 Uhr #648042

-666-

Teilnehmermuss man sehen was die final Version dann kann von dem Kühler

😈 -

8. November 2006 um 21:11 Uhr #648081

Käsetoast

TeilnehmerWundert mich, dass DAS HIER (www.computerbase.de) noch nicht verlinkt wurde. NVIDIAs Marketingabteilung zum Trotz wurden dann doch Unified Shader realisiert…:roll:

Mahlzeit

Käsetoast -

8. November 2006 um 21:11 Uhr #648087

vamp

TeilnehmerHab den Test auf CB jetzt komplett durch. Tja, den einzigsten Vorteil (Bildqualli) hat ATI somit verloren. 😀

Und bei der Leistung von 8800GTX wird ATI aber schwer haben ihre Karte (R600) noch leistungsfähiger hin zu bekommen 😎 -

9. November 2006 um 22:11 Uhr #648249

-666-

Teilnehmerich habe heute gehört das einige Karten wohl wieder an den Hersteller retour gegangen sind unter anderem MSI , Evga soll angeblich das problem nicht haben

erfahre das morgenfrüh weill dann der Händler meines vertrauens die Evga karten hat -

22. November 2006 um 18:11 Uhr #650434

Käsetoast

TeilnehmerSoweit ich weiß ist ein Multithreaden im GPU Bereich jedoch ein Klacks im Gegensatz zur CPU-Optimierung. Da werden schon optimierte Treiber alleine einen riesen Sprung bringen, da eine GPU im Prinzip jetzt schon wirklich massig viele Sachen parallel laufen hat. Von daher sehe ich hier recht schnell recht deutliche Ergebnisse. Die mehreren Kerne lassen mich jedoch zumindest auf einen geringen Stromverbrauch im Idle hoffen. ATI hatte sich zwar selber mit der X1x00er Serie und dem R600 bemängelt und Besserung bei der nächsten Generation gelobt, doch was daraus wird muss sich noch zeigen…

Mahlzeit

Käsetoast -

22. November 2006 um 18:11 Uhr #650431

steeve

TeilnehmerEs gibt einige infos [quelle: theinquirer.net] schon zu R700:Es wird nicht mehr starke GPUs geben. Es wird nur eine GPU geben und low-, medium- und high-end-klasse werden sich “nur” in der anzahl der kerne unterscheiden. So haben low-, medium- und high-end-klasse, 1, 4 bzw 16 kleine kerne.Außerdem sagte ATI [AMD], dass sie für die übernächste [R700] generation vollkommen neue architektur entwickeln werden. Man kann hoffen, dass diese architektur sparsamer mir strom umgeht.Nvidia äußerte sich, dass sie bei G90 das gleiche machen werden.Ist echt gute idee, aber die spieleentwickler werden bisschen mehr zeit brauchen, um ein spiel optimal für mehrere cpu- und gpu-kerne zu entwickeln.Naja, mal sehen wie sich die sache entwickelt :kaffee:

-

22. November 2006 um 18:11 Uhr #650439

steeve

TeilnehmerKäsetoast said:

Soweit ich weiß ist ein Multithreaden im GPU Bereich jedoch ein Klacks im Gegensatz zur CPU-Optimierung. Da werden schon optimierte Treiber alleine einen riesen Sprung bringen, da eine GPU im Prinzip jetzt schon wirklich massig viele Sachen parallel laufen hat.Bei den grakas wird das nicht so problematisch, da die engines schon für pixel- und vertex-recheneinheiten gebaut sind. Ich meinte aber, dass die spieleentwickler sich schon bisschen umstellen werden müssen. Und im leerlauf kann man nur ein kern nutzen. Bei volllast muss man einfach abwarten, um zu sehen wie es mit dem stromverbrauch aussieht. Auf jeden fall wird man schnell ergebnisse sehen…

-

25. November 2006 um 11:11 Uhr #650822

steeve

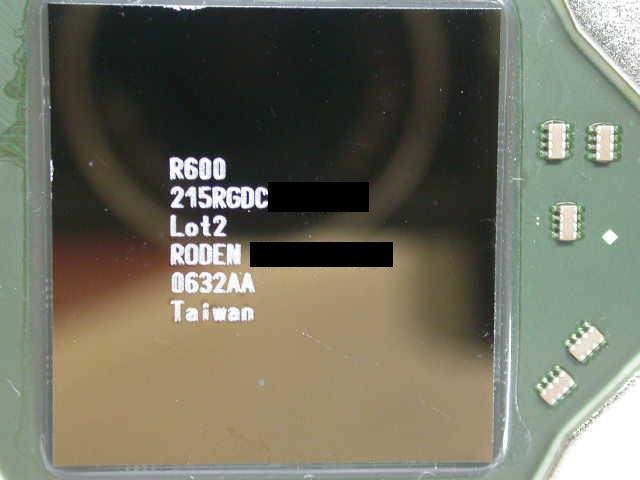

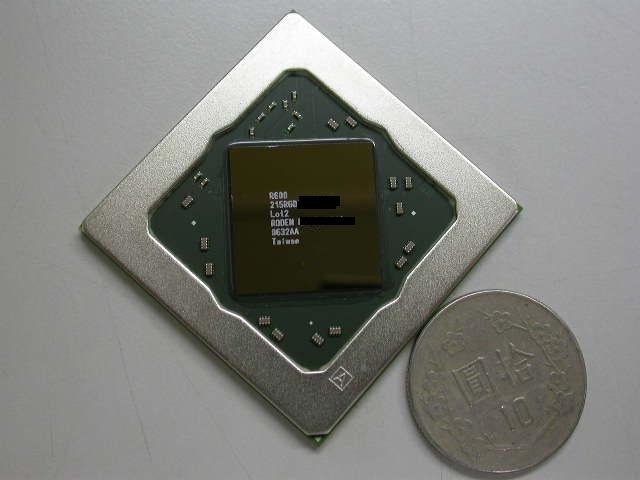

TeilnehmerMittlerweile gibt es die erste bilder von ATIs R600 [Quelle:computerbase.de]:R600 ist 420mm² groß und in 80nm gefertigt, zum vergleich ist der G80 484mm² groß und in 90nm gefertigt. Man könnte daraus schließen, dass der R600 weniger strom verbrauchen wird.Kommende ATI karten werden, laut gerüchten, mit 512MB und 1GB speicher ausgesttatet. Sie werden, auch laut gerüchten, im januar für die masse verfügbar.

[SIZE=”1″][Bildquelle: computerbase.de][/SIZE]Und hier ein vergleich zum R580:[SIZE=”1″][Bildquelle: vga.zol.com.cn][/SIZE]

-

15. Dezember 2006 um 20:12 Uhr #654684

klafert

Teilnehmerati nutzt unified shader- und Nvidia hat bis zur veröffentlichung gesagt sie wollen dies nicht tun

der r700 wird eine multigpu geschichte aber erst wird torrenza verwirklicht

was der r600 bringen wird kann ich sagen ih weiß nur das laut pcgh noch probleme mit dem hohen stromverbrauch bestanden als g80 rauskam

nvidia hat gut gehandelt und den g80 in den weihnachtshandel gebracht

allerdings will ich die gesichter der beschenkten sehen wenn ati im januer nvidia ein weiteres mal (nach r300, r400 und r500) kalt macht^^ und zwar nicht nur qualitativ sondern auch leistungsmäßig^^

-

15. Dezember 2006 um 22:12 Uhr #654709

vamp

Teilnehmerklafert;191137 said:

ati nutzt unified shader- und Nvidia hat bis zur veröffentlichung gesagt sie wollen dies nicht tunder r700 wird eine multigpu geschichte aber erst wird torrenza verwirklicht

was der r600 bringen wird kann ich sagen ih weiß nur das laut pcgh noch probleme mit dem hohen stromverbrauch bestanden als g80 rauskam

nvidia hat gut gehandelt und den g80 in den weihnachtshandel gebracht

allerdings will ich die gesichter der beschenkten sehen wenn ati im januer nvidia ein weiteres mal (nach r300, r400 und r500) kalt macht^^ und zwar nicht nur qualitativ sondern auch leistungsmäßig^^

Träum weiter 😆

Die hat Recht, die hat ne Ahnung \D/ 😀

-

16. Dezember 2006 um 14:12 Uhr #654808

klafert

Teilnehmereinfach die ersten benchs abwarten und dann könnt ihr träumen 😛

-

23. Dezember 2006 um 14:12 Uhr #655733

steeve

TeilnehmerDas hier [computerbase.de] ist interessant für die leute, die vorhaben sich eine DX10-karte zu holen.Kurz gesagt, was in den news steht, erste DX10-titel kommen nicht vor sommer 2007.Bis dahin sind dann auch die karten der konkurrenz verfügbar … dann gehts wieder ab mit dem grakakrieg. ^^

-

23. Dezember 2006 um 16:12 Uhr #655941

toor

Teilnehmersteeve said:

Bis dahin sind dann auch die karten der konkurrenz verfügbar … dann gehts wieder ab mit dem grakakrieg. ^^Und bis dahin sind auch die aktuellen G80-GPUs wieder “altes Eisen” dass “niemand” mehr interessiert, da nur noch “Mittelklasseware” 😡 Naja, immerhin belebt Konkurrenz das Geschaeft :DIch find’s auch einfach laecherlich wie viel Bedeutung manche Leute “ueberaktueller” Hardware zumessen, obwohl die Software dafuer noch gar nicht verfuegbar ist 😆 Aber ich schweife ab…

-

26. Dezember 2006 um 16:12 Uhr #656355

steeve

Teilnehmervamp said:

Wenn interessiert das schon ob es Anwendungen gibt die aus den Karten wirklich alles rausholen?Bewusste käufer interessiert das schon… Oder brauchst Du vielleicht ein auto mit 500 PS?

vamp said:

Kauf dir eine Mittelklasse-Karte und spiele 50€ Spiele mit niedrigen bis mittleren Details und du wirst natürlich alles sehen was das Spiel wirklich zu bieten hat 🙁Das ist auch das problem, das die gamer bei einem pc haben. Bei einer konsole ist das so, dass man sie sich holt und später das geld nur für die spiele ausgegeben wird. Und bei einem pc ist das so, dass man sich langsam mit jedem neuen spiel auch neue hardware holen muss. Und das schlimmste ist, dass die abwärtskompabilität sehr schlecht ist. Splinter Cell 4 braucht mindestens eine Shader Model 3-karte, damit das spiel überhaupt läuft. HL2 dagegen lief auch mit schwächsten Geforce4 karten.Versteht mich nicht falsch, ich sehe das spielen auf dem rechner nur als eine art unterhaltung und dafür bin ich nicht psychisch bereit viel auszugeben. Ich tanze doch nicht nach der musik der industrie. 😡 Ich kann ohne die industrie sehr wohl leben, die industrie kann aber ohne mich nicht leben!

vamp said:

Und komm nicht mit dem bescheuertem Argument ” Auf das gamplay kommts an, nicht auf die Grafik”, dann kannst du nähmlich Tetris weiterzockenDoch auf das gameplay kommt es an. Was habe ich von einem spiel mit bester grafik, wenn es einfach langweilig ist oder noch dazu der maßen verbuggt, dass man einfach frustiert vor dem rechner sitzt?Ganz nebenbei muss ich sagen, dass das spiel Mafia heute noch mehr spaß macht als die meisten nextgen-grafik spiele …Und die spiele wie z.b. Splinter Cell 4, Gothic 3 oder Oblivion boykottiere ich einfach. Wenn die entwickler nicht in der lage sind das spiel so zu entwickeln, damit es auch auf älteren pcs läuft, bin ich auch nicht in der lage sie durch meinen kauf zu unterstützten.Tut mir leid liebe industrie aber eurer konsumterror geht langsam auf die nerven.

vamp said:

… und spiele 50€ Spiele …Das ist auch das traurige an der geschichte. Spieleentwickler bauen werbungen ein und verdienen damit paar millionen noch dazu, aber die spiele werden nicht günstiger. Ganz im gegenteil, die werden immer langweiliger und sind immer öfter so verbuggt, dass man erst auf einen patch warten muss, um es spielen zu können.

-

26. Dezember 2006 um 16:12 Uhr #656352

vamp

TeilnehmerPhilipp;192704 said:

steeve said:

Bis dahin sind dann auch die karten der konkurrenz verfügbar … dann gehts wieder ab mit dem grakakrieg. ^^Und bis dahin sind auch die aktuellen G80-GPUs wieder “altes Eisen” dass “niemand” mehr interessiert, da nur noch “Mittelklasseware” 😡 Naja, immerhin belebt Konkurrenz das Geschaeft 😀

Ich find’s auch einfach laecherlich wie viel Bedeutung manche Leute “ueberaktueller” Hardware zumessen, obwohl die Software dafuer noch gar nicht verfuegbar ist 😆 Aber ich schweife ab…

Wenn interessiert das schon ob es Anwendungen gibt die aus den Karten wirklich alles rausholen ? Ist die etwa nicht schnell genug ?

Wenn du nicht genug Kohle für eine neue schnellste Karte hast ist es dein Problem, dadurch werden die Karten nicht langsammer oder schlechter.

Kauf dir eine Mittelklasse-Karte und spiele 50€ Spiele mit niedrigen bis mittleren Details und du wirst natürlich alles sehen was das Spiel wirklich zu bieten hat 🙁

Und komm nicht mit dem bescheuertem Argument ” Auf das gamplay kommts an, nicht auf die Grafik”, dann kannst du nähmlich Tetris weiterzocken -

26. Dezember 2006 um 20:12 Uhr #656410

vamp

TeilnehmerFar Cry und später Crysis sind auch 0815 Shooter, die aber sehr beliebt sind. Und weshalb ?

Call of Duty Reihe, FEAR, DOOM3 und Halfe Life2 sind auch bekannt nur durch ihre Grafik geworden. An sich bieten solche Spiele auch nichts besonderes, nur ballern, ballern, ballern.Ich habe vor 1.5 Jahren fast 300€ für 6600GT ausgegeben mit der ich weder damals noch Heute Spiele mit höchsten Details spielen konnte und kann. Dann gebe ich doch lieber noch mehr aus und spiele zumindest jetzt alle Spiele in höchstes Auflösung und maximalen Details oder aber man steigt gleich auf die Konsolen um.

-

26. Dezember 2006 um 22:12 Uhr #656427

klafert

Teilnehmernaja call of duty far cry fear und hl2 sind action shooter die aber klar auch “hintergrund” und nen roten faden haben und die hab ich nicht wegen der angeblich tollen grafik (die ich in allen fällen eher normal aber nicht als ausnahme sehe) desweiteren ist hl2 eher die engine und css bzw dod-s was dieses so berühmt macht

die dx10 architektur sorgt nebenbei auch dafür das dx9 spiele die graka kaum auslasten weil dx10 deutlich aufwendiger ist

wenn man sich nen rechner kauft dann muss man in kauf nehmen das dieser in einem monat alt ist

man kann nicht immer auf die nächste neuerung warten dann bekommt man nichts.(ich werd nicht auf ddr3 warten)ein high end rechner reicht ca 3 jahre bevor er in den low end sektor fällt kann man durch verbesserungen rauszögern nur seh ich net ein ne neue grafik zu kaufen und dann den cpu als bremse zu haben und dann hol ich mir ne cpu und hab ne alte graka

da hol ich mir lieber alle 3 jahre komplettes system spiel 1 jahr high end und ab dann halt eben mittelklasse das ist noch voll ausreichend für meine aspekte

-

26. Dezember 2006 um 23:12 Uhr #656434

steeve

Teilnehmervamp said:

Far Cry und später Crysis sind auch 0815 Shooter, die aber sehr beliebt sind. Und weshalb?Call of Duty Reihe, FEAR, DOOM3 und Halfe Life2 sind auch bekannt nur durch ihre Grafik geworden.: / Oben genannte spiele sind nicht bekannt geworden, weil sie so tolle grafik hatten. FEAR hat einzigartige atmosphere. HL2 ist, wie alle schon wissen sollten, durch den ersten teil, der ein geniales gameplay für damalige zeiten hatte, bekannt geworden. Far Cry hatte auch ein besonderes feeling, viele sahen in Far Cry eine art HL. Die grafik war bei den spielen echt nur etwas sekundäres, halt um die aufmerksamkeit der masse bisschen zu lenken.Also ich bitte dich, rede den leuten nicht irgendein qutsch ein.

vamp said:

Ich habe vor 1.5 Jahren fast 300€ für 6600GT ausgegeben mit der ich weder damals noch Heute Spiele mit höchsten Details spielen konnte und kann.Da hast Du aber bisschen zu viel bezahlt, da der einführungspreis für die 6600GT knapp 200€ war, 300€ sind echt unrealistisch.Und mit der karte konnte man sehr wohl viele spiele mit höchster quali spielen. Far Cry und HL2 konnte man ohne probs mit 4xAA und 8xAF bei 1280×1024 spielen, wenn de restliche hardware stimmte. Und alle spiele, die bis dahin rauskamen, konnte man auch bei höchster quali spielen.Und heute kann ich sogar mit meiner X1800XT manche spiele nicht mit hoher quali spielen. Ob das daran liegt, dass die hardware alt ist, musst Du selbst herausfinden … :-k

vamp said:

Dann gebe ich doch lieber noch mehr aus und spiele zumindest jetzt alle Spiele in höchstes Auflösung und maximalen Details oder aber man steigt gleich auf die Konsolen um.200€-300€ reichen für eine karte absolut aus. Nehmen wir als beispiel die X1950Pro -> die kann man schon für ~200€ mit 512MB VRAM kaufen. Sag bitte nicht, dass die nicht ausreicht um heutige spiele bei höchster quali zu spielen. Aber erwähne jetzt bitte nicht Gothic3, da das spiel echt miese entwickelt wurde.

klafert said:

die dx10 architektur sorgt nebenbei auch dafür das dx9 spiele die graka kaum auslasten weil dx10 deutlich aufwendiger istHmm, hast Du was vielleicht verwechselt? :-k Durch DX10 wird die cpu deutlich entlastet. Bei DX10 spielen wird es eigentlich egal sein, ob du einen X2 3600+ oder X2 6000+ hast.

-

27. Dezember 2006 um 0:12 Uhr #656440

vamp

Teilnehmersteeve;193323 said:

Oben genannte spiele sind nicht bekannt geworden, weil sie so tolle grafik hatten. FEAR hat einzigartige atmosphere. HL2 ist, wie alle schon wissen sollten, durch den ersten teil, der ein geniales gameplay für damalige zeiten hatte, bekannt geworden. Far Cry hatte auch ein besonderes feeling, viele sahen in Far Cry eine art HL. Die grafik war bei den spielen echt nur etwas sekundäres, halt um die aufmerksamkeit der masse bisschen zu lenken.

Also ich bitte dich, rede den leuten nicht irgendein qutsch ein.Man, was für ein Gameplay bieten den jetzt die DooM und HL, UT oder FEAR ?

Ein Ballerspiel mit toller Grafik !

Wo du da ein höheres Sinn gefunden hast weisst sicher nur dusteeve;193323 said:

Da hast Du aber bisschen zu viel bezahlt, da der einführungspreis für die 6600GT knapp 200€ war, 300€ sind echt unrealistisch.

Und mit der karte konnte man sehr wohl viele spiele mit höchster quali spielen. Far Cry und HL2 konnte man ohne probs mit 4xAA und 8xAF bei 1280×1024 spielen, wenn de restliche hardware stimmte. Und alle spiele, die bis dahin rauskamen, konnte man auch bei höchster quali spielen.

Und heute kann ich sogar mit meiner X1800XT manche spiele nicht mit hoher quali spielen. Ob das daran liegt, dass die hardware alt ist, musst Du selbst herausfinden … :-k .Ist überhaupt nicht war ! 240€ war die billigste Variante von Sparkle 😉

steeve;193323 said:

200€-300€ reichen für eine karte absolut aus. Nehmen wir als beispiel die X1950Pro -> die kann man schon für ~200€ mit 512MB VRAM kaufen. Sag bitte nicht, dass die nicht ausreicht um heutige spiele bei höchster quali zu spielen. Aber erwähne jetzt bitte nicht Gothic3, da das spiel echt miese entwickelt wurde.Fear, CoD2, HL2, DooM3 usw. sind doch schon 1 Jahr alt und nicht aktuel oder welche Spiele hast du gemeint ?

-

27. Dezember 2006 um 16:12 Uhr #656497

steeve

Teilnehmervamp said:

Man, was für ein Gameplay bieten den jetzt die DooM und HL, UT oder FEAR ?Ein Ballerspiel mit toller Grafik !Wo du da ein höheres Sinn gefunden hast weisst sicher nur du.Laut deiner aussagen gibt es jetzt nur ballerspiele, rennspiele die ehe alle gleich sind und irgendwelche spiele wo man ein dorf oder charakter aufbaut. : / Oder Du kannst mich nicht ganz verstehen. Alle die spiele wurden bekannt, weil die sehr qualitativ waren. Sie waren nicht qualitativ und bei den spielern beliebt, nur weil sie tolle grafik hatten. Grafik war nur nebensächlich, sorgte nur für bessere präsenz, aber die grafik alleine war nicht für den erfolg dieser spiele verantwortlich. Jeder dieser spiele HL, UT, Doom, Wolfenstein, Mafia … hatte besondere szenarien und atmosphere. Du kannst nicht einem erzählen die grafik sei alles was ein spiel erfolgreich macht. Dass es aber zeitschriften oder manche web-seiten gibt, die eine note extra draufpacken, wenn die grafik gut aussieht kann ich nichts für. Das schlimme ist, die entwickler geben sich dann beim nächsten spiel viel mehr mühe für die grafik, und die qualität im gesamten spiel läßt nach. Aber soweit es spieler gibt, die denken die grafik sei alles in einem spiel, läuft doch alles gut…

vamp said:

Ist überhaupt nicht war ! 240€ war die billigste Variante von Sparkle 😉Ich hab damals meine Leadtek 180€ bezahlt. Hab aber 3-4 wochen gewartet, bis sie überall verfügbar war.

vamp said:

Fear, CoD2, HL2, DooM3 usw. sind doch schon 1 Jahr alt und nicht aktuel oder welche Spiele hast du gemeint ?Auch heutige spiele wie z.b. SC4 packt die X1950Pro locker. Auch sonstige spiele würden ohne probleme flüssig laufen, aber dann sollte auch die restliche hardware stimmte: 2GB speicher und ne schnelle cpu.Die X1950Pro könnte nur bei Gothic3 schwierigkeiten bekommen, aber wie man das schon kennt, ist das spiel sehr schlecht entwickelt. Das bietet zwar tolle grafik, aber zu welcher leistung … [Gothic3 gibt sogar ein fehler aus, dass es wenig speicher gibt, obwohl man im pc 2GB hat]

-

27. Dezember 2006 um 16:12 Uhr #656505

steeve

Teilnehmervamp said:

Netter Versuch 😉 AthlonXP und 9250 ende 2006, dass sagt doch was anderes aus

Ja ok, nicht alle nutzen ein pc um spiele zu spielen oder er mag ganz andere spiele wie z.b. CrazyMachines, Ballance … OK leute, lasst uns jetzt bitte diese diskussion zu ende bringen, damit deiser thread bleibt wofür er gedacht war -> thread für die neuste technik im bereich grafikkarten und was dazu so alles passt. 🙂.

-

27. Dezember 2006 um 16:12 Uhr #656504

-

27. Dezember 2006 um 16:12 Uhr #656503

-

27. Dezember 2006 um 21:12 Uhr #656577

klafert

Teilnehmerokay on topic

wie lang dauert es bis es waküaufsätze für die dinger gibt?

-

29. Dezember 2006 um 14:12 Uhr #656848

vamp

TeilnehmerGibts doch schon.

Die Dinger sind ziemlich aufwändig und die Hersteller kommen der Anfrage nicht nach.

Hier scheints schon vorrätig zu sein…

http://www.aquatuning.de/product_info.php/info/p1857_Innovatek-Cool-Matic-G80-GTX—GPU-RAM-SPG.html

Doch meine Bestellung ist immer noch offen : /

-

29. Dezember 2006 um 20:12 Uhr #656910

klafert

Teilnehmerhmm ich meinte wie lang es dauert bis es die für den r600 gibt

also allgemein wieviel zeit vom graka release zum kühler vergeht ca

-

1. Januar 2007 um 16:01 Uhr #657464

steeve

TeilnehmerUnd erster test [planet3dnow.de] zu der neusten grafikkarte von ATI mit dem R600-chip ist mittlerweile auch raus.Hier paar technische spezifikationen der karte:

– 64 4-Way SIMD Unified Shaders, 128 Shader Operations/Cycle- 32 TMUs, 16 ROPs- 512 bit Memory Controller, full 32 bit per chip connection //damit kann man auch 2GB VRAM steuern- GDDR3 at 900 MHz clock speed (January)- GDDR4 at 1.1 GHz clock speed (March, revised edition)- Total bandwidth 115 GB/s on GDDR3 // 86 GB/s sind es bei G80 bzw 8800GTX- Total bandwidth 140 GB/s on GDDR4– Consumer memory support 1024 MB– DX10 full compatibility with draft DX10.1 vendor-specific cap removal (unified programming)- 32FP internal processing- Hardware support for GPU clustering (any 2^n number, not limited to Dual or Quad-GPU)- Hardware DVI-HDCP support (High-Bandwidth Digital Content Protection)- Hardware Quad-DVI output support (Limited to workstation editions)- 230W

planet3dnow.de said:

In den veröffentlichten Benchmarks liegt der R600 zwischen 8% und 42% vor nVidias aktuellem Topmodell, der GeForce 8800GTX.[SIZE=”5″]The Full ATI R600 Test[/SIZE][SIZE=”1″][Quelle: level505.com][/SIZE]Hier mal paar benchmarks als vorgeschmack:

[SIZE=”1″][Bildquelle: level505.com][/SIZE]Die karten sollen am 22. januar in den handel kommen.

-

1. Januar 2007 um 18:01 Uhr #657519

steeve

TeilnehmerNa, was sagt ihr zu den benchmarksergebnissen? Keine heftige diskussion?In nur drei wochen kommen die monster in den handel.

-

1. Januar 2007 um 19:01 Uhr #657532

Spicy_Ice

TeilnehmerHallo

Ne 1950XTX CF schneller wie ne R600 in Fear?WAs geht und eine 8800 so langsam?Hui

Benchmark hin oder her.ATI bleibt immer mein Favorit und mit einigen Fehlkäufen von Nvidia bin nur noch ATI und Intelfan ^^Hauptsache mein Lieblingspiel läuft unds rückelt ned,da is mir jeder Benchmark egal.

ATI TOP :-({|=

Gruß SPicy

-

1. Januar 2007 um 20:01 Uhr #657540

steeve

TeilnehmerBitte jetzt keine fan-boy-diskussion anfangen.Jep, auch auf die andere tests von anderen seiten sollte man abwarten. Ich hab jetzt nur diesen test gepostet, damit man sehen kann wie sich die karte auf dieser seite schlägt.Da sieht die karte echt gut aus, vor allem die speicherbandbreite:X2900XT – 115 GB/s mit GDDR3 und 140 GB/s mit GDDR48800GTX – 86 GB/s mit GDDR3

-

1. Januar 2007 um 20:01 Uhr #657549

h4rdc0r3

TeilnehmerIch sag dazu mal lieber nix. Da warte ich lieber bis die Karte raus ist, die Treiber halbwegs optimiert sind und sehe mir dann Benchmarks verschiedenster Sites an. Und nur dann bilde ich mir erst meine Meinung, alles andere ist meist nur Spekulation.

Nur soviel sei gesagt, wenn der R600 nicht schneller wäre, wäre es dann überhaupt sinnvoll ihn rauszubringen wenn es bereits etwas besseres auf dem Markt gäbe?

Dann stellt sich noch die Frage des Preises und der Verfügbarkeit.

-

1. Januar 2007 um 20:01 Uhr #657541

Spicy_Ice

TeilnehmerHallo klafert

DOch hatte ich ^^.bis vor 3 Monaten.Hat ein netter User bei egay abgekauft.Habe sogar mehr bekommen,als ich damals dafür gezahlt habe ^^

Und es war ein P4 3,2 HT violaAMD hatte ich auch schon und Nvidia zu oft,aber die hielten ei mir keinen Monat ^^.Dann hab ich se doch wieder gegen nen Intel und ne ATI getauscht

Gruß Spicy

-

1. Januar 2007 um 20:01 Uhr #657539

klafert

Teilnehmerspicy ice du bisn erfolgsfan 😛

wette du hattest keine p.4 preschrott kern^^

SOLLTEN die ergebnisse nicht aus der nase gezogen sein ist das mal richtig hammer geil^^

dann will ich sie haben verdammte ******* man^^

*freu und garnetmehrwartenkann*

selbes system 900 3d mark 06 punkte mehr geil

nur leider keine bilder…

-

1. Januar 2007 um 20:01 Uhr #657537

EvilMoe

TeilnehmerIch trau den Benches eh nicht. Bzw, erstmal gucken was andere so berichten und für Ergebnisse liefern.

-

1. Januar 2007 um 21:01 Uhr #657557

steeve

Teilnehmerh4rdc0r3 said:

Ich sag dazu mal lieber nix. Da warte ich lieber bis die Karte raus ist, die Treiber halbwegs optimiert sind und sehe mir dann Benchmarks verschiedenster Sites an. Und nur dann bilde ich mir erst meine Meinung, alles andere ist meist nur Spekulation.Ja ok, spekulation kann man es nicht wirklich nennen. Aber man sollte schon abwarten, um zu sehen was die andere seiten sagen.Was ich aber bis jetzt gehört habe ist, dass die spieleentwickler die karten zum testen bekommen haben und echt überrascht waren wie die karte abgeht. Die karte war einfach schneller.Wie schon gesagt, sollte man sich nur mal die speicherbandbreite angucken. Mit GDDR4, die bei den top modellen verbaut wird, erreicht man 140 GB/s das ist im verhältnis zu der 8800GTX mit 86 GB/s, fast eine verdoppelung. Was soll man dazu noch sagen, dafür braucht man keine benchmarks zu sehen, dass die karte power hat.

h4rdc0r3 said:

Nur soviel sei gesagt, wenn der R600 nicht schneller wäre, wäre es dann überhaupt sinnvoll ihn rauszubringen wenn es bereits etwas besseres auf dem Markt gäbe?Sag bitte nicht, dass Du eine antwort erwartest?Die kühlung wird aber echt aufwendig werden. 230W für eine graka ist echt heftig, aber wenn man sich die 8800GTX mit 200W anschaut, denkt mann, dass es doch nicht so viel ist. Ich werde mir auf jeden fall keine dieser karten holen, vielleicht die übernächste generation, wenn was am stromverbrauch getan wird. 200W+ sind mir einfach zu viel, da ist mir die spieleleistung egal.

-

1. Januar 2007 um 21:01 Uhr #657555

klafert

Teilnehmerna okay dann will ich mal nix gesagt haben *auch nur intel und ati hatte*

so

naja verwunderlich

tests ohne screenshots ( man könnte die herkunft der karte herausfinden)

keine fotos (will die kühlung wissen)

abwarten es werden soooooooooo viele gerüchte verbreitet das ist net mehr schön

und die stromaufnahme die so heiß diskutiert ist ist jawohl nicht so viel höher wie normal auch

leistung kostet halt en bissl was

bisher hatte es ati seit r3xx immer geschafft auf nvidia ne passende und bessere antwort zu finden

naja würde der r600 langsamer und die würden den net rausbringen dann gehen die pleite weil die kosten für die entwicklung so hoch sind

im zweifelsfall können se ja noch mal verschieben und ein paar 4 wege shader zutun..

-

1. Januar 2007 um 22:01 Uhr #657561

h4rdc0r3

TeilnehmerIch denke mir das so, das die Karte am Anfang teuer genug sein wird und spricht daher nur die Hardwarefetischisten an.Und wenn die Karte nicht schneller wäre, welcher von denen würde sie dann kaufen?Liege ich damit denn wirklich so weit daneben? Gab es denn in letzter Zeit einen Grafikchip der neu auf den Markt kam und langsamer war als der “Ältere”?Hab mich nie so intensiv damit beschäftigt, würde aber das dennoch mal so in den Raum stellen. Könnt mir gerne was anderes aufzeigen.

-

2. Januar 2007 um 11:01 Uhr #657606

klafert

Teilnehmerwenn die karte nicht so gut wär muss sie trotzdem verkauft werden dann halt billiger hmpf

-

2. Januar 2007 um 13:01 Uhr #657631

klafert

Teilnehmernaja ati hat schon testkarten an spielehersteller etc versendet

core 2 duo sind auch testmodelle vor verkaufstermin bei ebay erhältlich gewesen

-

2. Januar 2007 um 13:01 Uhr #657625

vamp

TeilnehmerUnd das ist kein fake ? Die Karte soll erst am 22 Januar zum Verkauf freigegeben sein, aber jetzt schon wird sie getestet ? Wird der Händler dafür nicht kastriert ?

Ich finde überhaupt nichts über ATI R600.8800GTS/GTX lassen sich prima takten, das war bei den ATIs 1950XTX mit GDDR4 nicht der Fall

edit: ausserdem wird weder was über die Architektur von GPU erwähnt noch über die Taktraten

-

2. Januar 2007 um 18:01 Uhr #653134

VJoe2max

TeilnehmerZum R600:Der Stromverbrauch macht die Karte in meinen Augen indiskutabel – und sei sie noch so schnell. Sowohl AMD als auch NVidia sollten langsam von ihrem Verlustleistungstrip runterkommen und sich darum kümmern die Chips kühler zu bekommen x( .Die Leistung der aktuellen Graka-Generation ist doch sowiso ihrer Zeit voraus. Die paar wenigen Spiele, die ein solches Monster erfordern sind oft schlecht programmiert oder noch nicht erschienen.Ausserdem ist DirectX 10 ist noch nicht mal auf dem Markt, weil sich Vista verzögert hat. Wer sich jetzt eien 8800er oder demnächst die R600 kauft wird meiner Ansicht nach in mehrerlei Hinsicht enttäuscht werden. Zum einen ist die Hardware schon wieder veraltet, wenn Vista sich einigermaßen verbreitet hat, zum anderen verbraucht er bis dahin soviel Strom, dass er mit den Kosten bald schon wieder eine neue Karte kaufen könnte. Für uns Wasserkühler kommt mit diesen Teilen zusätzlich noch der Aspekt hinzu, dass die Kühler immer teuerer werden und selbstbau zunehmend schwieriger wird. Ausserdem heizen die Dinger das Wasser unnötig auf :roll:.Ich warte auf jeden Fall die nächste Generation ab – vielleicht lernen nVidia und AMD ja doch noch dazu [-o< .

-

2. Januar 2007 um 18:01 Uhr #652832

steeve

TeilnehmerVJoe2max said:

Zum R600:

Der Stromverbrauch macht die Karte in meinen Augen indiskutabel – und sei sie noch so schnell.Das stimmt. Die cpus verbrauchen relativ wenig strom, wenn man jetzt die neue Intels quad-core cpus rausläßt, die sogar bisschen mehr strom verbrauchen als die alte Prescott cpus. Aber wenn man sich die karten jetzt anschaut: 8800GTX – 200W ; X2800XT – 230W, bleibt man echt ohne kommentar. Ich werde mir keine grakarte mehr holen, bis die grakahersteller nicht aufhören solche stromfresser herzustellen. Zwar stimmt das, dass die karte unglaubliche spieleleistung haben, aber 200W+ sind mir einfach zu viel. 100W dagegen ist für eine leistungkarte ala X1950XT – 8800GTS [160W] noch akzeptabel.

r00t said:

das war doch zu erwarten das der R600 schneller wird oder?Nachdem einige daten der karte geleakt wurden wusste man, dass die karte overkill leistung haben wird.

-

2. Januar 2007 um 18:01 Uhr #652864

r00t

Teilnehmerdas war doch zu erwarten das der R600 schneller wird oder?immerhin gibts den G80 jetzt doch schon etwas länger 😉

-

2. Januar 2007 um 22:01 Uhr #619773

klafert

Teilnehmernaja ich werd sie mir holn will net im halben jahr die dx10 spiele nicht nur auf bildern sehen…

-

2. Januar 2007 um 22:01 Uhr #617637

vamp

Teilnehmersteeve;194914 said:

…. 100W dagegen ist für eine leistungkarte ala X1950XT – 8800GTS [160W] noch akzeptabel….Wenn meckern dann auch richtig 🙂

Angesichts der Mehrleistung von 8800 GTX zu X19050XT, ist der Mehrverbrauch an Strom auch gerechtfertigt :tongue:

klafert;194991 said:

naja ich werd sie mir holn will net im halben jahr die dx10 spiele nicht nur auf bildern sehen…Die kannste auch in 6 Monaten holen wenn die Spiele da sind. Ich habe sie gekauft weil unsicher war ob für die z.B. 1800XT/1900XT mit HD Auflösung und allen Details eventuel zuviel wird

-

3. Januar 2007 um 10:01 Uhr #656513

drdope

Teilnehmero2-cool;195031 said:

Also Benchmark hin oder her…eins versteh ich nicht.Wer spielt heute eigentlich noch in 1600×1200 ??

Seitdem ich TFT s habe ist eigentlich fast immer 1280×1024 angesagt….alles was grösser ist taugt nicht zum Spielen da die 20+ Zoll TFT zu langsam zum Spielen sind.Auch auf nem 30′ TFT (2560×1600) läßt sich gut zocken, wenn man die, von den Marketingabteilungen angegebenen, unrealistisch niedrigen Reaktionszeiten der sogenanten “Gamer-TFTs” mal außen vorläßt….

Mal ne ganz einfache Rechnung:

Wenn ich nen TFT mit 60Hz ansteuere; hat das Gerät für den Aufbau eines Bildes 1000ms/60Bilder lang Zeit –> Das sind ~16,6ms pro Bild; alles was fixer wäre bringt eh nix…

😉 -

3. Januar 2007 um 10:01 Uhr #656732

o2-cool

TeilnehmerAlso Benchmark hin oder her…eins versteh ich nicht.Wer spielt heute eigentlich noch in 1600×1200 ??Seitdem ich TFT s habe ist eigentlich fast immer 1280×1024 angesagt….alles was grösser ist taugt nicht zum Spielen da die 20+ Zoll TFT zu langsam zum Spielen sind.Ich habe eine 8800er GTX und habe kein Spiel was bei maximaler Grafik unter 100 FPS läuft…also deutlich schneller als meine TFT überhaupt darstellen können.Braucht man da eine 8800er oder eine R600 ? Fürs ego ja…zum zogge (derzeit) eigentlich noch nicht.

-

3. Januar 2007 um 17:01 Uhr #578454

klafert

Teilnehmerich schaffe mir halt zuu vista einen neuen an

und zwar weil der alte echt alt wird

r300 und p4 3,0 sind langsam

und jetzt wo vista rauskommt passt es perfekt

dann nehm ich gleich den r600 und nen guten prozessor und hab wieder ne zeit ruhe bin nicht der typ für pc immer wieder nachrüsten

wenn ich jetzt nen x1950 holn würd hätt ich in nem halben jahr schon die ersten spiele bei denen ich viele effekte verpassen würd was nich passieren wird wenn ich den r600 hole

der stromverbrauch ist mir vollkommen egal

der leistungüberschuss wird in rauch aufgehen wenn die passenden spiele aufm markt kommen

dann stehen die die sich erst ne dx9 karte gekauft haben im regen und müssen sich was neues kaufen und die alten karten sind auch nicht mehr wertvoll weil der sprung zu groß ist…karte kommt ende januar aufm markt

mitte februar ist sie dann ausreichen verfügbar

und mitte märz werden se schon wieder billiger und dann hab ich meinen kauf geplant.. -

3. Januar 2007 um 17:01 Uhr #578419

drdope

Teilnehmerhusky;195133 said:

drdope;195035 said:

Mal ne ganz einfache Rechnung:

Wenn ich nen TFT mit 60Hz ansteuere; hat das Gerät für den Aufbau eines Bildes 1000ms/60Bilder lang Zeit –> Das sind ~16,6ms pro Bild; alles was fixer wäre bringt eh nix…

😉Der Monitor bekommt alle 16,6ms ein neues Signal für ein Bild. Das heißt ja noch lange nicht, dass er es in dieser Zeit auch darstellen kann, bzw. vom alten auf das neue Bild umstellt.

Da hab ich auch nie behauptet, wenn du dir mal durchließt, was ich geschrieben hab….

😉 -

3. Januar 2007 um 17:01 Uhr #578424

husky

Teilnehmerdrdope;195035 said:

o2-cool;195031 said:

Also Benchmark hin oder her…eins versteh ich nicht.Wer spielt heute eigentlich noch in 1600×1200 ??

Seitdem ich TFT s habe ist eigentlich fast immer 1280×1024 angesagt….alles was grösser ist taugt nicht zum Spielen da die 20+ Zoll TFT zu langsam zum Spielen sind.Auch auf nem 30′ TFT (2560×1600) läßt sich gut zocken, wenn man die, von den Marketingabteilungen angegebenen, unrealistisch niedrigen Reaktionszeiten der sogenanten “Gamer-TFTs” mal außen vorläßt….

Mal ne ganz einfache Rechnung:

Wenn ich nen TFT mit 60Hz ansteuere; hat das Gerät für den Aufbau eines Bildes 1000ms/60Bilder lang Zeit –> Das sind ~16,6ms pro Bild; alles was fixer wäre bringt eh nix…

😉Der Monitor bekommt alle 16,6ms ein neues Signal für ein Bild. Das heißt ja noch lange nicht, dass er es in dieser Zeit auch darstellen kann, bzw. vom alten auf das neue Bild umstellt.

-

3. Januar 2007 um 17:01 Uhr #578344

husky

TeilnehmerOk :+

Erst lesen, dann denken, dann posten – ich weiß;)

-

6. Januar 2007 um 3:01 Uhr #658208

vamp

TeilnehmerIch hab an meinem 24″ Eizo nichts auszusetzen und der hat nun mal 1920X1200.

Ich zocke gerade “Dark Messiah of Might and Magic” (finde das Game ist viel besser als Oblivion) und ich bin mir nicht sischer ob X19XX Serie es auch packt. -

13. Januar 2007 um 13:01 Uhr #659727

go4hl80ve

Teilnehmeralso mal ehrlich – 230W stromverbrauch ist einfach mal lächerlich hoch.

wozu das ganze??? nur wegen ein paar frames mehr, die man bei den aktuellen spielen vermutlich nichtmal merkt?

und bei den echten DX10 krachern wird die hardware dann vermutlich schon wieder zu langsam sein.

und aktuelle spiele werden nicht besser aussehen (eher ein wenig steriler, da man bei sehr hohen auflösungen langsam detailmängel erkennt)bin ich froh, dass ich mir ne 7900GS geholt hab. 50W stromverbrauch und aktuelle spiele laufen allesamt in 1680×1050 pixeln und hohen details.

(bei ein bisschen älteren gibts dann immer maximale details + AA + AF)

im prinzip könnte ich mir bei ebay auch noch eine preiswert(?) besorgen und dann mit SLI spielen. wäre zwar langsamer, aber auch viiieeel sparsamer als so nen R600.und wenn ich mir überlege, dass mein ziemlich aktueller pc (mal von der graka abgesehen; dabei kam die gerade neu raus, als ich die geholt hab) bei vollast insgesamt grade mal 180W ausm netz zieht, dann sind 230W – wie anfangs erwähnt, schlichtweg lächerlich hoch

-

13. Januar 2007 um 13:01 Uhr #659735

Spicy_Ice

TeilnehmerHallo

Was jammert ihr den bitte am Stromverbrauch?WOzu kauft man sich ein 600-800W Netzteil?

Nur so mal am Rande.Zahlt ihr euren Strom selber ,die hier nicht verdienen oder wer anderes?Mich juckt mein Stromverbrauch nicht,Habe noch nebenbei 13 Aqauarien die 24/7 die Woche laufen und die schlucken mehr wie mein PC und sind deutlich teuerer im Unterhalt wie der PC.Wen juckts da.Wenn euch euer Hobby zu teuer ist,dann müsst ihr euch einschränken oder es lassen.Jammer bringt nichts,wird an euerer Situation nichts ändern.Aber Neidisch auf andere sein das köpnnt ihr dann gerne.

Gruß SPicy

-

13. Januar 2007 um 13:01 Uhr #659730

r00t

Teilnehmerhardcoregamer freaks mit einem G80 Sli sys juckt der stromverbrauch glaub ich herzlich wenig!

-

13. Januar 2007 um 14:01 Uhr #659741

Patty

Teilnehmerspicy :xkomische einstellung hast du da, aber aja, deine sache. solangs spaßmacht…im gegensatz zu dir ist es mir auch nicht wayne wie hoch meine stromkosten sind. da meine eltern diese tragen komme ich zwar selber nicht direkt für mich auf, mein vater hatte mich aber vor einiger zeit schonmal angesrochen, als eine nachzahlung von 320€ ins haus geflogen kam.von daher versuche ich den energiehunger meines rechners etwas zu drücken. je nachdem wie die nächsten rechnungen aussehen werde ich mich wohl etwas an den kosten beteiligen müssen.

-

13. Januar 2007 um 14:01 Uhr #659739

husky

TeilnehmerMan kauft sich ein 600 – 800 Watt NT, wenn kleinere nicht ausreichen.Ich zahle meinen Strom nicht selber. Aber im Gegensatz zu anderen ist mir nicht egal, wie viel meine Eltern blechen müssen. Wenn ich schon den Strom umsonst bekomme, dann muss ich das ja nicht auf die Spitze treiben.Es kann auch ein Hobby sein, Hardware mit niedriegem Verbrauch zu verbauen. Ich hab am Stromsparen mindestens so viel Spaß wie du beim sinnlosen vergeuden. Geh nicht immer von dir aus – andere Leute haben andere Interessen und Vorlieben.Warum sollte man auf Leute neidisch sein, die den Strom im Unverstand raushauen 😡 Da fehlt wohl der Sinn in deiner Behauptung.230Watt Stromverbrauch sind einfach viel zu viel für die Grafik. Aber wenn sich keiner beschwert und es jeder – so wie du – einfach so schluckt, warum sollte die Industrie was ändern. Ein Kunde, der alles kauft, ohne Fragen zu stellen und zu denken ist der Wirtschaft ja am liebsten.

-

13. Januar 2007 um 15:01 Uhr #659743

Poweruser

TeilnehmerPatty, lass ihn erst den Stromverbrauch von Kühlschrank, Gefrierschrank, Waschmaschine, Trockner etc… messen und mit neuen Top-Geräten vergleichen, bevor du was zahlst. Vllt. überlegt sich das Papa noch;) Falls die Geräte nicht neu sind, lässt sich da nämlich ne Menge Strom(Geld) sparen und das hält immernoch, wenn du weggezogen bist.Aber wie Spicy schon sagte, Hobbies haben sowieso meist wenig mit Vernunft zu tun…:)

-

13. Januar 2007 um 15:01 Uhr #659745

Spicy_Ice

TeilnehmerHAllo

Ich habe nie behauptet .das ich meine Strom sinnlos verbrate.Ich habe mir halt Hobby zugelegt,da kann ich nicht so auf den Stromverbrauch achten,da es einfach zu aufwendig ist.

Ist mir schon klar wenn ihr bei eueren Eltern lebt,das ihr auch nichts zahlen müsst.Dann ist es auch normal,das man den Verbrauch nicht in die höhe treiben solltet.Deshalb habe ich ja auch gefragt,wer den für seinen Strom zahlt.

Fast jedes Hobby kostet Geld.Manche weniger,manche mehr.

Und ich kaufe mir sicherlich auch nicht Hardware die enorm viel schluckt,wird immer wieder modifikationen geben,die den Verbrauch senken.