MK Kühlerprüfstation Version 2

Willkommen in der Mk-Community › Foren › Kühlung › MK Kühlerprüfstation › MK Kühlerprüfstation Version 2

- Dieses Thema hat 97 Antworten und 20 Teilnehmer, und wurde zuletzt aktualisiert vor 6 Jahren, 4 Monaten von

MK-Forum-Bot.

-

AutorBeiträge

-

-

6. Oktober 2010 um 14:10 Uhr #497620

VJoe2max

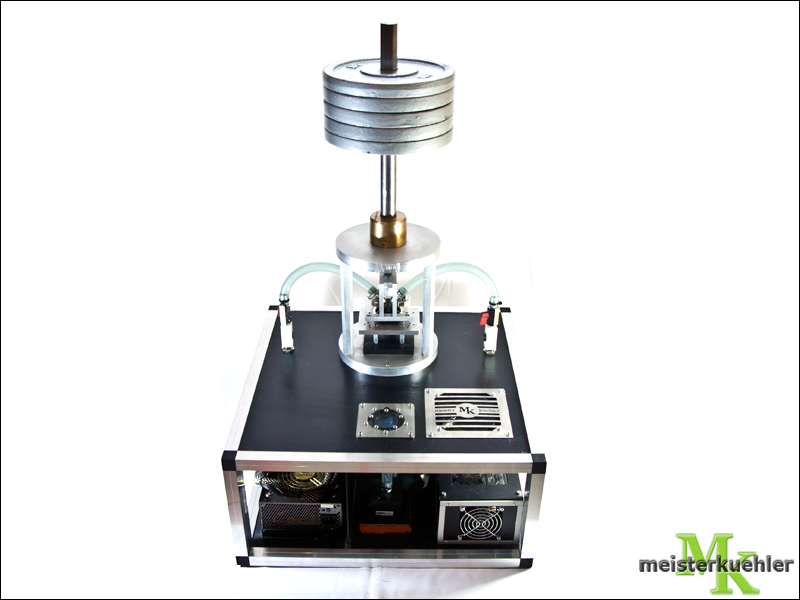

TeilnehmerNun ist es endlich ist es soweit: Die Meisterkühler testen nun selbst Wasserkühler!Nach mehreren Anläufen und viel Aufwand ist aus unserem Meisterkühler Teststand v.1 ist die MK-Kühlerprüfstation geworden, die wir euch in dem folgenden Artikel ausführlich vorstellen wollen.… ➡ mehr

-

Dieses Thema wurde geändert vor 6 Jahren, 4 Monaten von

MK-Forum-Bot.

-

Dieses Thema wurde geändert vor 6 Jahren, 4 Monaten von

-

6. Oktober 2010 um 15:10 Uhr #865178

Obi Wan

AdministratorProbiere es nochmal, bitte

-

6. Oktober 2010 um 15:10 Uhr #865180

AMD-ATI-Fan

Teilnehmerworks:d:

-

6. Oktober 2010 um 15:10 Uhr #865177

AMD-ATI-Fan

Teilnehmerwar ich zu früh?

AMD-ATI-Fan, Du hast keine Rechte, um auf diese Seite zuzugreifen. Folgende Gründe könnten z.B. dafür verantwortlich sein: 1. Du versuchst, den Beitrag eines anderen Benutzers zu ändern oder auf administrative Funktionen zuzugreifen. Überprüfe bitte in den Forenregeln, ob du diese Aktion ausführen darfst. 2. Wenn du versucht hast, einen Beitrag zu schreiben, kann es sein, dass dein Benutzerkonto deaktiviert wurde oder noch aktiviert werden muss.

-

6. Oktober 2010 um 18:10 Uhr #865201

borsti67

Teilnehmerwas soll man sagen – das Warten hat sich gelohnt! :respekt:

PS: Kleiner Typo auf Seite 10:

Die Versandkosten hin und zurück sind vom euch zu entrichten.

-

6. Oktober 2010 um 18:10 Uhr #865206

GoZoU

Moderatorborsti67;430016 said:

was soll man sagen – das Warten hat sich gelohnt! :respekt:PS: Kleiner Typo auf Seite 10:

Danke, wurde behoben :d:

AMD-ATI-Fan;430017 said:

bin auf die Testergebnisse gespannt:d:Ich auch :+:D

MfG

GoZoU -

6. Oktober 2010 um 18:10 Uhr #865202

AMD-ATI-Fan

Teilnehmerjup, der Artikel ist gut und sehr ausführlich:respekt:

bin auf die Testergebnisse gespannt:d:

-

6. Oktober 2010 um 20:10 Uhr #865226

Obi Wan

AdministratorAMD-ATI-Fan;430017 said:

bin auf die Testergebnisse gespannt:d:nur deshalb hat sich das ganze auch so lange hingezogen, um Hardwarefehler am Teststand auszuschließen und sicher zu sein, das die Testergebnisse jederzeit nachvollziehbar sind 😎

-

10. Oktober 2010 um 19:10 Uhr #865752

braeter

TeilnehmerIch glaubs ja nicht.Fast wär ich so wie DR.PEPPER beim Chinese Democracy Album von Guns`n`Roses reingelaufen. Zum glück hab ich nicht gewettet.Sehr schön, bin begeistert.Ich wünsch euch jede Menge “Aufträge” für den Teststand :d:Edit:DAS Bild hätt ich gern in Gross als Wallpaper. Wäre des möglich?

-

10. Oktober 2010 um 20:10 Uhr #865755

VJoe2max

TeilnehmerTHX 🙂 Du hast ja auch selbst tatkräftig mit geholfen. Danke noch mal dafür! Ohne deine Anpressspitze könnten Eigenbauten wohl kaum geprüft werden. Was lange währt …. ;)Mit dem Bild müsste GoZoU evtl. weiterhelfen können ;). Hab leider auch nur die kleine Version zur Verfügung.

-

11. Oktober 2010 um 17:10 Uhr #865910

GoZoU

Moderatorbraeter;430574 said:

DAS Bild hätt ich gern in Gross als Wallpaper. Wäre des möglich?Auf meinem Rechner liegt es leider nicht. Es kann sein, dass der 1cebaer es damals geschossen hat. Da er aber schon eine Weile nicht zu erreichen ist, mag ich dir keine große Hoffnung machen, dass ich es besorgen kann – werde es aber versuchen.@Michael_Jim: Danke für das freundliche Angebot, im Moment wollen wir uns aber erstmal auf Kühler ohne zentrale Anpressung beschränken. Oder handelt es sich um ein Bold-Modell? :)MfGGoZoU

-

11. Oktober 2010 um 17:10 Uhr #865301

Michael_Jim

TeilnehmerGoZoU;430753 said:

@Michael_Jim: Danke für das freundliche Angebot, im Moment wollen wir uns aber erstmal auf Kühler ohne zentrale Anpressung beschränken. Oder handelt es sich um ein Bold-Modell? 🙂ne ist der ganz normale mit der zentralen Anpressung für Sockel 775.

Hoffe ihr kriegt einen AC cuplex kryos HF und einen cuplex kryos XT. Möchte mal wissen, ob sie sich stark unterscheiden 😀

P.S. das Wallpaper will ich auch :d:

-

11. Oktober 2010 um 17:10 Uhr #865906

Michael_Jim

Teilnehmerman das ist sooo geil 😀

ich hoffe ihr kriegt viele Samples zum testen von verschiedenen Herstellern.

Habe leider nur einen sehr alten Alphacool NexXxoS XP. Aber falls Bedarf besteht würde ich den sofort zur Verfügung stellen.

ich freue mich schon auf viele Tests 🙂 -

11. Oktober 2010 um 18:10 Uhr #865915

Obi Wan

Administratorbraeter;430574 said:

Ich glaubs ja nicht.zum glück hab ich nicht gewettet.

Sehr schön, bin begeistert.

:shit: .. hätte ich mal nix gesagt, wäre ich jetzt reich 😎

-

12. Oktober 2010 um 20:10 Uhr #866047

braeter

TeilnehmerSchon mal nem Nackten in die Tasche gefasst?Ok, dann wart mer mal ab, vlt wirds ja was mit m Pic.Danke euch.

-

14. Oktober 2010 um 15:10 Uhr #557540

[LE]Al_bundy

Teilnehmerganz nette aufmachung,

vor 5 jahren haben mich die kaltmacher auseinander genommen wo ich ein pc netzteil zur versorgung der FETS hernehmen wollte. das hatte seine gründe. daher bin ich auf nen Laststabiles Labornt umgestiegen.

“Diese Halterung aus Alumium” macht euch nicht glücklich wenn ihr gerade anschlüsse verwenden wollt bei kühlern die einen zentralen einlass haben. der schlauch wird gegen die Halterung stoßen und macht ne menge arbeit den kühler aufzusetzen da er sich aufgrund des drucks (schlauch an halterung) immer verschieben wird,/will -> keine optimale Montage für einen Kühlertest. -> Kratzer entstehen am Boden (die das dT extrem verfälscht) sowie Wlp verschiebt sich stark asymetrisch. Von einen vergleicshtest kann dann keine rede mehr sein.die gegebenheit eines 16x16cores ist wirklich nur ein kompromiss.

cores mit 16×16 erreichen andere dT als ein core mit 16x24mm.

was wann wo wie kommen wird ist nich vorhersehbar. es ist immer besser einen core anhand einer aktuellen cpu zubauen und den core später der neuen prozessoren anzupassen.

wers nicht glaubt, vergleiche bitte die kühlerrankings von den amd plattformen zu den intelplattformen.

gutes beispiel phobya cpu cooler. auf amd geht der gut. auf intel kackt der ab. das ist unter anderen auch auf den unterschiedlichen coredimensionen zurückzuführen.Tip:

nimmt öl als wärmeleitpaste. pasten können größere körner beinhalten die das dT verfälschen -> kein symetrischer anpresspunkt mehr durch verkanten des wlp körnchens. das hat man bei öl nicht.

falls irgendjmd auf die idee kommen sollte den ihs planzuschleifen, dann bitte aber wieder vernickeln. spätestens nach 100tests ist der ihs müll.

es klingt doof, aber bei unvernickelten ihs kommen nach jeden test µkratzer rein, je nachdem welche partikel in der paste sind können auch mal gröbere kratzer entstehen wo dann der ihs nachgeschliffen werden muss. macht sich extrem ******* da nach jeden schleifen wieder 10 referenzmessungen gemacht werden müssen.ansonsten wünsche ich euch bei diesen projekt viel erfolg und viel spass

ahja noch eins…

150W sind für den core zu wenig. ihr werdet bestimmt ähnliche dT wie ich haben. ergo alle guten bin in 1K.

das sieht geiler aus wenn das dT weiter auseinander liegt. dann kommt auch die messtoleranz nicht so stark zum tragen. entweder mehr heizen, oder weniger kupfer am core. das sieht mir stark nach einen 10mm starken core aus. von den 150W kommen oberhalb des IHS nicht mehr viel an 😉

Bei meinen rebuild versuche ich den Core so flach wie möglich zu halten und nutze 2fets um notfalls auch mit über 200W heizen zu können. theoretisch sind dann bis zu 400W drin.und überhaupt.

geiles Anpresslayout;) -

14. Oktober 2010 um 16:10 Uhr #866270

VJoe2max

Teilnehmer@Marc: Schön, dass du dir unseren Prüfstand angesehen hast und, dass er dir gefällt :)Allerdings muss ich fast alle Kritikpunkte die du anbringst entkräften (eigentlich alle):Zur Stromversorgung: Ein heutiges ATX-Netzteil ist was die Spannungsstabilisierung und die Leistungen auf der 12V-Schiene angeht so manchen Labornetzteil überlegen. Zumal wir ja, wie du, mit der WPS arbeiten. Wir haben die präzise Version mit Shunt (von Marco) im Einsatz und die Stromversorgung wurde, wie du auch in der Doku siehst, exakt abgeglichen. Die Stromversorgung funktioniert in dieser Konfiguration bestens und die Abgabeleistung stimmt überaus exakt. Hätten wir hier Probleme festgestellt, hätten wir evtl. auch gewechselt – aber das stellte sich als völlig unnötig heraus. Das Enermax-Netzteil verrichtet hervorragend seinen Dienst für diesen Zweck! Hier auch noch mal der Dank an den Sponsor des Kraftpakets!OT: Dir wurden dort damals bei KM/EKM vor allem andere Dinge um die Ohren gehauen. Das Netzteil war nur ein Aufhänger wenn ich das richtig in Erinnerung habe ;). Zur Halterung: Hast du dir die mal genau angesehen und den Unterschied zu deiner Halterung erkannt? All die Punkte die du anführst haben wir konsequent ausgeräumt. Es gibt mit unseren Halterungen keinerlei Verschieben des Kühlers auf dem DIE-Sim, da die Halterung selbstzentrierend und winkelausgleichend aufgebaut ist. Der Prüfling wird so immer exakt gleich belastet und es gibt keinerlei Verschiebungen ;). Die Reproduzierbarkeit der Anpressung ist so besser als mit jeder Methode die wir bis jetzt bei anderen Prüfständen finden konnten. Deine Ur-Version hätte mit ein wenig mehr Aufwand durchaus auch so funktionieren können ;). Wir haben dieses Grundkonzept etwas anders umgesetzt und (imho) entscheidend verbessert. Damit wurden alle fallbacks die du anführst beseitigt und grundlegende Verbesserungen des Konzepts umgesetzt. Dass wir die Steifigkeit der Kühlerhalterungen mit prüfen ist btw einkalkuliert und beabsichtigt. Eines der größten Probleme deiner Halterung nach diesem Prinzip waren btw die langen Anpresstangen, ohne vernünftige Führung. Dass es da zu starken Verschiebungen kommt ist kein Wunder gewesen ;). Das kann mit unserem Aufbau nicht passieren. Durch die Selbstzentrierung über die Kugel haben wir zudem keinerlei Versatz um die Hochachse. Das Schlauchargument hat uns bei der ersten Version der oberen Halterung auch noch ein wenig Sorgen gemacht – jedoch nicht so krass wie bei deiner Plattenhalterung. Bei der zweiten Version, die zusätzlich auch für AMD-Sockel geeignet ist, wurde das Problem komplett beseitigt (nicht nur durch die verhältnismäßig große Höhe sondern auch durch die Form des Bügels):

Der Schlauch berührt die Halterung so überhaupt nicht und übt dementsprechend auch keine Kräfte auf die Halterung aus ;).Kühler mit mittigem Einlass können so problemlos mit geraden Anschlüssen genutzt werden. Allerdings verwenden wir grundsätzlich 45°-Adapter, um keinerlei unterschiedliche Bedingungen im Anströmverhalten zu erzeugen. Im Übrigen haben wir von Beginn an mit Silikonöl gearbeitet und nicht mit WLP. Wenn du die Doku aufmerksam gelesen hättest wäre dir das aufgefallen ;). Zum DIE-Sim:Dass 16x16mm simulierte DIE-Fläche ein Kompromiss sind bezweifelt niemand. Genau so ist es gedacht ;). Deine Ansicht, dass es besser sei das DIE-Sim irgendeiner realen CPU nach zu empfinden entspricht nicht unserer Auffassung. Ein DIE-Sim ist keine CPU und liefert auch bei gleicher Auflagefläche keineswegs das gleiche DeltaT wie eine reale CPU. Wir haben daher eine Fläche gewählt die ungefähr einer durchschnittlichen DIE-Fläche entspricht, um eine realistische Leistungsdichte einzuleiten. Wichtiger als gleiche Flächen wie vergängliche CPU-Designs ist für vergleichbare Test über lange Zeiträume hinweg – ganz in der Tradition des WCP-Prüfstands – eine gleichbleibende Basis mit einer festgelegten Leistungsdichte. Kühlerrankings die mit realen CPUs erstellt wurden sind per se nicht vergleichbar mit Ergebnissen physikalischer Prüfstände. Es wäre grober Unsinn dies zu behaupten oder anzustreben. Ein physikalischer Prüfstand kann jedoch eine solide Leistungseinschätzung verschiedener Kühlerdesigns liefern und damit zur zielgerichteten Weiterentwicklung beitragen. Das ist der Hauptanspruch den wir mir der MK-Kühlerprüfstation bestmöglich umsetzen wollen. Die Ergebnisse sollen vor allem die Kühlerentwicklung im Bastler-Bereich weiter bringen. Edit: Dass dabei natürlich auch die Kühler mit den besten Kühlleistungen ganz vorne im Ranking landen ist ein Nebeneffekt, den man, wenn man möchte, natürlich zur Auswahl des eigenen Wasserkühlers heran ziehen kann ;). Im Übrigen können die so ermittelten Delta-T natürlich auch als Anhaltspunkte für die Performance auf realen CPUs heran gezogen werden. Dass man aber nicht einfach seine Wassertemperatur messen kann und das DeltaT eines Prüfstandes dazurechnen kann, sollte jedem klar sein – selbst wenn man mit dem Prüfstand versuchen würde möglichst exakt die verwendete CPU abzubilden. Ein besserer Anhaltspunkt als die Sensorwerte einer CPU ist diese Methode jedoch allemal. Dass Kühler auf verschiedenen CPUs unterschiedlich performen ist eine Binsenweisheit und es ist, unserer Auffassung nach, nicht die Aufgabe physikalischer Prüfstände dies zu beweisen ;). Zur “WLP”:Wie oben bereits erwähnt, verwenden wir seit jeher Silikonöl auf dem Prüfstand. Unser DIE-Sim ist mit einem sehr planen vernickelten AMD-IHS ausgestattet. Das DIE-Sim wird nicht nachgeschliffen. Zur Heizleistung:150W sind genug! Wenn man sich im realistischen Bereich bewegen will. Mit mehr Leistung bewegt man sich zum Einen weit ab von realen Verlustleistungen. Eine deutlich höhere Leistungsdichte anzulegen als in der Realität spreizt zum Anderen zwar die Messergebnisse besser, so dass man weniger Aufwand bei Kalibrierung und Messwertaufbereitung treiben muss, aber es führt auch dazu, dass der Kühler nicht seinen realen Betriebsbedingungen entsprechend geprüft wird. Wie “geil” ein Diagramm aussieht ist uns btw ziemlich egal ;). Uns interessieren die tatsächlichen Unterscheide in der Kühlleistung verschiedener Kühlerarchitekturen.Durch eine wesentlich höhere Heizleitung kann sich jedenfalls z.B. die laterale Wärmeverteilung deutlich verändern. So könnten Kühler die in der Realität eher bescheiden abschneiden auf dem Prüfstand deutlich besser da stehen. Wir wollen aber eine realitätsnahe Reihung der Kühlleistungen ermitteln ;). Aus diesem Grund haben wir die 150W auch sehr bewusst gewählt, obwohl wir mit dem Infinion SPP80P06P Heiz-FETs den wir einsetzen, noch wesentlich höhere Heizleistungen erzielen könnten (prinzipiell bis zu max. 340W) ;). Zum “Wärmeverlust” des DIE-Sims:Dass ein dicker Kupfercore Wärme an den falschen Stellen verlieren könnte ist uns bewusst ;). Deshalb haben wir eine ziemlich gute Isolierung verbaut. Der Kern ist komplett in POM gekapselt und wird von unten durch eine Siliziumnitridplatte auf einer weiteren POM-Platte abgestützt. Auf diese Weise ist der Kern bestens davor geschützt Nennenswerte Wärmeverluste an die Umgebung zu erleiden. Es dürfte so sogar erheblich weniger sein, als eine reale CPU ans PCB verliert. Auch diese Überlegung hat uns dazu veranlasst die Heizleistung nicht noch höher anzusetzen. Zur Aluminiumplatte herrscht im Übrigen eine Spielpassung mit Luftspalt. Das dient neben der Isolierung auch dem Winkelausgleich, denn die Siliziumnidridplatte ist zu diesem Zwecke ballig geschliffen – das erfordert den entsprechenden Bewegungsraum für das Modul. Zusammen mit dem ebenfalls Winkelversatz ausgleichenden oberen Haltungsmodul ist so immer eine perfekt orthogonale Krafteinleitung gewährleistet ;).@Anpresslayout: Den offiziellen Dank an deine Person für die Idee und die Unterstützung damals findest du explizit im Text der Doku 😉 :d:.Ich verfolge btw stets interessiert die Arbeiten an deinem Prüfstand-Rebuild. Bis jetzt habe ich da ein paar gute Ansätze aber leider auch ein paar unnütze Dinge ausmachen können….Was die kompromisslose Higflow-Auslegung bewirken wird, kannst du recht gut an unseren, bis jetzt recht mageren, Kühlercharts aber auch an deine eigenen Ergebnissen ablesen. Aber das Thema hatten wir früher ja schon mal ausführlich durchgekaut ;). Die Ergebnisse deines bisherigen Prüfstands waren jedenfalls alles andere als schlecht :d:. Im großen und ganzen bildeten sie auch viele Erfahrungen ab, die wir während der zahllosen Vortests die wir schon durchgeführt haben, nachvollziehen konnten. In einigen Punkten hätte man an deinem alten Prüfstands-Layout noch Verbesserungen anbringen müssen, aber im großen und Ganzen ist das schon eine Referenz ähnlich den bekannten WCP-Tests.

-

14. Oktober 2010 um 17:10 Uhr #866282

ulv

Teilnehmer@Al_bundy

Danke für deine Kritik! Es wird nie den einen Teststand geben und ich finde es sogar gut, wenn dein Teststand eine etwas andere Ausrichtung hat als unserer. Daher wünsche ich dir viel Erfolg mit deiner V2!‘[LE said:

Al_bundy;431156′]

Heizleistung:

ich bezweifel stark das der wirkungsgrad besser ist bei einen DIESIM als bei einer CPU. Mittels wie lange dauert es bis 20°C kaltes wasser sich auf 60°C erwärmt hat kann man den wirkungsgrad und somit auch die abgabewärmeleistung berechnen. ich würde mich jetzt ganz schwer verheben wenn ein DIESIM schneller das Wasser erwärmen würde als eine CPU mit gleicher Verlustleistung. und meine empfindung ist das 150W zu wenig sind. es spielt keine rolle wieviel man an energie reinsteckt, entscheident ist was oberhalb am ihs ankommt. es geht sehr viel energie verloren wenn die wärmeenergie erst durch 10mm kupfer durch muss, anstatt durch weniger zehntel mm silizium.

bei zeiten werde ich euch das darstellen können. extre nur für die skeptiker unter euch 😉Das hier tut meinem Dipl.-Ing.-Herzen aber schon sehr weh. Ich meine, das ist alles richtig bis auf die fett gedruckte Stelle!

Wenn du das wirklich zeigen kannst schlag ich dich für den Nobel-Preis vor. O:-)

Energie geht nie verloren! Da gibt es doch so ein paar Hauptsätze der Thermodynamik.

Wenn du damit sagen willst, dass die Energie zur Seite verschwindet dann hast du die von VJoe beschriebene Wärme-Isolierung an der Seite und unterhalb des DIE-Sim übersehen. -

14. Oktober 2010 um 17:10 Uhr #866279

[LE]Al_bundy

Teilnehmerzur halterung:

nutzt man gerade anschlüsse, ist der kühler deckel sehr hoch, und nutzt man einen schlauch mit hohen biegeradien hast du spannung.

da müsstest du schon ca 100mm luft zwischen oberkannte kühler und unterkannte der halterung haben. bei 45° anschlüssen is das dann aber wieder völlig latteDIESim:

da hast du was falsch verstanden. mit unterschiedlich “krassen” abmessungen wie beispielsweise 16×16 auf 24x16mm wirst du bei einigen Kühlern eine rankingsverschiebung haben. da nicht jeder kühler an jeden punkt den selben wirkungsgrad hat. das lässt sich sogar sehr einfach testen.

teste einen nexxos xp Rev.2 und einen nexxxos xp highflow auf einen AMD Athlon XP Diesim und auf einen Core2 Duo DIESIM. du wirst feststellen das auf den Athlon der XP vorne liegt und auf den Core 2 Duo, der highflow vorne liegt da der XP für kleien Cores und der highflow für große Cores hergestellt wurde. beides haben identische in und outs sowie bodenplatten. ergo gilt diese aussage nicht mehr, bzw. maximal bedingt“Im Übrigen können die so ermittelten Delta-T natürlich auch als Anhaltspunkte für die Performance auf realen CPUs heran gezogen werden.”

“Wir haben daher eine Fläche gewählt die ungefähr einer durchschnittlichen DIE-Fläche entspricht, um eine realistisch Leistungsdichte einzuleiten”

“Dass Kühler auf verschiedenen CPUs unterschiedlich performen ist eine Binsenweisheit”

Heizleistung:

ich bezweifel stark das der wirkungsgrad besser ist bei einen DIESIM als bei einer CPU. Mittels wie lange dauert es bis 20°C kaltes wasser sich auf 60°C erwärmt hat kann man den wirkungsgrad und somit auch die abgabewärmeleistung berechnen. ich würde mich jetzt ganz schwer verheben wenn ein DIESIM schneller das Wasser erwärmen würde als eine CPU mit gleicher Verlustleistung. und meine empfindung ist das 150W zu wenig sind. es spielt keine rolle wieviel man an energie reinsteckt, entscheident ist was oberhalb am ihs ankommt. es geht sehr viel energie verloren wenn die wärmeenergie erst durch 10mm kupfer durch muss, anstatt durch weniger zehntel mm silizium.

bei zeiten werde ich euch das darstellen können. extre nur für die skeptiker unter euch 😉bzgl. meines setups.

es gibt in der tat einige dinge die nicht optimal sind, die jedoch redaktionel gesehen schon weiter über die norm liegt. ich hatte an den ding knapp 2 jahre gebaut und irgendwann muss man einen schlussstrich ziehen. optimierungen kann man immer vornehmen, da jedes setup optimierbar ist.

da mein DIESim zu sehr verschlissen ist, und es seid geraumer zeit multicore cpu’s gibt sowie es zwischendurch finanziell etwas besser lief, habe ich mich für ein rebuild entschieden wo einige fehler (nicht alle) behoben werden. insbesondere auch die Anpressgeschichte.edit: salop kann man sagen durch den DIESIM kann für dieses setup der beste kühler ermittelt werden, das ranking auf reale intel oder AMD platformen zu übertragen funktioniert aber nicht mehr.

streich das mit der halterung. hast ja recht^^

ich sollte mir die bilder gewissenhafter anschauen^^ -

14. Oktober 2010 um 18:10 Uhr #866283

[LE]Al_bundy

Teilnehmeris schon richtig. ich werd später mal mit meinen grill udn meine cpu wasser kochen und diagramme anheften.

das muss nicht heißen das von 150 W nur 80 ankommen. als unerheblich was da “verloren” geht erachte ich es jedoch nicht. -

14. Oktober 2010 um 19:10 Uhr #866286

VJoe2max

Teilnehmer‘[LE said:

Al_bundy;431156′]zur halterung:nutzt man gerade anschlüsse, ist der kühler deckel sehr hoch, und nutzt man einen schlauch mit hohen biegeradien hast du spannung.da müsstest du schon ca 100mm luft zwischen oberkannte kühler und unterkannte der halterung haben. bei 45° anschlüssen is das dann aber wieder völlig latte.Wir haben beides :D. – ca. 100m Luft und 45° Adapter ;).

‘[LE said:

Al_bundy;431156′]DIESim:da hast du was falsch verstanden. mit unterschiedlich “krassen” abmessungen wie beispielsweise 16×16 auf 24x16mm wirst du bei einigen Kühlern eine rankingsverschiebung haben. da nicht jeder kühler an jeden punkt den selben wirkungsgrad hat. das lässt sich sogar sehr einfach testen.teste einen nexxos xp Rev.2 und einen nexxxos xp highflow auf einen AMD Athlon XP Diesim und auf einen Core2 Duo DIESIM. du wirst feststellen das auf den Athlon der XP vorne liegt und auf den Core 2 Duo, der highflow vorne liegt da der XP für kleien Cores und der highflow für große Cores hergestellt wurde. beides haben identische in und outs sowie bodenplatten. ergo gilt diese aussage nicht mehr, bzw. maximal bedingtNatürlich kann es zu Verschiebungen im Ranking kommen, wenn man unterschiedliche DIE-Sim-Flächen einsetzt. Keine Frage – hab ich oben auch schon gesagt ;). Das ist aber nicht so rasend interessant, denn DIE-Flächen ändern sich ständig. Es hat daher aus unserer Sicht keinen Sinn sich auf ein bestimmtes Flächenlayout einzulassen, welches nach kurzer Zeit in der Realität nicht mehr vorkommt. Wir haben unsere DIE-Fläche daher u.A an der Wirtschaftlichkeitsrechnung fest gemacht. Demnach ist die Wahrscheinlichkeit, dass die DIEs im Durchschnitt deutlich größer werden extrem gering, weil dies die Chips zu teuer machen würde. Dass sie deutlich kleiner werden ist ebenso ausgeschlossen, solange Moores-Law auf Biegen und Brechen von den Chipgiganten eingehalten wird. Ein Ende dieses Umstands ist nicht abzusehen. Ein zweiter Aspekt war – wie treffend – das Aspektverhältnis :D. Wir haben eine quadratisches Fläche gewählt, weil dies ebenfalls eine Annäherung an den Durchschnitt darstellt. Man hätte auch ein runde Fläche nehmen können, aber dies würde konzentrische Kühlstrukturen über Gebühr bevorzugen. Rechteckige Flächen mit hohen Aspektverhältnissen bilden nur nur bestimmte CPUs ab, deren DIE ebenfalls ein hohes Aspektverhältnis hat. Die meisten CPUs, insbesondere die der sehr leistungsfähigen Modelle, haben aber schon aus Gründen des Wafer-Verschnitts tendenziell häufiger quadratische oder nahezu quadratische DIE-Flächen. Ausnahmen bestätigen hierbei freilich die Regel ;).

‘[LE said:

Al_bundy;431156′]”Im Übrigen können die so ermittelten Delta-T natürlich auch als Anhaltspunkte für die Performance auf realen CPUs heran gezogen werden.Wir haben daher eine Fläche gewählt die ungefähr einer durchschnittlichen DIE-Fläche entspricht, um eine realistisch Leistungsdichte einzuleitenDass Kühler auf verschiedenen CPUs unterschiedlich performen ist eine Binsenweisheit”Siehst du etwa einen Widerspruch :D. Oberflächlich betrachtet mag das so erscheinen – nicht aber wenn du unsere Zielsetzung betrachtest ;). Die MK-Kühlerprüfstation hat, neben den Rankings für die Kühlercharts, eine etwas andere Zielsetzung als die meisten Hardware- und auch einige richtige Prüfstände. Das Ranking was dabei entsteht, bildet für eine Großzahl von CPUs dennoch recht gut die Leistungsfähigkeit verschiedener Kühler ab. Im Übrigen zeigen die ersten Ergebnisse auch bereits wie unwichtig die Frage nach dem absolut besten Kühler für eine bestimmte CPU tatsächlich ist, wenn es nicht um die Jagd nach dem letzten Viertel-Grad geht, sondern einfach nur um gute Kühlung.Wenn sich die Unterschiede für ein durchschnittliches CPU-Layout, wie wir es simulieren, bereits in so geringem Rahmen bewegen sind die Unterschiede auch sonst nicht gewaltig – das zeigen ja auch deine Ergebnisse bei den Top-Kühlern. Zumal ja in der Realität immer noch Faktoren wie die Planizität des IHS oder die WLP eine erhebliche Rolle spielen, die gut und gerne größer als die Unterschiede in der reinen Kühlleistung zwischen den verschiedenen Kühlern sein können. Was ich damit sagen will: Wir machen hier nicht die direkte Konkurrenzveranstaltung zu Hardwaretestern wie bundymania und Co. und auch nicht zu deinen CPU-orientieren Messungen, sondern wir wollen eher in der Nische der WCP-Tests Fuß fassen. Deren anerkannt saubere Methodik haben wir auf moderne Gegebenheiten angepasst und wollen versuchen, damit vor allem Kühlerbastlern vernünftige Grundlagen an die Hand zu geben, indem wir versuchen die besten Prinzipien die zu besonders guten Kühlleistungen führen Stück für Stück heraus zu arbeiten. Wir hoffen, dass die Diskussion dieser Ergebnisse im Forum letztendlich dazu führen neue Konzepte und Ideen zu entwickeln, wie sich vllt. noch mal ein deutlicher Sprung bei der Kühlleistung realisieren lässt. Nicht zu Letzt deshalb gibt es auch das Angebot Bastler-Kühler zu prüfen. Dass man die Ergebnisse natürlich auch zur Bewertung kommerzieller Kühler oder existierender Eigenbauten heranziehen kann ist ein positiver Nebeneffekt. Die Ergebnisse sind dafür prinzipiell nicht besser aber auch nicht schlechter geeignet als die anderer physikalischer Prüfstände ;). Wie bei jedem Prüfstand muss man sich einfach vor Augen halten, dass die Messergebnisse im Gegensatz zu Tests auf Hardware zwar wesentlich genauer sind, aber eben auch kein reales Setup darstellen. Im Großen und Ganzen stimmt das Ranking in der Realität und im Prüfstandsversuch dennoch oft mit dem auf realen Setups erstaunlich gut überein. Je weiter jedoch ein reales Setup beim User von den Randbedingungen eines Prüfstandversuchs oder auch eines Tests auf Hardware abweicht, desto weniger genau werden sich die Ergebnisse entsprechen – auch das ist aber eine Binsenweisheit ;).

‘[LE said:

Al_bundy;431156′]Heizleistung:ich bezweifel stark das der wirkungsgrad besser ist bei einen DIESIM als bei einer CPU. Mittels wie lange dauert es bis 20°C kaltes wasser sich auf 60°C erwärmt hat kann man den wirkungsgrad und somit auch die abgabewärmeleistung berechnen. ich würde mich jetzt ganz schwer verheben wenn ein DIESIM schneller das Wasser erwärmen würde als eine CPU mit gleicher Verlustleistung. und meine empfindung ist das 150W zu wenig sind.Mal immer ruhig mit den jungen Pferden! Deine Empfindung in allen Ehren, aber die Physik lässt sich ungern austricksen ;). Im Übrigen wird der Umstand der unterschiedlichen Aufheizraten, wie schon bei WCP, auch in unseren Tests durch die dualen Auswertungsprotokolle voll berücksichtigt und dokumentiert. Für den stationären Zustand hat das jedoch keinen Einfluss. Aber nur im stationären Zustand kann eine Aussage über die tatsächliche Kühlleistung des Kühlers getroffen werden. Wie lange ein Kühler braucht braucht, um das Wasser bei einer gegebenen eingeleiteten Heizleistung (egal wie hoch sie ist) in den stationären Zustand zu bringen hängt von Faktoren wie der Kühlermasse, der Wärmekapazität des verbauten Materials und andern Faktoren ab. Das Maß für die Kühlleistung eines Kühlers ist aber ausschließlich das DeltaT zwischen DIE-Sim Temperatur und Wassertemperatur im stationären Zustand – und zwar ausschließlich in diesem! Die Heizleistung hat darauf nur hinsichtlich der erzielten Werte Einfluss, aber nicht hinsichtlich des Wirkungsgrades. Im Prinzip könnte man auch mit 10W Heizleistung testen. In diesem Fall würden die Differenzen aber unmessbar und von der Realität wäre man himmelweit entfernt.Das DIE-Sim selbst hat auf die Heizleistung nur einen statischen Einfluss wie auch das Package einer CPU einen statischen Einfluss auf den Wärmeabfluss in andere Richtungen als zum Kühler hat. Würde man das DIE-Sim unisoliert betreiben, wäre bei einem massiven Kupferblock sicher ein recht erheblicher Abfluss von Wärme an die Umgebung zu verzeichnen. Die ist natürlich zu vermeiden. Aus diesem Grund haben wir eben den Aufwand mit der Isolierung getrieben. Es lässt sich zwar schwer messen, aber angesichts dessen, wie stark sich das PCB unter realen CPUs aufheizt, selbst wenn ein Wasserkühler auf der anderen Seite den Großteil der Abwärme abzieht, kann man ziemlich sicher sagen, dass unser mollig verpacktes DIE-Sim deutlich weniger Wärme an die Umgebung verliert, als an den Kühler. Von daher ist unser DIE-Sim vermutlich einiges “effizienter” (in dem von dir gemeinten Sinne) was die Aufheizrate angeht, als eine übertaktete CPU, welche die gleiche nominelle elektrische Leistung aufnimmt. Unsere 150W bilden daher schon eher den Extremfall einer sehr stark übertakten CPU ab.Und bitte kommt mir jetzt nicht mit der TDP ;).

‘[LE said:

Al_bundy;431156′]es spielt keine rolle wieviel man an energie reinsteckt, entscheident ist was oberhalb am ihs ankommt. es geht sehr viel energie verloren wenn die wärmeenergie erst durch 10mm kupfer durch muss, anstatt durch weniger zehntel mm silizium.bei zeiten werde ich euch das darstellen können. extre nur für die skeptiker unter euch 😉Da bin ich ja sehr gespannt wie du den ersten Hauptsatz der Thermodynamik außer Kraft setzt :D. Wenn du das Die-Sim natürlich nicht isolierst, wird tatsächlich einiges in die Umgebung abfließen ;). Die Triebkraft der Wärmeübertragung ist der Temperaturgradient. Der Gegenspieler ist die Wärmeleitfähigkeit bzw. der spezifische Wärmewiderstand zwischen den Orten unterschiedlicher Temperatur. (und natürlich auch die Wärmeübergangskoeffizienten).

‘[LE said:

Al_bundy;431156′]bzgl. meines setups.es gibt in der tat einige dinge die nicht optimal sind, die jedoch redaktionel gesehen schon weiter über die norm liegt. ich hatte an den ding knapp 2 jahre gebaut und irgendwann muss man einen schlussstrich ziehen. optimierungen kann man immer vornehmen, da jedes setup optimierbar ist.da mein DIESim zu sehr verschlissen ist, und es seid geraumer zeit multicore cpu’s gibt sowie es zwischendurch finanziell etwas besser lief, habe ich mich für ein rebuild entschieden wo einige fehler (nicht alle) behoben werden. insbesondere auch die Anpressgeschichte.Das hört sich doch gut an :d:. Klar – man muss alte Hüte auch irgendwann mal umkrempeln oder durch Neue ersetzen ;). Da spricht nichts dagegen. Ich hoffe du setzt alle Erfahrungen die du mit dem ersten Prüfstand gewonnen hast bestmöglich in deinem ReBuild um. Versteif dich aber nicht zu sehr auf die High-Flow-Maßnahmen. Das ist nur ein Nebenkriegsschauplatz ;). Wird bestimmt auch ein sehr schöner Prüfstand! Freue mich schon auf´s nächst Update :)Der hier vorgestellte Prüfstand ist im Prinzip ja auch schon die zweite Generation (deshalb auch MK-Kühlerprüfstation Version2). Da hat sich in der Zwischenzeit insbesondere im Bereich des Temperaturabgleichs und vor allem im Auswertungsbereich gegenüber der nie offiziell in Betrieb genommen ersten Version schon Einiges getan. Ansonsten könnten wir auch mal ganz abgesehen von der verbesserten Mechanik nie die gute Reproduzierbarkeit erreichen die wir inzwischen haben. Die grundlegenden Arbeiten und Erkenntnisse die Bison damals federführend mit der ersten Version gewonnen hat, haben extrem viel zum letztendlichen Gelingen des Projekts beigetragen (nicht zuletzt aber auch zur Doku des Ganzen). Eine Weiterentwicklung ist also in jedem Fall sinnvoll und wird in deinem Falle sicher auch deinem ReBuild-Prüfstand zu Gute kommen ;).

-

14. Oktober 2010 um 20:10 Uhr #866288

[LE]Al_bundy

Teilnehmerleienhaft geschrieben liest sich der erste teil so, als ob ihr eure eigene umgebung schafft und die bestehenden setups (intel und amd) ignoriert, nicht nur weil es unwichtig ist zu differenzieren sondern auch da der aufwand zu groß wäre einmal pro jahr, oder spätestens 1x in 2 jahren einen neuen core zu installieren?!

“Natürlich kann es zu Verschiebungen im Ranking kommen, wenn man unterschiedliche DIE-Sim-Flächen einsetzt. Keine Frage – hab ich oben auch schon gesagt . Das ist aber nicht so rasend interessant, denn DIE-Flächen ändern sich ständig. Es hat daher aus unserer Sicht keinen Sinn sich auf ein bestimmtes Flächenlayout einzulassen, welches nach kurzer Zeit in der Realität nicht mehr vorkommt.”

Dieser Satz passt nicht zur folgenden aussage

“Im Übrigen zeigen die ersten Ergebnisse auch bereits wie unwichtig die Frage nach dem absolut besten Kühler für eine bestimmte CPU tatsächlich ist, wenn es nicht um die Jagd nach dem letzten Viertel-Grad geht, sondern einfach nur um gute Kühlung.”

“und wollen versuchen, damit vor allem Kühlerbastlern vernünftige Grundlagen an die Hand zu geben, indem wir versuchen die besten Prinzipien die zu besonders guten Kühlleistungen führen Stück für Stück heraus zu arbeiten. ”

mit verstand kann man da nicht schreiben. denn es macht faktisch keinen sinn ob die cpu 50 oder 55°C hat. dennoch gibt es die typen die aufs zehntel grad aussind. und davon gibt es nicht zu wenig, insbesondere bei den kühlerbastlern mit viel ergeiz. da darf man sich nicht die frage nach sinn oder unsinn stellen. die typen sind da, und die wollen auch bedient werden. und die typen die auf testständen testen lassen wollen, erwarten das auch. anders als bei hobbybastlern die mit dremel und lötlampe arbeiten. die ermitteln das zu hause an ihre eigene cpu und freuen sich ergänzend auf werte eines teststandes so wie wir sie haben.

wenn es nur darum geht:

“und wollen versuchen, damit vor allem Kühlerbastlern vernünftige Grundlagen an die Hand zu geben, indem wir versuchen die besten Prinzipien die zu besonders guten Kühlleistungen führen Stück für Stück heraus zu arbeiten. ”dann hätte es ein Crosshair 4 und ein 1055T auch getan. und man hätte sich nicht den kritischen aussagen stellen müssen, ” völligrealitätsfremd” was auch nur bedingt stimmt und zugelassen werden kann.

Dann noch ein paar zeilen zu der core geschichte.

das fängt beim wärmeübergang fet core an, geht hin zu massiven kupfer, zu einen weiteren wärmeübergang core ihs, insbesondere deren fläche des DIE. umso größer die fläche des DIE desto mehr wärmenergie kann kann an den IHS abgegeben werden. hast du jetzt 30% weniger fläche am DIE, kommt defakto physikalus nicht so viel wärme zum ihs, was hier entweder als nichtig betrachtet wird, oder nicht bedacht wurde. isolierung hin oder her, das is ganz lustig, aber alles andere ist einer realen cpu, was den verlust der wärmeenergie zwischen erzeugungsort der wärmenergie und abgabeort der wärmenergie angeht, meilenweit unterlegen 😉

daher finde ich 150W schon etwas mager, um genau zu sein eher das minimum. da es ja nun um einen vergleich zu intel oder AMD nicht geht, kann auch die Verlustleistung abweichen, sodass die streuung der ergebnisse deutlicher wird. -> höherer dT -

14. Oktober 2010 um 23:10 Uhr #866316

[LE]Al_bundy

TeilnehmerAMD-ATI-Fan;431194 said:

hä? das ist doch bei einer normalen CPU nicht anderst als beim

bedingt ja.

AMD-ATI-Fan;431194 said:

Teststand: der DIE ist wesentlich kleiner als der IHS!hat niemand was anderes geschrieben 😉

AMD-ATI-Fan;431194 said:

wenn man jedes Jahr den kompletten heiz-Teil ersetzt ist das nicht nur Kostenaufwändig, sondern man müsste auch alle vorher getesteten Kühler nochmals testen, um vergleichbare Ergebnisse zu liefern 😉ein preis den man zahlen muss umein aktuelles setup präsentieren zu können.

wenn es um die kosten geht, dafür gibt es sponsoren 😉VJoe2max;431195 said:

Du kennst den WCP-Prüfstand nicht wahr? Und jetzt überleg mal wie das dort ablief . In ähnlicher Art und Weise wollen wir das auch machen.Die bestehenden DIE-Layouts von Intel und AMD sind überaus unterschiedlich es gibt x verschiedene Kerne auf dem Markt die sich in den Rechnern dieser Welt unter einer Wakü wiederfinden. Was hilft es einem User mit, sagen wir einem Gulftown-User, wenn du ein DIE-Sim einsetzt dass den Bloomfieldkern möglichst exakt abbildet, oder – noch extremer – einem Deneb-User wenn du einen Thuban-Kern simulierst. Erkennst du die Problematik? Derlei Kombinationen gibt es noch weit mehr und mit weit unterschiedlicheren DIE-Flächen. Kein Kühlertester der Welt würde auf die Idee kommen alle abzubilden. Nehmen wir also an du entscheidest dich für ein DIE-Sim, welches den Bloomfield-Kern abbildet (afaik hast du das ja getan). So schließt du nach deiner CPU-spezifischen Herangehensweise erst mal alle User mit CPUs aus die andere Kerne nutzen. Zumindest bietest du für diese User weniger brauchbare Ergebnisse an als für die Bloomfiel-Nutzer. Du bietest also effektiv, egal für welchen Kern du dich entscheidest, grundsätzlich für die überwiegende Mehrheit der Wakü User Ergebnisse die für deren CPUs wenig bis sehr wenig Aussagekraft haben. Lediglich die Nutzer des Kern für den du dich entschieden hast profitieren davon (sofern man das so sagen kann – ein Prüfstand ist wie gesagt keine CPU).

Unser Ansatz ist ein anderer. Wir testen mit einer DIE-Fläche die real so in keinem Kern bzw. nur annähernd bei einigen Kernen vorkommt. Im Mittel stimmt die Leistungsdichte die wir damit erzeugen aber besser mit einer größeren Anzahl an Kernen überein, als dein Bloomfield-DIE-Sim. Zudem ist es wie gesagt relativ egal auf welche Referenzfläche man sich bezieht (wenn sie nicht völlig unrealistisch für eine CPU ist), solange es darum geht heraus zu finden welche Kühltechnik eine besonders hohe Kühlwirkung erzeugt. Unser Kompromiss bei der Kühlfläche soll genau dem Rechnung tragen. Das Ranking was sich durch dieses Vorgehen ergibt, zum Einen ein klares Bild über den Einfluss der Kühltechnik auf die Kühlleistung an sich, und zum Anderen ergibt es für eine weit größere Zahl an DIEs ein Kühler-Ranking welches der Realität besser gerecht werden sollte als das Kühleranking was für einen bestimmten Kern optimiert ist. Von so einem Ranking wie bei dir profitiert genau genommen ja nur ein kleiner Bruchteil der User. Von einem Ranking wie es mit einem Kompromiss wie dem unseren zu erwarten ist, profitieren viel mehr User in ähnlicher Weise.

ja, bei mir profitiert nur eine kleine gruppe, bei core maßen die es real aber nicht gibt, profitiert keiner davon. ergo keine zielgruppe.

VJoe2max;431195 said:

‘[LE said:

Al_bundy;431165′]

Dann noch ein paar zeilen zu der core geschichte.

das fängt beim wärmeübergang fet core an, geht hin zu massiven kupfer, zu einen weiteren wärmeübergang core ihs, insbesondere deren fläche des DIE. umso größer die fläche des DIE desto mehr wärmenergie kann kann an den IHS abgegeben werden. hast du jetzt 30% weniger fläche am DIE, kommt defakto physikalus nicht so viel wärme zum ihs, was hier entweder als nichtig betrachtet wird, oder nicht bedacht wurde. isolierung hin oder her, das is ganz lustig, aber alles andere ist einer realen cpu, was den verlust der wärmeenergie zwischen erzeugungsort der wärmenergie und abgabeort der wärmenergie angeht, meilenweit unterlegen 😉Was soll man dazu sagen? Das ist ja peinlich, was du da von dir gibst.

Du hast da ganz offensichtlich noch einiges grundlegend nicht verstanden. Auf diesem Wissensniveau lohnt es sich hier wirklich nicht weiter zu diskutieren. Tut mir Leid, aber auf solche Albernheiten hab ich wirklich keine Lust.

Dir fehlen offensichtlich immer noch einfachste Grundlagen wie die Hauptsätze der Thermodynamik. Es verlangt ja niemand dass du die zugehörigen Formeln kennst oder die Definitionen aufsagen kannst, aber das was sie aussagen sollte jemandem der Wasserkühler baut und testet schon geläufig sein und er sollte auch die Konsequenzen dessen begreifen.

Hast du oben bei der Antwort auf ulvs Posting nur zugestimmt, weil du es nicht verstanden hast? Energie geht nicht verloren – nirgends und niemals. Ich habe das Wort Leistungsdichte hier im Verlauf mehrmals genutzt. Es scheint du hast nicht mal verstanden was das bedeutet.

Ich muss wirklich sagen – es tut mir fast weh, so über dich reden zu müssen, denn du machtest mir in letzter Zeit eigentlich den Eindruck, als ob du bezüglich der thermodynamsichen Grundlagen etwas dazu gelernt hättest. Erinnere dich z.B. auch an unsere Diskussionen zur Bedeutung der Reynoldszahl. Ich habe mich schon gefreut, dass die Nachhilfe diesbezüglich offenbar gefruchtet hatte, als ich auf deiner Shopseite irgendwann die Worte laminar und turbulent endlich im richtigen Zusammenhang lesen durfte. Offenbar habe ich mich aber wohl getäuscht…

Dabei habe ich dir extra viel Zeit gelassen das hier ^ zu korrigieren – hätte ja sein können, dass du die letzten Zeilen des Beitrags irgendwie halb abwesend oder mit was anderem beschäftigt geschrieben hast.Schreib mir ne PN – dann lösche ich den letzten Absatz deines Beitrags und das Zitat hier. Das ist doch nur peinlich für dich als Prüfstand-Betreiber und Kühler Hersteller.

PS: Das mag sich jetzt etwas hart für dich anhören, aber tu mir den Gefallen – werde nicht ausfallend, falls du darauf antworten möchtest. Ich sag das nur vorsichtshalber, weil ich ja schon öfters das zweifelhafte Vergnügen hatte in solchen Situationen und ich weiß, dass du gern angepi**t reagierst, wenn du Kritik einstecken musst. Du tust dir aber keinen Gefallen damit ;).

meinetwegen mach ich dazu auch ne messung und stelle dir die auswertung vor.

-

14. Oktober 2010 um 23:10 Uhr #866314

AMD-ATI-Fan

TeilnehmerDann noch ein paar zeilen zu der core geschichte.das fängt beim wärmeübergang fet core an, geht hin zu massiven kupfer, zu einen weiteren wärmeübergang core ihs, insbesondere deren fläche des DIE. umso größer die fläche des DIE desto mehr wärmenergie kann kann an den IHS abgegeben werden. hast du jetzt 30% weniger fläche am DIE, kommt defakto physikalus nicht so viel wärme zum ihs, was hier entweder als nichtig betrachtet wird, oder nicht bedacht wurde. isolierung hin oder her, das is ganz lustig, aber alles andere ist einer realen cpu, was den verlust der wärmeenergie zwischen erzeugungsort der wärmenergie und abgabeort der wärmenergie angeht, meilenweit unterlegen 😉

hä? das ist doch bei einer normalen CPU nicht anderst als beim Teststand: der DIE ist wesentlich kleiner als der IHS!und es geht nicht darum, dass die MKler zu faul zum wechseln währen

leienhaft geschrieben liest sich der erste teil so, als ob ihr eure eigene umgebung schafft und die bestehenden setups (intel und amd) ignoriert, nicht nur weil es unwichtig ist zu differenzieren sondern auch da der aufwand zu groß wäre einmal pro jahr, oder spätestens 1x in 2 jahren einen neuen core zu installieren?!

wenn man jedes Jahr den kompletten heiz-Teil ersetzt ist das nicht nur Kostenaufwändig, sondern man müsste auch alle vorher getesteten Kühler nochmals testen, um vergleichbare Ergebnisse zu liefern 😉

-

14. Oktober 2010 um 23:10 Uhr #866319

Oma-Hans

TeilnehmerAMD-ATI-Fan;431194 said:

…sondern man müsste auch alle vorher getesteten Kühler nochmals testen, um vergleichbare Ergebnisse zu liefern 😉Richtig. Daher sollte der Teststand meiner Meinung nach für einen gewissen Zeitraum mit einem gewisser DIE-Fläche (sei sie jetzt gemittelten, hochgerechnet, geschätzt, willkürlich gewählt; spielt keine Rolle) und def. Heizleistung ausgestattet bleiben um die Tests nicht zu verzerren. Mindestens 2 Jahre sind da in meinen Augen sinnvoll.Die Wechselintervalle richten sich eben nach dem Zweck. Will man dem User die Möglichkeit bieten auf aktuellen Kernen gegen ein paar Kaufkühler anzutretenoder will man eine Plattform bieten auf der er sich mit Bastelkonkurenten und Herstellern messen kann.Wenn ich als kleiner Kühlerbastler meinen Kühler testen lass, dann will ich nach einem Jahr immernoch wissen wo man Kühler im Vergleich zu den anderen steht. Sobald auf einen anderen DIE oder Heizelement umgestiegen wird sind die alten Messwerte hinfällig, denn ich glaub nicht dass die Hobbyisten bei jedem Wechsel ihren Kühler auf ein Neues einschicken wollen. Wieviele Bastelkühler kommen denn im Jahr rein? 5, 6? 10 wenns hochkommt? Würde ein etwas mageres Ranking geben wenn man nach einem Jahr auf einen neuen DIE umsteigt.Man bräuchte also fast zwei Teststände… :+ ;)Gute Nacht, Jens

-

14. Oktober 2010 um 23:10 Uhr #866315

VJoe2max

Teilnehmer‘[LE said:

Al_bundy;431165′]leienhaft geschrieben liest sich der erste teil so, als ob ihr eure eigene umgebung schafft und die bestehenden setups (intel und amd) ignoriert, nicht nur weil es unwichtig ist zu differenzieren sondern auch da der aufwand zu groß wäre einmal pro jahr, oder spätestens 1x in 2 jahren einen neuen core zu installieren?!Du kennst den WCP-Prüfstand nicht wahr? Und jetzt überleg mal wie das dort ablief ;). In ähnlicher Art und Weise wollen wir das auch machen. Die bestehenden DIE-Layouts von Intel und AMD sind überaus unterschiedlich es gibt x verschiedene Kerne auf dem Markt die sich in den Rechnern dieser Welt unter einer Wakü wiederfinden. Was hilft es einem User mit, sagen wir einem Gulftown-User, wenn du ein DIE-Sim einsetzt dass den Bloomfieldkern möglichst exakt abbildet, oder – noch extremer – einem Deneb-User wenn du einen Thuban-Kern simulierst. Erkennst du die Problematik? Derlei Kombinationen gibt es noch weit mehr und mit weit unterschiedlicheren DIE-Flächen. Kein Kühlertester der Welt würde auf die Idee kommen alle abzubilden. Nehmen wir also an du entscheidest dich für ein DIE-Sim, welches den Bloomfield-Kern abbildet (afaik hast du das ja getan). So schließt du nach deiner CPU-spezifischen Herangehensweise erst mal alle User mit CPUs aus die andere Kerne nutzen. Zumindest bietest du für diese User weniger brauchbare Ergebnisse an als für die Bloomfiel-Nutzer. Du bietest also effektiv, egal für welchen Kern du dich entscheidest, grundsätzlich für die überwiegende Mehrheit der Wakü User Ergebnisse die für deren CPUs wenig bis sehr wenig Aussagekraft haben. Lediglich die Nutzer des Kern für den du dich entschieden hast profitieren davon 😉 (sofern man das so sagen kann – ein Prüfstand ist wie gesagt keine CPU).Unser Ansatz ist ein anderer. Wir testen mit einer DIE-Fläche die real so in keinem Kern bzw. nur annähernd bei einigen Kernen vorkommt. Im Mittel stimmt die Leistungsdichte die wir damit erzeugen aber besser mit einer größeren Anzahl an Kernen überein, als dein Bloomfield-DIE-Sim. Zudem ist es wie gesagt relativ egal auf welche Referenzfläche man sich bezieht (wenn sie nicht völlig unrealistisch für eine CPU ist), solange es darum geht heraus zu finden welche Kühltechnik eine besonders hohe Kühlwirkung erzeugt. Unser Kompromiss bei der Kühlfläche soll genau dem Rechnung tragen. Das Ranking was sich durch dieses Vorgehen ergibt, zum Einen ein klares Bild über den Einfluss der Kühltechnik auf die Kühlleistung an sich, und zum Anderen ergibt es für eine weit größere Zahl an DIEs ein Kühler-Ranking welches der Realität besser gerecht werden sollte als das Kühleranking was für einen bestimmten Kern optimiert ist. Von so einem Ranking wie bei dir profitiert genau genommen ja nur ein kleiner Bruchteil der User. Von einem Ranking wie es mit einem Kompromiss wie dem unseren zu erwarten ist, profitieren viel mehr User in ähnlicher Weise. Da wir bei unseren Ergebnissen aber auch die Standardabweichungen in unseren Auswertebögen angeben können, wissen wir auch, und so hoffen wir auch die Profiteure unserer Tests, dass die Jagd nach dem letzten Zehntel-Grad schlicht sinnlos ist. Die Standardabweichungen sind natürlich um Längen besser ist als jede Messung auf echter Hardware. Das wissen zumindest alle die sich mit dem Thema CPU-Sensoren etwas eingehender befasst haben, nur zu gut :fresse:. Und das gilt wohlgemerkt bei ansonsten völlig einwandfreier Kalibrierung gegen Präzisionsthermometer. Im Übrigen auch für deinen Prüfstand ;).Wenn man eine komplette Fehlerrechnung anhängt müsste man auch noch die Genauigkeit des Kalibrierinstruments einbeziehen, aber das macht nicht viel aus. Wollte man tatsächlich an die viel beschworenen Zehntel-Grade heran kommen, müsste man jede Messung viele Male komplett wiederholen. Um sich an den Mittelwert besser heran zu pirschen. Schon bei 150W Heizleistung dauert aber allein das das erreichen des stationären Zustands ca. 20 min – hinzu kommt die Messzeit im stationären Zustand.Alles in allem dauert die Messung eines Kühlers nach unserer Prozedur mit drei Durchflussstufen Netto vier Stunden. Effektiv noch deutlich länger (inkl. Aufbau, Abbau und Auswertung). Es muss also ein Testlauf pro Durchflussstsufe reichen. Deshalb haben wir so lange an der Messgenauigkeit und der Kalibrierung geschraubt, bis wir einen Stand erreicht haben, bei dem wir sagen können, dass die Ergebnisse so genau wie möglich und auch sehr gut reproduzierbar sind. Einem Ranking im Sinne der technisch besten Kühlleistung steht so nicht viel im Wege, auch wenn im Laufe der Zeit mit Sicherheit einige Kühler auf gleichem Niveau liegen werden, wenn man die Standardabweichungen beachtet ;). In deinem letzten Kühler-Roudup lagen, gutmütig geschätzt, auch mindestens fünf Kühler auf gleichem Niveau an der Spitze ;). Hast du mal die Standardabweichungen deiner Messungen ausgewertet?

‘[LE said:

Al_bundy;431165′]Dieser Satz passt nicht zur folgenden aussage”Im Übrigen zeigen die ersten Ergebnisse auch bereits wie unwichtig die Frage nach dem absolut besten Kühler für eine bestimmte CPU tatsächlich ist, wenn es nicht um die Jagd nach dem letzten Viertel-Grad geht, sondern einfach nur um gute Kühlung.und wollen versuchen, damit vor allem Kühlerbastlern vernünftige Grundlagen an die Hand zu geben, indem wir versuchen die besten Prinzipien die zu besonders guten Kühlleistungen führen Stück für Stück heraus zu arbeiten. “mit verstand kann man da nicht schreiben.So so – ohne Verstand erst recht nicht 😉 :D. Welches Kühlprinzip das Beste ist ergibt sich daraus wie gut Kühler mit einer bestimmten Kühltechnik abschneiden. Was genau der Grund ist muss in Diskussionen geklärt werden die sich auf die Grundlage der Tests stützen können. Es bleibt zu hoffen, das sich die Erkenntnisse nutzbringend umsetzen lassen. Nur so kann man in dem Bereich weiter kommen ;). Die Jagd nach dem letzten Viertel-Grad ist eine Spielwiese auf der sich schon genügend andere austoben – aber das hat aber eben nicht viel mit realen Unterschieden zu tun sondern her mit Marketing und der Leichtgläubigkeit vieler Nutzer. Siehe oben ^ ^

‘[LE said:

Al_bundy;431165′]denn es macht faktisch keinen sinn ob die cpu 50 oder 55°C hat.Das ist effektiv egal – da hast du recht ;).

‘[LE said:

Al_bundy;431165′]dennoch gibt es die typen die aufs zehntel grad aussind. und davon gibt es nicht zu wenig, insbesondere bei den kühlerbastlern mit viel ergeiz. da darf man sich nicht die frage nach sinn oder unsinn stellen. die typen sind da, und die wollen auch bedient werden. und die typen die auf testständen testen lassen wollen, erwarten das auch.Die Anzahl ambitionierter Bastlerprojekte die ernsthaft darauf aus sind die kommerzielle Konkurrenz zu schlagen überschätzt du glaub ich ein klein wenig ;). Die kann man vermutlich an zwei Händen abzählen. Nichts desto trotz können gerade die besonders von genauen Ergebnissen profitieren wie wir die zu den jeweiligen Probanden liefern können. Die “Typen” sind unter anderen unsere geschätzten MK-User und wir können sie nun mit fundierten Messungen “bedienen” ;).

‘[LE said:

Al_bundy;431165′]anders als bei hobbybastlern die mit dremel und lötlampe arbeiten. die ermitteln das zu hause an ihre eigene cpu und freuen sich ergänzend auf werte eines teststandes so wie wir sie haben.Auch solche Kühler lohnt es sich mal unter dir Lupe zu nehmen. Nicht jeder will gleich in die Oberliga einsteigen, aber um seinen Kühler zu verbessern sind vernünftigen Testwerte und eine Platzierung in den Kühlerchart´s für Bastlerkühler sicher aufschlussreich und vllt. auch ein Ansporn. So ist es zumindest gedacht ;).

‘[LE said:

Al_bundy;431165′]wenn es nur darum geht:”und wollen versuchen, damit vor allem Kühlerbastlern vernünftige Grundlagen an die Hand zu geben, indem wir versuchen die besten Prinzipien die zu besonders guten Kühlleistungen führen Stück für Stück heraus zu arbeiten. “dann hätte es ein Crosshair 4 und ein 1055T auch getan. und man hätte sich nicht den kritischen aussagen stellen müssen, ” völligrealitätsfremd” was auch nur bedingt stimmt und zugelassen werden kann.Warum so ein aggressiver Tonfall? Wir stellen uns, wie du vllt. gemerkt hast, sehr gern deinen kritischen Äußerungen ;). Nein – ein Test auf Hardware ist dafür völlig unsinnig. Mal abgesehen von dem besonders schlechten Vorschlag gerade diese CPU dafür zu verwenden. Abgesehen davon wäre es äußerst verwegen anzunehmen, dass man so auch in ein paar Jahren noch Vergleiche anstellen könnte. Diese Art Kasperle-Theater brauchen wir nicht in einer ernsthaften Diskussion über den Prüfstand. Ich führe das jetzt aber nicht weiter aus – die Nachteile von Hardwaremessungen wurden schon ausführlich genug besprochen. Wenn du keine vernünftigen Vorschläge hast, wäre es vllt. besser nichts zu sagen ;).

-

15. Oktober 2010 um 0:10 Uhr #866323

VJoe2max

Teilnehmer@Jens: Wie bei WCP früher eben ;). Wenn man sich den Ansatz anschaut nach dem wir uns für die DIE-Fläche entschieden haben, ist es, wie die die Erfahrung über inzwischen viele Jahre zeigt eigentlich überhaupt nicht nötig die Fläche zu ändern. Die mittleren DIE-Größen haben über die letzten Jahren nur wenig geschwankt. Natürlich gab es immer mal wieder einen besonders großen Chip oder auch mal eine besonders kleinen, aber im Wesentlichen wurden die Kerne seit P4 und AthlonXP-Zeiten im Schnitt nicht sehr viel größer (ein bisschen größer wurden sie aber nicht viel). Seit es MultiCores gibt, streut die Chipgröße über die inzwischen recht unüberschaubare Kernflut recht stark, aber außer den anfänglich verwendeten packages mit zwei Einzelkernen war da entgeltlich nichts dabei was eine Änderungen der mittleren DIE-Größe bei einem Simulator mit sich hätte zwangsweise bringen müssen. @Audidude: Und genau auf diese Zielgruppe ist der Prüfstand ausgerichtet. Es ist ein MK-Prüfstand und nicht ein x-beliebiger Prüfstand der versucht die Ergebnisse anderer zu imitieren oder reale Prozessoren abzubilden – davon gibt es schon einige (teilweise wirklich keine schlechten – da gehört imo auch Marcs bisheriger Prüfstand dazu). Wir haben, wie auch in der Doku beschreiben, lediglich versucht die für unsere Zielsetzung am besten erscheinenden Methoden zu kombinieren und bei Bedarf zu optimieren. An vielen Stellen haben wir uns dann eben selber was einfallen lassen und es so gelöst, dass wir es am Ende für gut befinden konnten. Das war im Prinzip ja schon Bisons Ansatz zu Beginn des Projekts und ich denke wir haben es, wenn auch ein wenig schleppend, zu einem brauchbaren Ergebnis gebracht. @Marc: Hast ne PN ;).Edit: Wenn du wirklich messen willst – mach den Versuch einmal mit nacktem DIE-Sim und einmal mit sauber isoliertem DIE-Sim. Du wirst erstaunt sein ;).

-

15. Oktober 2010 um 0:10 Uhr #866322

Audiodude

TeilnehmerEine gleichbleibende Die Fläche finde ich auch wesentlich besser als die “Korinthenkackerei” mit der ewigen Anpassung (sorry aber das musste mal gesagt werden). Ich denke das in diesem Forum nicht unbedingt die User vertreten sind die sich um Zehntel Grad sorgen machen. Wichtig sind mir z.B. grundsätzliche Unterschiede und eine lange Vergleichbarkeit.

Greetz Audiodude

-

15. Oktober 2010 um 10:10 Uhr #866289

[LE]Al_bundy

Teilnehmermal etwas grundsätzliches.

mir ist es egal wie bei mk getestet wird. auch gibt es einige leute die theoretische sehr viel ahnung haben sowie den einen oder anderen der praktisch schon einige tests absolviert hat. für das wofür sie sich entschieden haben gibt es in ihren augen gute gründe….…

es genügt wenn man mit einen DIESIM testet. ob nun CPUreal angelehnt oder via leistungsdichte orientiert spielt keine rolle um aussagekräftige ergebnisse für einen kühler zu bekommen.

man muss aber damit rechnen, das wenn ein Core getauscht wird, und man nochmal alle kühler testen würde, das dann die zuvor ermittelten rankings unter umständen nicht mehr reproduzierbar mit den neuen Core sind. was auch tatsächlich so ist, und was joe auch eingeräumt hat.aber wenn man das schon macht, und auch die möglichkeit hat, dann finde ich es besser etwas konkretes was es real auch gibt herzunehmen, anstatt mich anhand der leistungsdichte zu orientieren mit Core abmessungen die es gar nicht gibt.

wie gesagt ist das nicht kriegsentscheident. aber es so dastehen zu lassen und zu sagen es geht uns nix an. wir haben ne leistungsdichte und damit hat sichs. besagt nur aus, ” egal was intel oder amd hat, wir liegen inne mitte und sind glücklich.

auf gut deutsch hast das nur. das ihr jeden, und gar keine als zielgruppe habt. jeden, da ihr euch der leistungsdichte angelehnt habt, aber niemanden, weil es niemanden gibt der seinen kühler auf diese core dimensinen betreibt. wenn man sich etwas existierendes herausgesucht hätte, hätte man zumindest speziell einen sektor vollständig abgedeckt. -

15. Oktober 2010 um 10:10 Uhr #866350

littledevil

TeilnehmerMit wieviel verschiedenen CPU’s müsste man Deiner Meinung nach alle Test aktuell wierholen, um alle glücklich zu machen ❓

-

15. Oktober 2010 um 10:10 Uhr #866348

[LE]Al_bundy

Teilnehmerfrank hat sein teststand alle 2 jahre geupdatet. das ist auch gar nicht so abwägig wie ich vorgeschlagen habe sowie wie jens das auch angesprochen hat. wo ist also das problem…

es muss nunmal nicht unbedingt reichen sich an der leistungsdichte zu orientieren. was mein test aufzeigen wird. DIE größe von 12x16mm und DIE größe von 16x24mm machen einen unterschied. insbesondore wenn auch noch mit unterschiedlich dicken Cores ( 10mm Vs 5mm) gemessen wird. wäre ich jetzt zu hause hätte ich auch auch ne simmi der wärmeverteilung sowie was kommt wann wo an zeigen können… -

15. Oktober 2010 um 11:10 Uhr #866353

ulv

Teilnehmer‘[LE said:

Al_bundy;431236′]

… es genügt wenn man mit einen DIESIM testet. ob nun CPUreal angelehnt oder via leistungsdichte orientiert spielt keine rolle um aussagekräftige ergebnisse für einen kühler zu bekommen.

man muss aber damit rechnen, das wenn ein Core getauscht wird, und man nochmal alle kühler testen würde, das dann die zuvor ermittelten rankings unter umständen nicht mehr reproduzierbar mit den neuen Core sind. was auch tatsächlich so ist, und was joe auch eingeräumt hat.aber wenn man das schon macht, und auch die möglichkeit hat, dann finde ich es besser etwas konkretes was es real auch gibt herzunehmen, anstatt mich anhand der leistungsdichte zu orientieren mit Core abmessungen die es gar nicht gibt.

wie gesagt ist das nicht kriegsentscheident. aber es so dastehen zu lassen und zu sagen es geht uns nix an. wir haben ne leistungsdichte und damit hat sichs. besagt nur aus, ” egal was intel oder amd hat, wir liegen inne mitte und sind glücklich.

auf gut deutsch hast das nur. das ihr jeden, und gar keine als zielgruppe habt. jeden, da ihr euch der leistungsdichte angelehnt habt, aber niemanden, weil es niemanden gibt der seinen kühler auf diese core dimensinen betreibt. wenn man sich etwas existierendes herausgesucht hätte, hätte man zumindest speziell einen sektor vollständig abgedeckt.Ich kann das nur nochmal untersteichen:

Du bist der Meinung, dass man das DIE-Sim an einer realen Fläche eines Cores festmachen soll. <- Das versteh ich gut. Fände ich auch Sinnvoll. :d: Wir sind anderer Meinung und haben wie du selbst schreibst ebenfalls gute Gründe. Das was ich jetzt schreibe soll dich nicht von deiner Meinung abbringen, aber für mich gilt dennoch: - Idealerweise müsste man verschiedene DIE-Sims haben. -> Für uns ist der Aufwand dann aber zumindest im Moment zu groß.

– Auch wenn man ein Original-Die verwendet hat man streng genommen – zugegebenermaßen sehr streng genommen – auch keine Zielgruppe, weil da gibt es noch verschiedene Steppings, verschiedene Last (single, multicore), verschiedene VCore, verschiende Sockelhersteller, verschiedene Mainboards, verschiedene Kühlerbefestigungen (insbesondere auf der Mainboard-Rückseite) und und und nicht zu vergessen nicht alle User verbraten genau 150 Watt. 😉

Uns sind diese Limitationen durchaus klar. Und Dir natürlich auch.Wir haben uns jetzt halt so entschieden und ehrlich gesagt bringen uns wenn überhaupt nur stichhaltige Messungen von dir eventuell davon ab.

Selbst wenn wir die Zeit und auch die unterschiedlichen DIE-SIMs alle hier liegen hätten wage ich mal zu sagen wir würden dennoch lieber noch einen zusätzlichen Durchfluß-Level testen bevor wir das DIE-SIM wechseln würden.

Ich will dich nicht umstimmen, ganz im Gegenteil ich freue mich sogar auf deine Ergebnisse. Insbesondere den Teil, den du mit deinen unterschiedlichen DIEs messen wirst.

-

15. Oktober 2010 um 11:10 Uhr #866317

VJoe2max

Teilnehmer‘[LE said:

Al_bundy;431236′]mal etwas grundsätzliches.mir ist es egal wie bei mk getestet wird. auch gibt es einige leute die theoretische sehr viel ahnung haben sowie den einen oder anderen der praktisch schon einige tests absolviert hat. für das wofür sie sich entschieden haben gibt es in ihren augen gute gründe….Sehr gut :). Dann sind wir da ja auf einer Wellenlänge :d:.Wir haben ebenfalls kein Problem damit wie du und andere testen. Das machte jeder Prüfstandsbetreiber am besten so wie er es für vernünftig erachtet. Wenn klar ist was mit der jeweiligen Methodik bezweckt wird und warum man sich so oder so entschieden hat, kann auch jeder Nutzer die jeweiligen Ergebnisse für sich am nutzbringendsten interpretieren.

‘[LE said:

Al_bundy;431236′]…es genügt wenn man mit einen DIESIM testet. ob nun CPUreal angelehnt oder via leistungsdichte orientiert spielt keine rolle um aussagekräftige ergebnisse für einen kühler zu bekommen.man muss aber damit rechnen, das wenn ein Core getauscht wird, und man nochmal alle kühler testen würde, das dann die zuvor ermittelten rankings unter umständen nicht mehr reproduzierbar mit den neuen Core sind. was auch tatsächlich so ist, und was joe auch eingeräumt hat.Absolut einverstanden ;).

‘[LE said:

Al_bundy;431236′]aber wenn man das schon macht, und auch die möglichkeit hat, dann finde ich es besser etwas konkretes was es real auch gibt herzunehmen, anstatt mich anhand der leistungsdichte zu orientieren mit Core abmessungen die es gar nicht gibt.Diese Ansicht sei dir unbenommen und ich denke es gibt sicher auch eine große Gruppe von Leuten die das ähnlich sehen wie du. Es gibt aber ebenso viele User die andere Prioritäten bei physikalischen Prüfständen setzen. Diese User wollen wir ansprechen.

‘[LE said:

Al_bundy;431236′]wie gesagt ist das nicht kriegsentscheident. aber es so dastehen zu lassen und zu sagen es geht uns nix an. wir haben ne leistungsdichte und damit hat sichs. besagt nur aus, ” egal was intel oder amd hat, wir liegen inne mitte und sind glücklich.auf gut deutsch hast das nur. das ihr jeden, und gar keine als zielgruppe habt. jeden, da ihr euch der leistungsdichte angelehnt habt, aber niemanden, weil es niemanden gibt der seinen kühler auf diese core dimensinen betreibt. wenn man sich etwas existierendes herausgesucht hätte, hätte man zumindest speziell einen sektor vollständig abgedeckt.Da gebe ich dir ebenfalls recht. Es ist absolut nicht ausschlaggebend, sondern es sind lediglich Spielarten die jeweils auf eine bestimmte Zielsetzung hin genutzt werden können. Aber wie gesagt: Auch ein DIE-Sim mit den exakten Abmessungen einer realen CPU ist eben keine reale CPU. Mit diesem Umstand muss man so oder so leben. Man kann damit aber viel besser und vor allem genauer messen als mit jeder realen CPU und hat gegenüber einen realen Setup eine weit bessere Reproduzierbarkeit, wenn der Aufbau stimmt. Das sind mit die Hauptgründe, warum man Ergebnissen physikalischer Prüfstände, was die tatsächlichen Unterschiede zwischen Kühlern angeht, wesentlich mehr vertrauen kann als Hardwaretests jeder Art – ganz unabhängig davon welches DIE-Sim nun verwendet wird. Letztendlich sind die Rankings die man mit Kühlertests egal welcher Machart erhält aber nie zu 100% auf ein System beim Enduser übertragbar. Dennoch zeigt so ein Ranking eben die prinzipiellen Leistungsunterschiede sehr gut auf, und darum geht es uns primär ;). Letztlich zeigt sich das aber natürlich auch auf der Mehrheit aller realen Systeme. Bei extremen CPU-Kern-Größen (kleine wie große) oder Kernen mit besonders hohem Aspektverhältnis wird es immer zu leichten Verschiebungen der Rankings kommen. An der grundsätzlichen Leitungsfähigkeit eines Kühlers ändert das aber wenig. Es wäre im Übrigen auch unklug von den Herstellern, wenn man die Kühler auf ein bestimmtes DIE-Layout hin optimieren würde, wo doch die Produktlebenszyklen von Kühlern in aller Regel die von CPUs bei weitem übersteigen und sich auch immer nur ein sehr kleiner Abnehmerkreis finden würde. Etwas anderes sind Kühlerdesigns, die z.B. durch verschiedene Düsenplatten oder ähnliche Optionen in gewissen Grenzen an verschiedene Kühlbedingungen angepasst werden können….Auf einer Vielzahl von CPUs sollten die Rankings die wir mit der MK-Prüfstation erstellen können demnach sehr gut übertragbar sein. Insbesondere wenn die reale Abgabefläche des CPU-Kerns der DIE-Sim-Fläche und Geometrie recht ähnlich wie ist – was für eine Vielzahl von CPUs zutrifft. So ist zumindest unser Kalkül. Bei der Simulation einer realen CPU kommt es hingegen darauf an, für was sich der Tester entschieden hat, ob die Ergebnisse für ein reales Setup mit anderer CPU einigermaßen brauchbar sind oder eben relativ weit weg von den realen Gegebenheiten.

-

15. Oktober 2010 um 11:10 Uhr #866354

[LE]Al_bundy

Teilnehmeraufgrund des einen unterschiedlich entstehenden hotspots des Cores oberhalb des ihs, in verbindung mit zweier unterschidlich großen DIEflächen ( beispielsweise 12x16mm und 24x16mm)

kann man dann leider nicht mehr sagen.” An der grundsätzlichen Leitungsfähigkeit eines Kühlers ändert das aber wenig”

insbesondere wie ich oben schon erwähnt habe, was du ja ebenfalls einräumst

“Bei extremen CPU-Kern-Größen (kleine wie große) oder Kerne mit besonders hohem Aspektverhältnis wird es immer zu leichten Verschiebungen der Rankings kommen.”

das steht in direkten zusammenhang und somit ist das ein wiederspruch. aktuelles beispiel Phobya cpu kühler. das es diese differenz gibt ist durch tests also faktisch belegt. auch wenn diese tests auf cpu durchgeführt wurden.

€dit:

auf unterschiedlichen DIEsims zutesten istnachvollziehbar zuviel arbeit und wird wohl auch niemand tun sofern er dafür nicht dementsprechend bezahlt wird. das ist einfach zuviel aufwand der auch nur einen extrem minimalen nutzen aufweist. hinzu macht das wie erwähnt auch nur sinn bei extremos. -

15. Oktober 2010 um 12:10 Uhr #866358

littledevil

TeilnehmerUnd wer garantiert, das die Temperatursensoren der einzelnen CPU’s aussagekräftige werte liefern?

Bei der Verwendung verschiedener Die-Sims müsste man also auch noch mit mehreren Sensoren für die einzelnen Kernbereiche arbeiten.

-

15. Oktober 2010 um 13:10 Uhr #866360

[LE]Al_bundy

Teilnehmerlol

niemand. es sind annäherungswerte. genau wie simulationen nur annäherungswerte sind. aber, beides wird sich desöfteren mit werten eines teststandes decken. somit können diese als vergleiche hergenommen werden, auch wenn diese nicht wirklich soviel gewicht haben wie werte eines teststandes. -

15. Oktober 2010 um 13:10 Uhr #866361

littledevil

TeilnehmerDiese Aussage hat dann wohl keinen Wert:

aktuelles beispiel Phobya cpu kühler. das es diese differenz gibt ist durch tests also faktisch belegt.

-

15. Oktober 2010 um 13:10 Uhr #866363

[LE]Al_bundy

Teilnehmerdoch^^

-

15. Oktober 2010 um 14:10 Uhr #866371

VJoe2max

Teilnehmer@Marc: Hast ne PN

‘[LE said:

Al_bundy;431240′]

” An der grundsätzlichen Leitungsfähigkeit eines Kühlers ändert das aber wenig”insbesondere wie ich oben schon erwähnt habe, was du ja ebenfalls einräumst

“Bei extremen CPU-Kern-Größen (kleine wie große) oder Kerne mit besonders hohem Aspektverhältnis wird es immer zu leichten Verschiebungen der Rankings kommen.”

das steht in direkten zusammenhang und somit ist das ein wiederspruch. aktuelles beispiel Phobya cpu kühler. das es diese differenz gibt ist durch tests also faktisch belegt. auch wenn diese tests auf cpu durchgeführt wurden.

Da ist kein Widerspruch ;). Die generelle/grundsätzliche/durchschnittliche Leistungsfähigkeit eines Kühlers im Vergleich zu anderen Kühlern bestimmt sich nach seiner durchschnittlichen Kühlleistung auf allen in Frage kommenden CPUs im Vergleich zu anderen Kühlern.

Da das nicht gemessen werden kann, messen wir auf einer durchschnittlichen DIE-Fläche und erhalten so ein Ranking, welches diese Leistungsfähigkeit von Kühlern unterschiedlicher Bauart hoffentlich gut zeigt.Dass auf einer CPU mit einem DIE, dessen Fläche und Form stark vom Durchschnitt abweicht, ein Kühler der im Ranking knapp hinter einem anderen liegt, u.U. ein Quäntchen besser auf dieser CPU performt ist möglich.

Dass aber ein Kühler der im Ranking fernab von gut und Böse liegt, auf einem anderen DIE-Sim oder auch einer andern realen CPU plötzlich die Leistungsspitze übernimmt ist so gut wie ausgeschlossen. So große Unterschiede gibt es zwischen den DIEs nun auch wieder nicht und erst recht keine so speziell angepassten Kühler.

Das der Phobya-Kühler auf bestimmten CPUs besser kühlt als auf anderen ist ja eine schöne Praxiserfahrung, die man mit verschiedenen DIE-Sims auch auf einem Prüfstand vllt. nachstellen kann, aber an seiner durchschnittlichen Leitungsfähigkeit ändert das dennoch nichts ;).

-

15. Oktober 2010 um 14:10 Uhr #866376

Neptun

ModeratorVJoe2max;431257 said:

@Marc: Hast ne PN

.kein kummeln hinter der Bühne .. ich will auch wissen, was in der PN stand 😉

-

15. Oktober 2010 um 14:10 Uhr #866372

[LE]Al_bundy

Teilnehmerdann sollte man das auch schreiben was womöglich vergessen wurde.

wenn cpu und brett keine aussagekraft hätten was defakto nicht der fall ist, würden diese rankings deutlich anders aussehen als rankings mit kühlertestständen. was nicht der fall ist. -

15. Oktober 2010 um 23:10 Uhr #866440

orw.Anonymous

TeilnehmerNeptun;431262 said:

VJoe2max;431257 said:

@Marc: Hast ne PN

.kein kummeln hinter der Bühne .. ich will auch wissen, was in der PN stand 😉

Ich hingegen nicht.

Gut, mit diesem Dummfug nicht mehr zu tun haben zu müssen. Der vermeintlich unerklärliche verfrühte Abgang eines Ehemaligen aus dem Bereich Hannover macht inzwischen Sinn.Da probiert das Trampeltier doch lieber den 5. Anflug auf Salzburg, ohne Absturz. 🙂

Wünsche euch das Beste ❗

-

18. Oktober 2010 um 14:10 Uhr #866756

[LE]Al_bundy

TeilnehmerAnbei die Simmis…

Alle Teile haben Werkstoffe zugewiesen bekommen. Schichtdicke der WLP sowie die Schichtdicke der Lötschicht habe ich bei 3/100mm belassen. die isolierung nach außenhin beträgt 11.5mm

Alle Simmis basieren auf den selben Setup. Einzig der Core wurde gegen einen dünneren, bzw einen mit anderer DIEFläche getauscht. Darüber hinaus gibt es eine Simmi ohne Isolierung.

Man kann erkennen das es durchaus Unterschiede gibt wie groß die DIEfläche ist. Hingegen eines dünneren Cores gibt es kaum Unterschiede, wobei man erwähnen muss das das meiste nur in den ersten 1-2mm passiert (am IHS). Daraufhin sind bei einen 4.8mm und 9.8mm Core kaum Unterschiede Sichtbar, hingegen einer CPU und den hier verwendeten Cores jedoch schon.

Jeder kann sich jetzt sein eigenes Bild machen und die Simmibilder deuten.

Um es deutlicher erkennbar zu machen pro Simmi 2 Temperaturbereiche.Hier mal die Bilder

http://www.liquid-extasy.de/files/auswertung/diesim/diesim.pngTemperaturbereich 298-308K

http://www.liquid-extasy.de/files/auswertung/298_308/9.8vs4.8.jpg

http://www.liquid-extasy.de/files/auswertung/298_308/24x16_non_iso_vs_iso.jpgTemperaturbereich 299-304K

http://www.liquid-extasy.de/files/auswertung/299_304/9.8vs4.8_2.jpg

http://www.liquid-extasy.de/files/auswertung/299_304/24x16_non_iso_vs_iso_2.jpgselbiges ergebnis wird in den praxistests auch rauskommen die ich später dann noch machen werde. somit sind einige thesen wiederlegt und es können neue schlussfolgerungen entstehen.

-

18. Oktober 2010 um 16:10 Uhr #866764

VJoe2max

Teilnehmer@Jürgen: Viel Spaß in den virtuellen Lüften und danke für die guten Wünsche ;). Was deinen Abgang angeht, bewertest du den Überraschungseffekt und die Wahl des Zeitpunkts glaub ich etwas über ;). @Marc: Schön, das du dir die Mühe mit den Simulationen gemacht hast! Die Bilder zeigen eigentlich recht gut alles was ich oben schon gesagt habe. Nur beim Einfluss der Isolation ist der Ansatz imho noch nicht so ganz ausgereift. Da müsste mehr zu sehen sein…Bei unterschiedlicher DIE-Fläche ändert sich selbstverständlich die Leistungsdichte und damit die Temperaturverteilung – das war nicht anders zu erwarten und wird schön verdeutlicht (wenn auch an etwas übertriebenen Beispielen, wenn die Flächenangaben unter den Bildern stimmen). Dass unterschiedliche Flächen unterschiedliche Leistungsdichten hervorrufen ist aber sowieso unstrittig und trivial. Das zeigt auch schon mal, dass die Simulationen nicht ganz verkehrt sind. Im Übrigen widerspricht das in keiner Weise der Tatsache, dass exakt die gleiche Wärmemenge übertragen wird. Ich glaube du hast da immer noch ein wenig Probleme mit dem Unterschied zwischen Temperaturen (Wirkung) und Energiemengen/Fläche (Ursache). Du stellst hier nur Temperaturen dar und nicht die übertragene Leistung. Diese ist bei sonst gleichen Bedingungen (hinsichtlich Isolation oder eben ohne) völlig unabhängig von der DIE-Fläche. Die übertragene Leistung entspricht unabhängig von der DIE-Fläche und der sich einstellenden Temperaturverteilung immer der eingespeisten elektrischen Leistung minus den Verlusten an die Umgebung, welche man durch Isolation bzw. Vermeidung von Konvektion um das DIE-Sim minimiert. Die Temperaturverteilung zeigt lediglich an an welcher Stelle welche Energiemenge übertragen wird. Über die gesamte Übertagungsfläche ist sie immer identisch, wenn eingespeiste Energie und Abfluss in die Umgebung gleich bleiben ;).Die Unterschiedliche Temperaturverteilung ist btw ja der Grund dafür, dass ein und derselbe Kühler auf unterschiedlichen CPUs unterschiedlich effektiv sein kann. Das kann dann besagte Unterschiede im Ranking ausmachen, wenn unterschiedliche DIE-Flächen simuliert werden.Das Flächenverhältnis in den Beispielen von 192/624mm² ist aber etwas extrem gewählt – oder ist das ein Tippfehler in den Bildern? Gibt es überhaupt ein DIE mit 26x24mm Kantenlänge? Selbst ein Thuban hat “nur” 346mm² DIE-Fläche. Größere DIEs sind mir eigentlich nur von GPUs bekannt…Lediglich der Einfluss der Isolation kommt mir bei den Bildern etwas gering vor. Welche Wärmeleitfähigkeit hast du für das Isoliermaterial angesetzt und welche Konvektionsbedingungen hast du für den nicht isolierten Fall angesetzt?Was die geringen Unterschiede bei der Temperaturverteilung hinsichtlich den Core-Dicken angeht, ist das auch zu erwarten gewesen. An der Energiebilanz ändert auch das natürlich ebenfalls nichts. Eine größere Core-Dicke homogenisiert eben einfach die Temperatur der DIE-Fläche besser. Allerdings sieht man teilweise auch, dass die Tempsensor-Bohrung das Temperaturfeld sichtbar verzerren kann. Das lässt sich leider kaum vermeiden.Ohne die verwendeten Wärmeleitfähigkeiten, die Info ob hier ein Schnappschuss aus dem Aufheizvorgang oder ein stationärer Zustand vorliegt und wenn es ein stationärer Zustand ist, welche boundary conditions bezüglich Wärmeabfuhr angesetzt wurden ist das alles rein qualitativ. Im Übrigen ist ein Simulation grundsätzlich erst vollständig wenn sie experimentell validiert wurde ;). Dass das alles aber auch schon rein qualitativ so gut hin kommt hätte ich gar nicht gedacht :). Die Bilder bestätigen eigentlich recht gut, dass wir alles richtig gemacht haben im Hinblick auf unsere Zielsetzung :d:

-

18. Oktober 2010 um 17:10 Uhr #866767

[LE]Al_bundy

TeilnehmerSchriftfehler: Anstatt 26×24 meine ich 16×24. Fehlerteufel!

Weitere Angaben und Bilder heute Abend. Dazu noch einiges am Rand. Vieles legst du wohl so aus wie es dir passt bzw. sind nur Mutmaßungen. Das ihr mit eurer Wahl nichts großartig falsch gemacht habt steht außer Frage!

Jedoch einige Aussagen und Ansichten passen halt einfach nicht, auch wenn Diese Aufgrund von Berechnungsgrundlagen anders aussehen mögen. Die Realität ist oft genug anders als im Reagenzglas oder auf dem Papier. -

18. Oktober 2010 um 18:10 Uhr #866778

VJoe2max